Сергей Кокшаров, SEO-специалист, автор блога devaka.ru, 28 января провел бесплатный вебинар «SEO-аудит своими руками».

Рассмотрели:

✔ Сложности проведения SEO-аудита.

✔ Что анализировать на сайте.

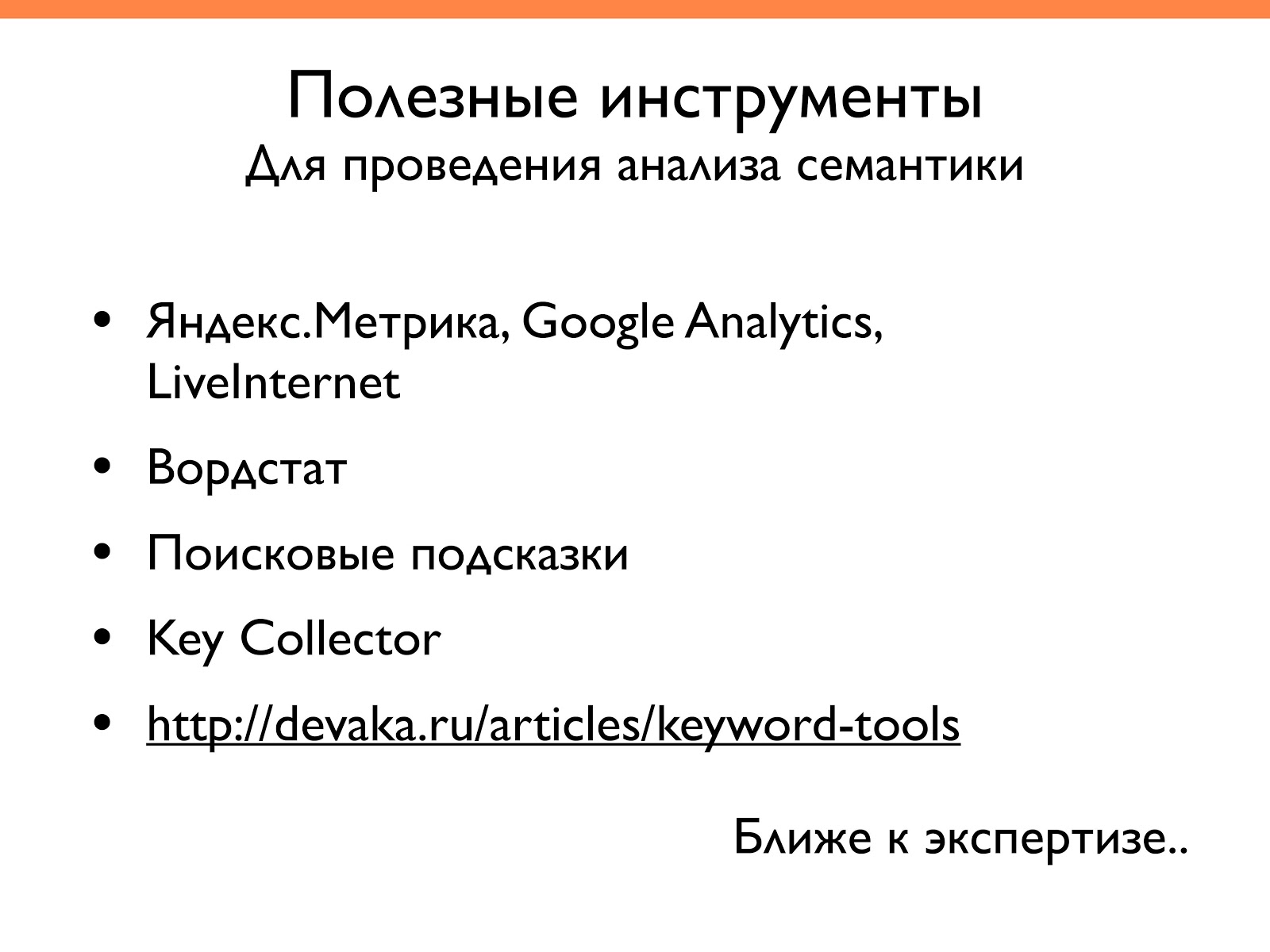

✔ Какие инструменты необходимы для семантического анализа сайта.

✔ Как провести SEO-аудит сайта самостоятельно: основные этапы и часто допускаемые ошибки.

✔ Как облегчить анализ сайта: советы и рекомендации.

Сегодня поговорим о SEO-аудите своими руками и как правильно сделать анализ сайта.

Для чего нужен SEO-аудит

Прежде чем анализировать сайт, нужно понимать какие есть виды SEO-аудита. Я условно разделяю его на более глубокий анализ и поверхностный.

Поверхностный анализ (просто аудит):

- Можно проводить самостоятельно.

- Решает более общие вопросы.

- Часто проверяет наличие стандартных показателей. Есть алгоритм действий, с помощью которого можно проверить и удостовериться, что все в порядке.

Более глубокий анализ (экспертиза):

- Требует опыта.

- Отвечает на узкие вопросы.

- Требует проведение экспертных исследований.

- Часто необходимы нестандартные инструменты, чтобы запрограммировать и проверить ту или иную гипотезу.

То есть более глубокий анализ оптимизации сайта требует больше усилий и не всегда мы можем сделать его самостоятельно.

Если посмотреть на сайт, то аудит отвечает на такие вопросы:

- Все ли корректно с сайтом в техническом плане, в плане оптимизации.

- На какие вещи обратить внимание, чтобы улучшить ранжирование сайта или поисковый трафик.

Экспертиза отвечает на более узкие вопросы:

Как оптимизировать перелинковку для контент-проекта (например, чтобы поднять низкочастотные запросы).

Почему был наложен фильтр и как от него избавится. Здесь нужно знать «куда копать». Например, по какому-то запросу наш сайт слетел, а по всем остальным запросам двигается нормально. В этой ситуации обычным аудитом не обойтись, хотя он может помочь в чем-то наладить взаимодействие сайта с роботом. Узкие вопросы лучше решать со специалистами.

SEO-аудит позволяет найти неиспользованный потенциал сайта и при внедрении улучшить видимость ресурса в поисковых системах, и соответственно позиции и трафик.

Мы будем говорить о проведении именно базового аудита, а не об экспертизе.

О сложностях проведения SEO-анализа

Какие могут быть сложности в проведении SEO-аудита?

- Нужно мыслить аналитически.

- Сложно без опыта или примеров.

- Требуется доступ к ряду инструментов и владение методами анализа. Не всегда у нас есть список этих инструментов либо большинство из них являются платными. Поэтому в компаниях с инструментами легче: они могут позволить себе купить один инструмент на всю компанию и использовать. А если мы частное лицо, то в этом плане сложнее.

- Ориентация в тенденциях, ведь появляются новые алгоритмы, новые подходы к оптимизации и т. д.

Есть такая аналогия, что анализ похож на квест: тебя заводят в комнату и ты должен понять, что сделать, чтобы из нее выбраться. Задания ставятся разные: выявлять взаимосвязи, понимать, какие вещи и на что влияют.

Если мы говорим о сайте, то нужно понимать принцип работы поисковой системы, какие технические аспекты могут влиять на индексацию и т. д.

Несмотря на все эти сложности, мы сегодня рассмотрим ряд примеров, саму методику оценки сайта и, возможно, вам будет проще проводить этот анализ самостоятельно.

Что можно анализировать на сайте

Что анализировать? Куда нужно смотреть? Прежде всего у аудита должна быть цель. То есть мы должны задаться вопросом, для чего мы его делаем. И здесь на помощь приходят метрики эффективности работы и оптимизации сайта.

Я выделил их в 4 группы:

- SEO.

- Юзабилити.

- Бизнес.

- Технические.

На слайде ниже показано, что можно анализировать в каждой метрике эффективности.

Бизнес-метрики (звонки, заказы, продажи, средний чек, конверсии) позволяют понять, все ли нормально с бизнесом. Здесь до SEO и аналитики далеко, но за этими метриками полезно следить.

Параметры юзабилити (количество возвратов, просмотренных страниц, отказов, время, проведенное на сайте, использование внутреннего поиска) влияют как на бизнес-метрики, так и на SEO-метрики. За последний год-два на первый план выходит удобство пользования сайтом и наличия каких-то элементов, упрощающих использование (например, страница 404).

SEO-метрики (трафик, позиции, количество и качество ключевых фраз за период) — одни из самых важных в подобном аудите и позволяют отслеживать качество семантического ядра.

Технические показатели (скорость индексации, количество мусора в индексе, скорость загрузки, корректность кода и ссылок, качество индекса) влияют на трафик. Например, очень важно чтобы индекс содержал только полезные страницы. Дубли, пустые страницы нужно удалять.

Если мы говорим о семантическом анализе, мы в первую очередь подразумеваем технические метрики и SEO-метрики.

Юзабилити важно, но если мы проводим анализ впервые, то здесь нужен просто здравый смысл. Например, сейчас на развитие сайта влияют еще и коммерческие факторы: наличие прайса, детальная страница контактов, сертификаты и т. д. Они говорят о том, что за сайтом стоят реальные люди. Их также полезно отслеживать, но как метрики они сложно поддаются типичному анализу.

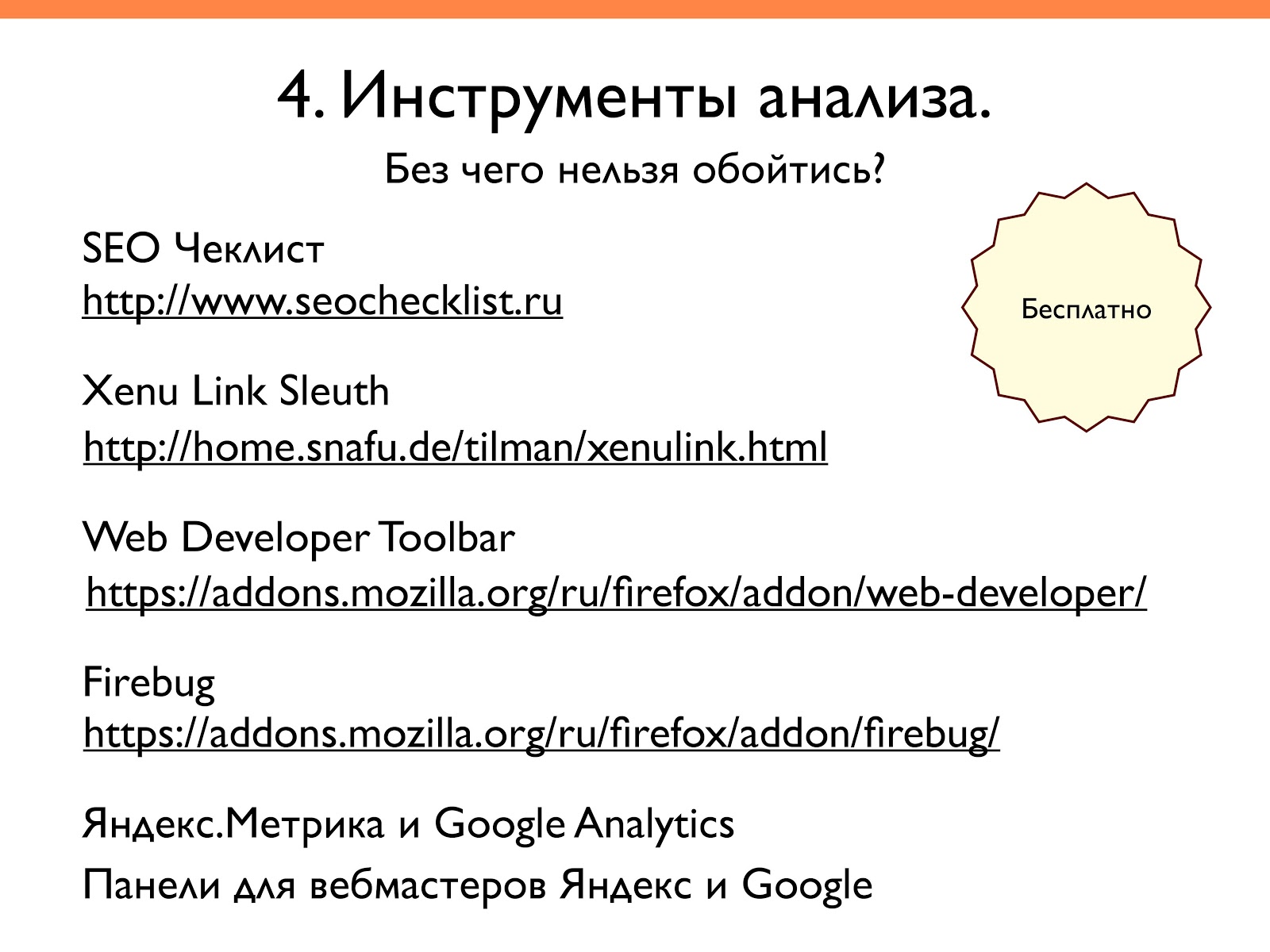

Бесплатные инструменты анализа

Сегодня ни один SEO-специалист не может обойтись без специальных инструментов. Они могут быть бесплатные и платные. Начнем с доступных всем.

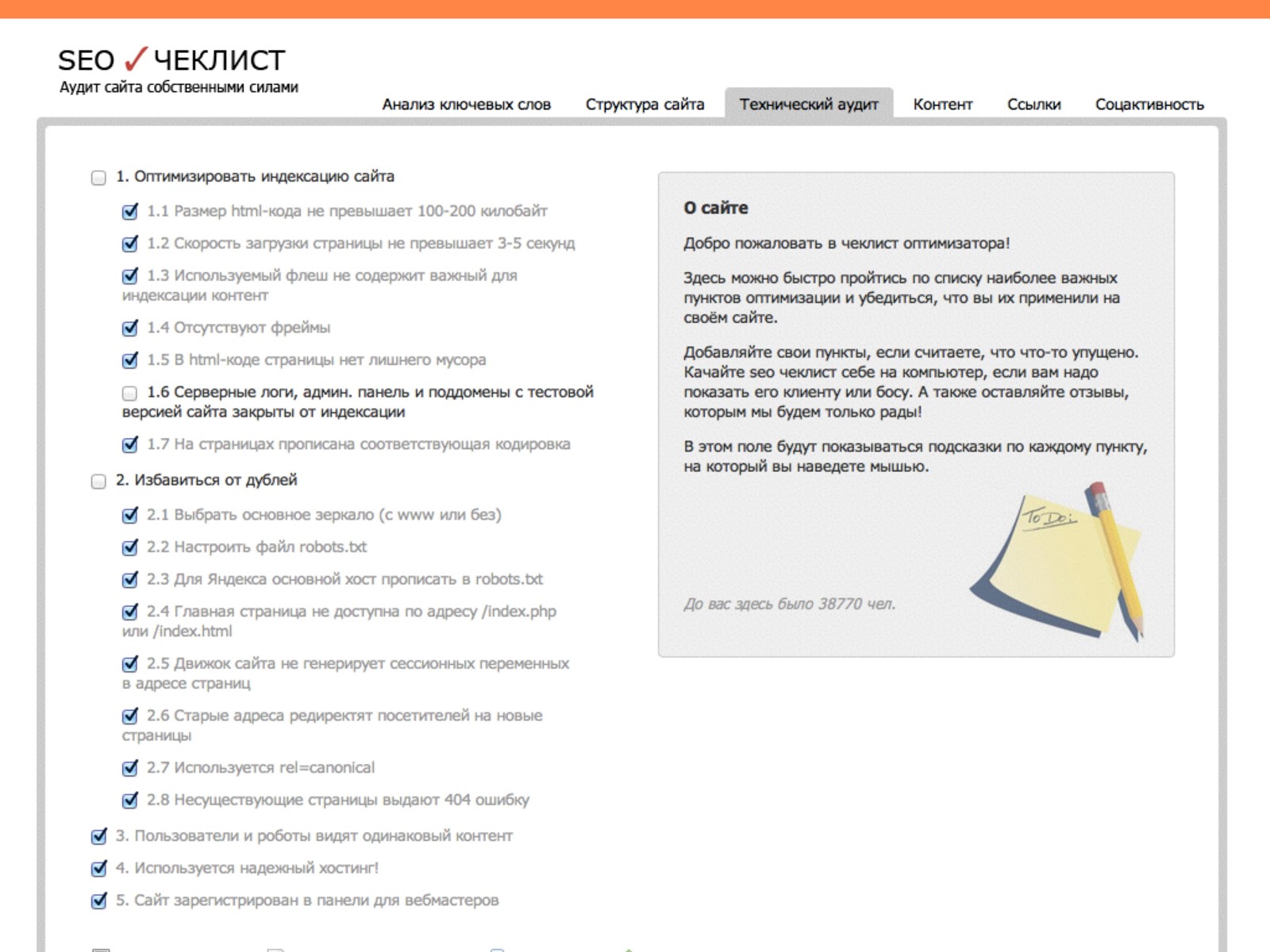

SEO Чеклист — это список пунктов, разделенный по группам на технический анализ, внутренний анализ, внешний аудит сайта, внешнюю оптимизацию. Можно прямо на сайте отмечать, что сделано, что не сделано, на что стоит обратить внимание, добавить свой пункт. Полезный инструмент, который работает как напоминалка.

Xenu Link Sleuth — это парсер сайта. Он проходится по всем адресам и сохраняет какую-то статистику. В отчетах вы можете видеть много различных технических характеристик начиная от размера документа, http-заголовков и заканчивая размещением битых ссылок, типом кодировки. Здесь вы получите много полезной технической информации совершенно бесплатно.

Web Developer Toolbar — это плагин Firefox, Google Chrome с большим функционалом.

Firebug — полезный плагин для технического анализа. Можно отслеживать скорость загрузки страниц, увидеть какие элементы скриптов занимают больше всего времени при загрузке.

К бесплатным инструментам относятся также Яндекс.Метрика, Google Analytics, где мы можем получить много данных, не используя дополнительные инструменты.

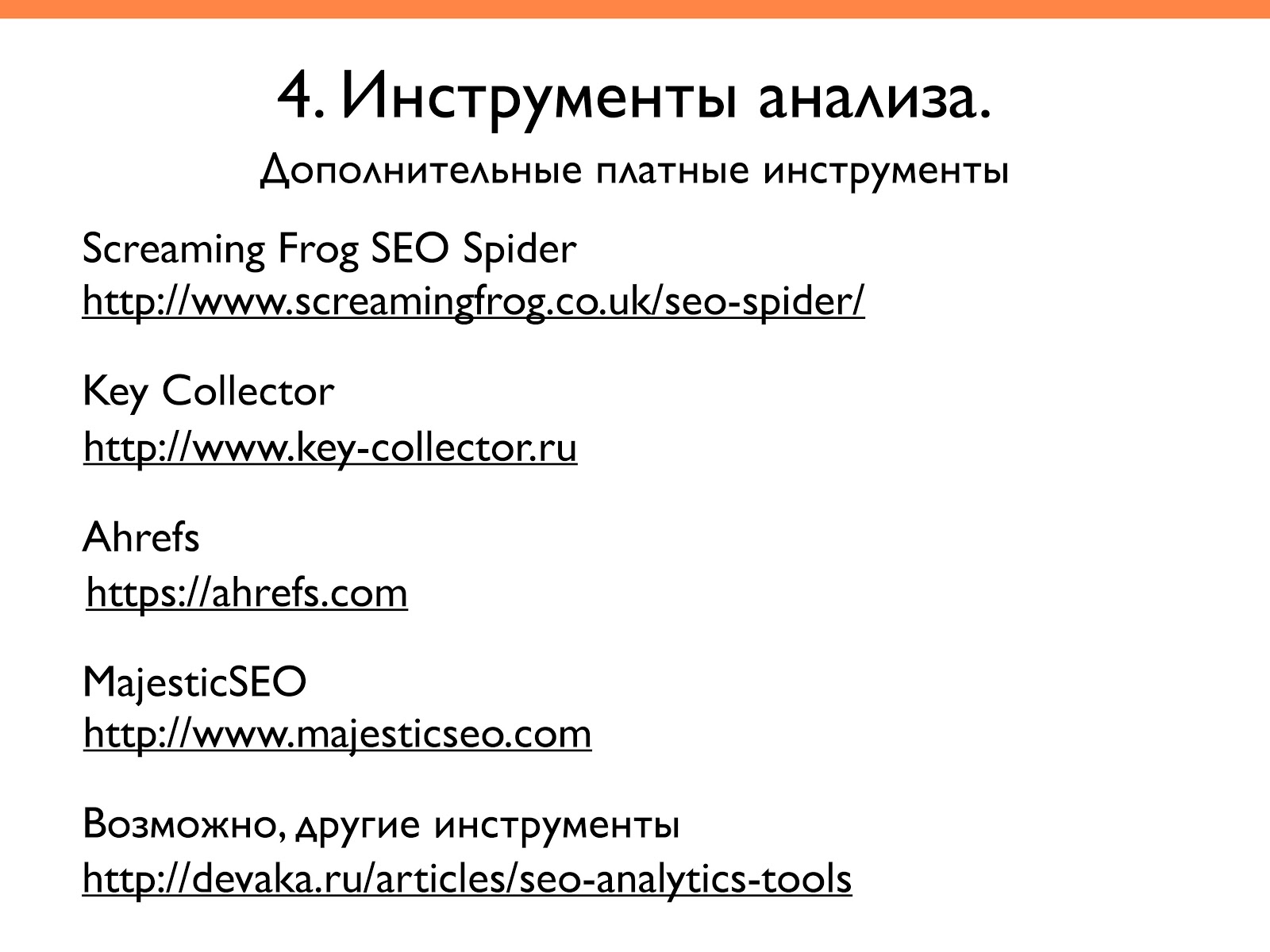

Платные инструменты анализа

Также есть платные инструменты. Приведу те, которые сам использую на практике.

Screaming Frog SEO Spider — похож на Xenu Link Sleuth, но здесь более богатый функционал, можно вводить различные фильтры, настройки.

Key Collector — помогает работать не только с семантикой, но анализировать поисковые запросы. Функционал его постоянно расширяется.

Ahrefs — онлайн-сервис, где можно анализировать ссылки сайтов. Причем не только их количество, но и качество: какие новые появились, какие устарели и т. д.

Majestic SEO — аналог Ahrefs по анализу ссылок, но здесь представлена больше зарубежная база.

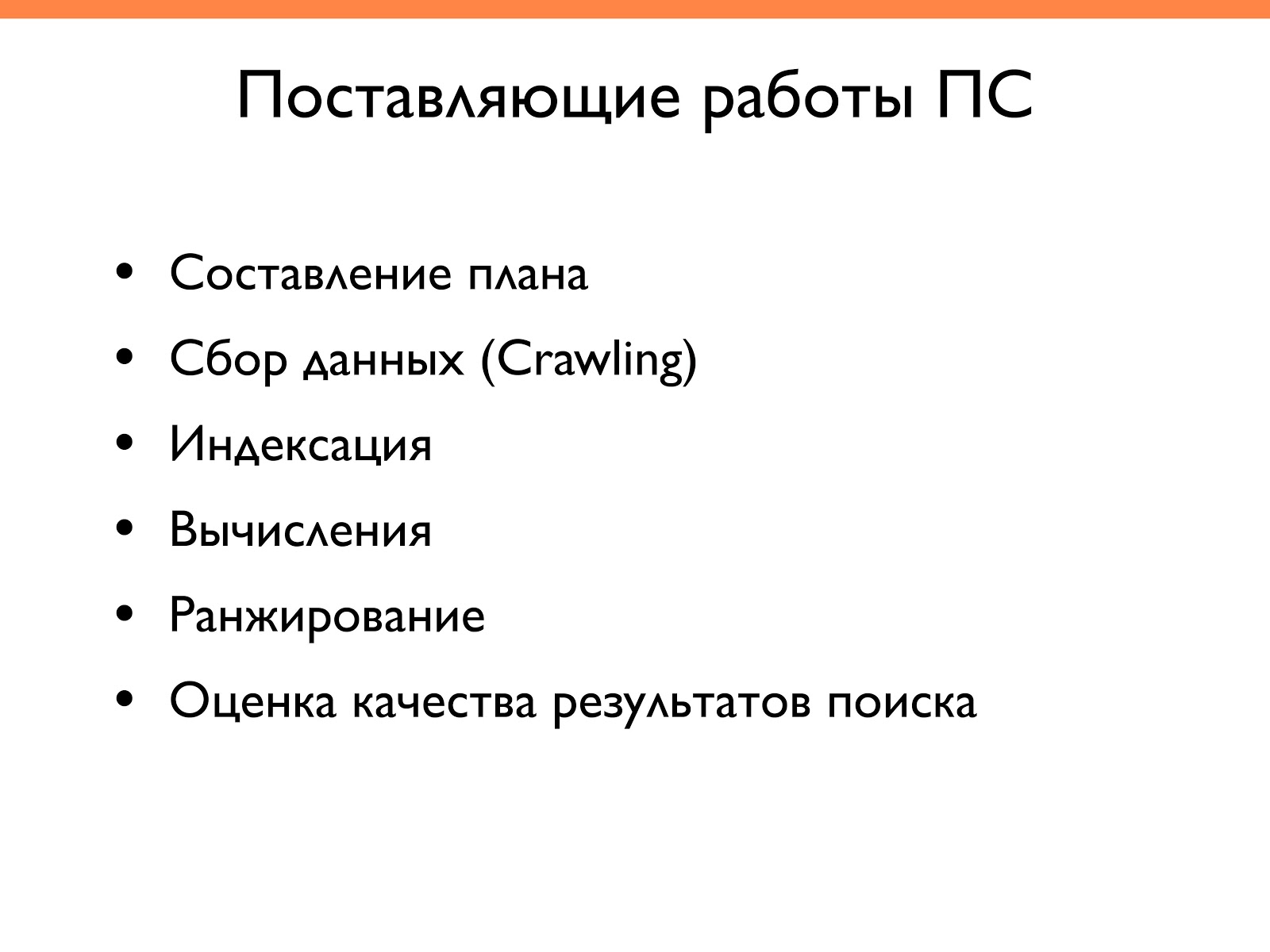

Как работает поисковая система

Прежде чем перейдем к этапам аудита, расскажу вкратце как работает поисковая система. Потому что когда мы говорим о SEO-анализе сайта, мы должны это понимать.

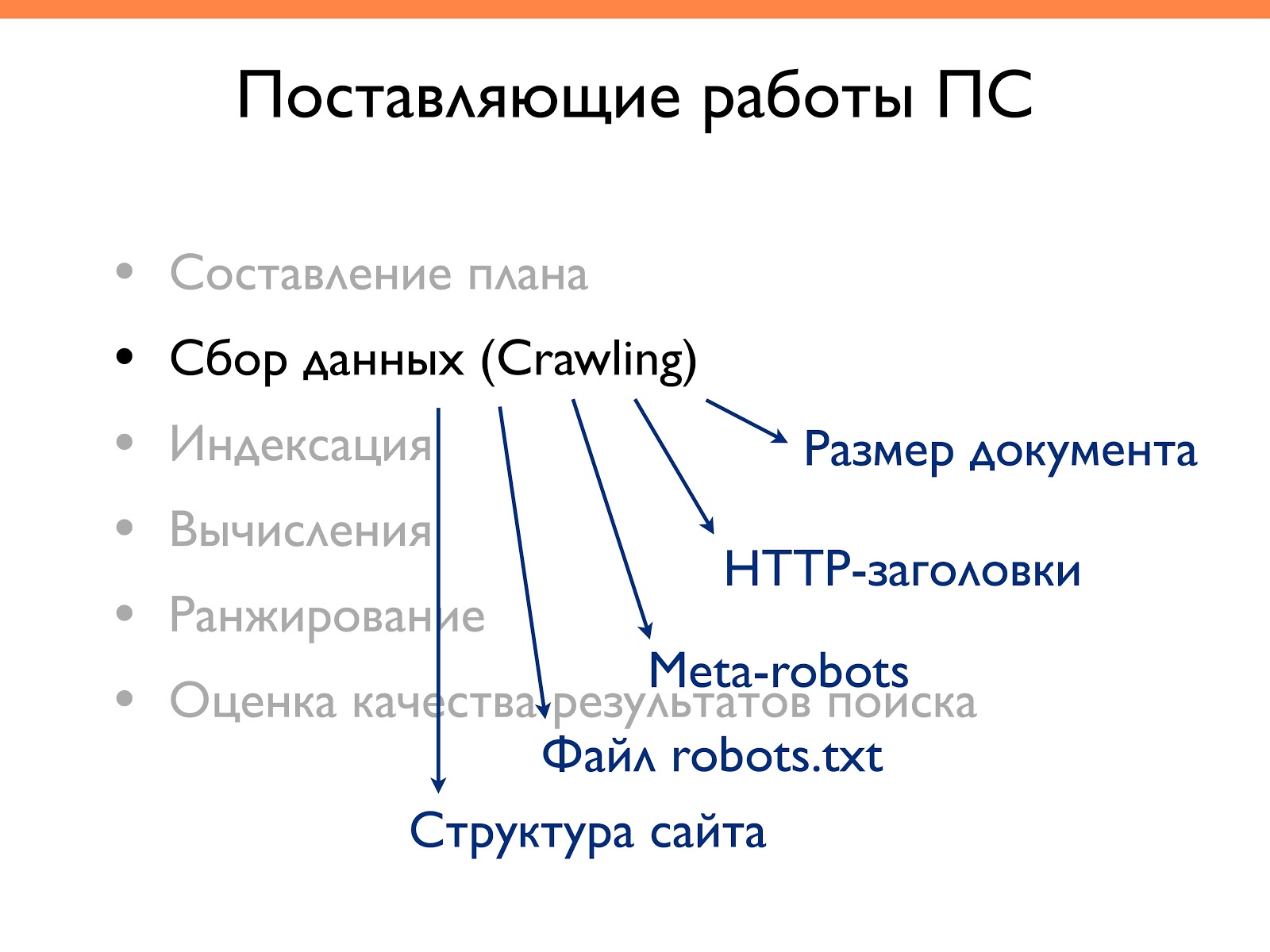

Составляющие работы поисковой системы следующие:

- Составление плана. Это предварительный этап, где составляются списки. Чтобы попасть в этот список, нужно где-то ссылку поставить, упомянуть о сайте либо зайти с браузера с установленным поисковым toolbar.

- Сбор данных (Crawling). Здесь поисковик ходит по заданному списку и собирает технические данные.

- Индексация. Это построение текстового индекса исходя из ссылочного профиля и каких-то дополнительных параметров (ключевого слова, позиции т. д.).

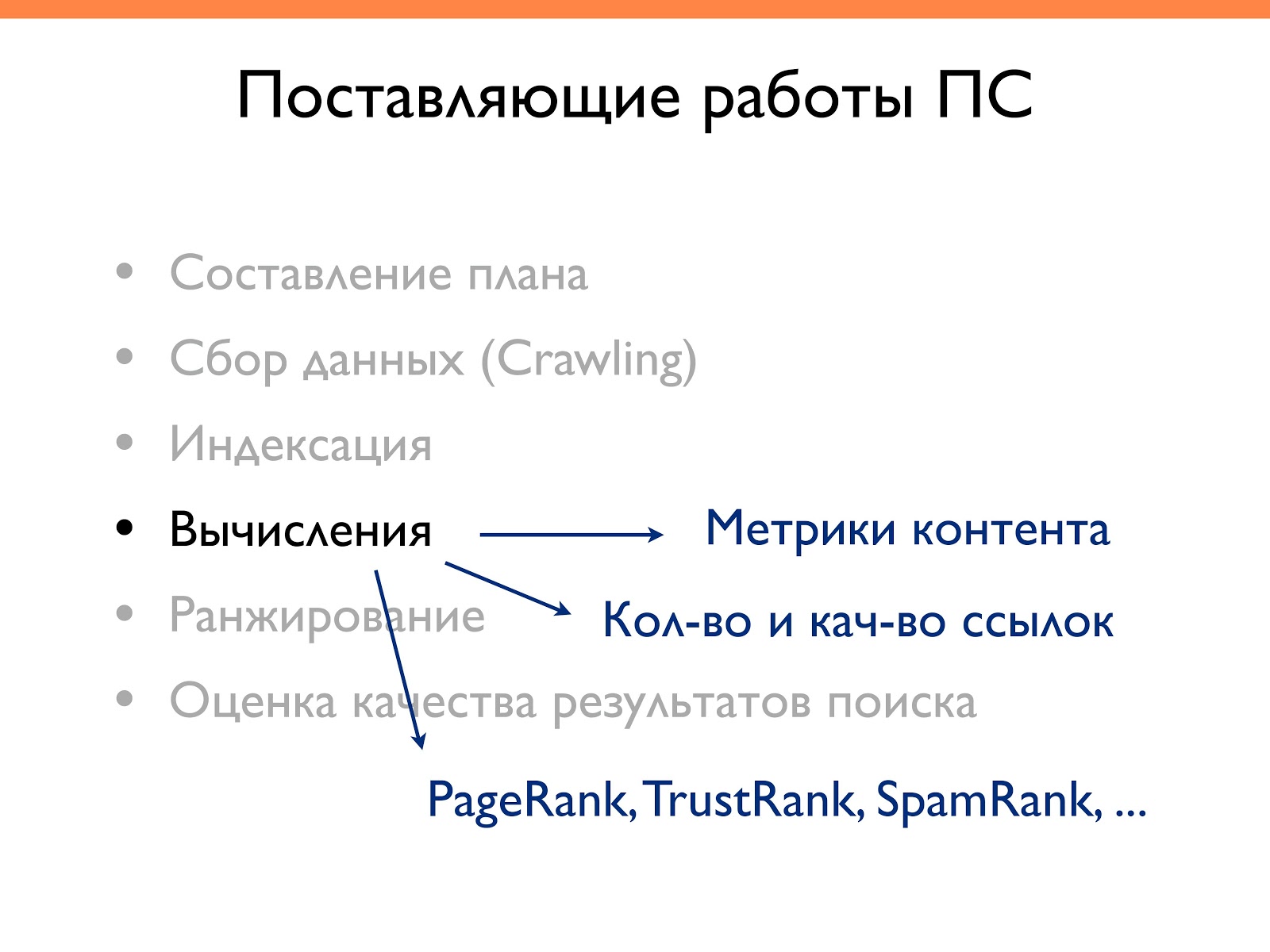

- Вычисления. На основе индексов и составленных ссылочных графов происходят различные вычисления, например PageRank, ТИЦ, TrustRank, SpamRank. То есть все ранки, которые участвуют в формулах ранжирования.

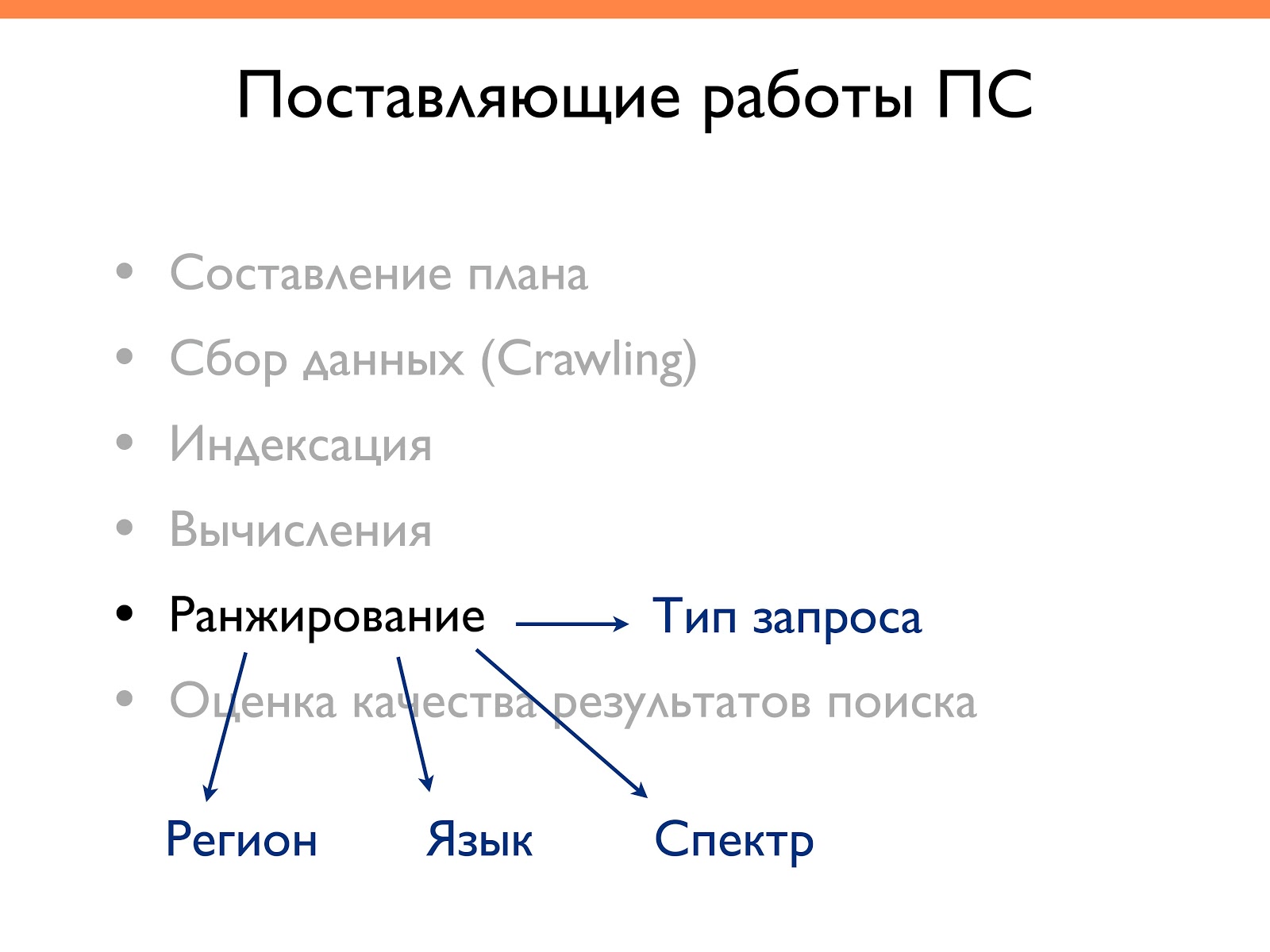

- Ранжирование. Сортировка результатов на основании поисковых запросов пользователей.

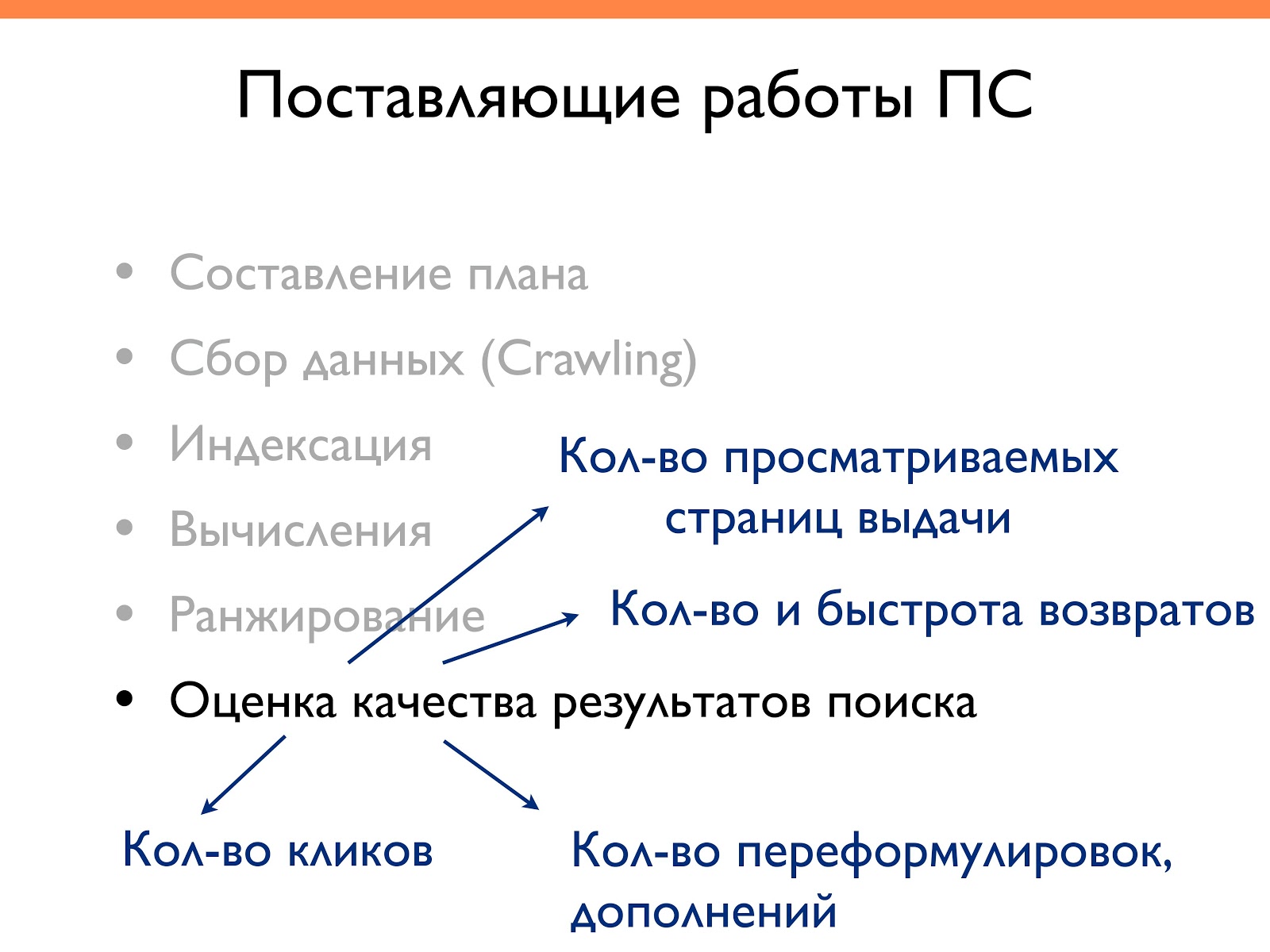

- Оценка качества результатов поиска. Поисковику важно отследить был ли этот поиск полезен пользователю или нет. Поэтому анализируется количество кликов на каждый из вариантов показа, количество возвратов, то есть на какое время зашел пользователь на конкретный сайт и через сколько он вернулся. Все эти поведенческие характеристики показывают поисковой системе на сколько хорошо она дала ответ на вопрос пользователя. Это важный этап, так как мы можем на это влиять.

Рассмотрим более подробно основные пункты.

Сбор данных

В процессе сбора данных (Crawling) важно настроить оптимальное взаимодействие сайта с роботом, чтобы он быстро находил нужные документы. Например, если количество уровней страниц большое, то робот туда не сразу доберется. А если надо будет переиндексировать эти страницы, то может пройти полгода/год в зависимости от степени вложенности страниц и размера сайта.

Поэтому важно следующее:

Размер документа — чем меньше размер документа, тем быстрее поисковик обрабатывает эти данные.

HTTP-заголовки — здесь надо указывать кодировку, размер документа, код ответа сервера.

Meta-robots — можно настроить индексацию отдельных документов.

Файл robots.txt — отвечает за управление индексацией.

Структура сайта — организация ресурса влияет на сбор данных, так как определяется приоритет тому или иному кластеру/разделу.

Вычисление

На этапе вычисления важны:

- Метрики контента, то есть сколько раз ключевое слово встречается на странице, общий объем контента.

- Количество и качество ссылок, ведущих на конкретный документ.

- PageRank,TrustRank, SpamRank, то есть позиции ранжирования.

Ранжирование

На этапе ранжирования учитываются:

- Регион — как сайта, так и пользователя, который вводит запрос. При проведении аудита важно проверять какой регион присвоен сайту, из каких регионов заходит аудитория. Например, если мы продвигаем по региону Казахстан, а основная аудитория — это Россия, значит, качество аудитории не соответствует и надо что-то менять.

- Язык — это настройки браузера либо язык, на котором пользователь вводит запрос, либо история поиска. Например, если пользователь всегда вводил на английском, а потом ввел на русском, ему чаще будут показываться результаты на английском.

- Тип запроса — влияет на результат. Например, по коммерческим вопросам будет одна формула ранжирования, по информационным — другая, по новостным запросам — третья и т. д.

- Спектр запросов — общие, коммерческие и т. д. Например, под общим запросом поисковик выделяет группы, так как он не знает что человек искал. Допустим, вы ввели «Майкл Джексон». Поисковик не знает, что вы хотите: послушать песни, почитать биографию, посмотреть интервью, узнать новости. Поэтому предоставляет различный спектр: и то, и другое, и третье. По коммерческим запросам может выдавать интернет-магазины, различные обзорники, прайс-агрегаторы, форумы.

Оценка качества результатов поиска

Оценка качества результатов это:

Количество кликов — если на ваш сайт стали меньше кликать или, вообще, не кликают в выдачи, то со временем его позиции будут снижаться, так как поисковику не интересно держать в топе те сайты, на которые никто не кликает. Поэтому важно обращать внимание на сниппеты, на то как оформлен сайт в выдаче.

Количество переформулировок, дополнений — если пользователь дополняет свой запрос и углубляет свой поиск, поисковик понимает, что что-то не то с результатами выдачи.

Количество и быстрота возвратов, то есть как часто и с какой периодичностью человек возвращается обратно на сайт. Например, зашел человек на сайт такси и через несколько минут вышел. Снова пошел в выдачу поиска искать другой ресурс с такой же услугой. Это значит, что ему что-то не понравилось либо он не нашел контакты, либо сайт не работает, либо он позвонил, а ему сказали что машин нет. Это очень влияет на качество выдачи.

Количество просматриваемых страниц выдачи — чем больше человек просматривает страниц, тем хуже поисковик определяет качество выдачи страниц. На одной из конференций Яндекса договорились, что оптимальный вариант — выбор первого результата. Если он выбрал не первый, то что-то здесь уже не так, то есть мы уже неправильно отвечаем на запрос пользователя.

Виды аудита

Я разделяю аудит на такие виды:

- Технический — осмотр технических параметров.

- Внутренний — анализ внутренних факторов сайта (контента, внутренних ссылок).

- Внешний — анализ внешних ссылок, отзывов о сайте, упоминаний.

- Оценка семантики — анализ ключевых слов, семантического ядра.

- Анализ структуры сайта — связан с семантикой, смотрят насколько сайт удобен по структуре, как индексируется, как можно оптимизировать и т. д.

Возможно, стоит сюда включить еще анализ коммерческих факторов. Я здесь о нем не упоминаю, но если в двух словах, то надо посмотреть есть ли страница контактов, карта проезда к офису, время работы офиса. Хорошо иметь на сайте страницу вакансий, о нас, правила использования (если информационный проект) и дополнительные страницы, которые могут говорить, что за сайтом стоят реальные люди, организация. Можно выложить сертификаты — это поисковик также смотрит и дает больше доверия.

Посмотрим, как происходит оценка сайта на каждом этапе.

Технический аудит

На этапе технического аудита мы анализируем:

- Код сайта.

- Скорость загрузки страниц. Есть инструменты от Google (PageSpeed Insights), но можно использовать другие.

- Объем страниц. Здесь сравниваем страницы между собой. Если есть какие-то одинакового объема, то могут быть дубли. Если маленький объем страниц, значит, они малоинформативные.

- HTTP-заголовки.

- Robots.txt и meta-robots.

- Оптимизация под мобильные устройства. Проверять нужно обязательно.

Провести технический аудит сайта нам помогут полезные инструменты, которые вы можете видеть на слайде ниже:

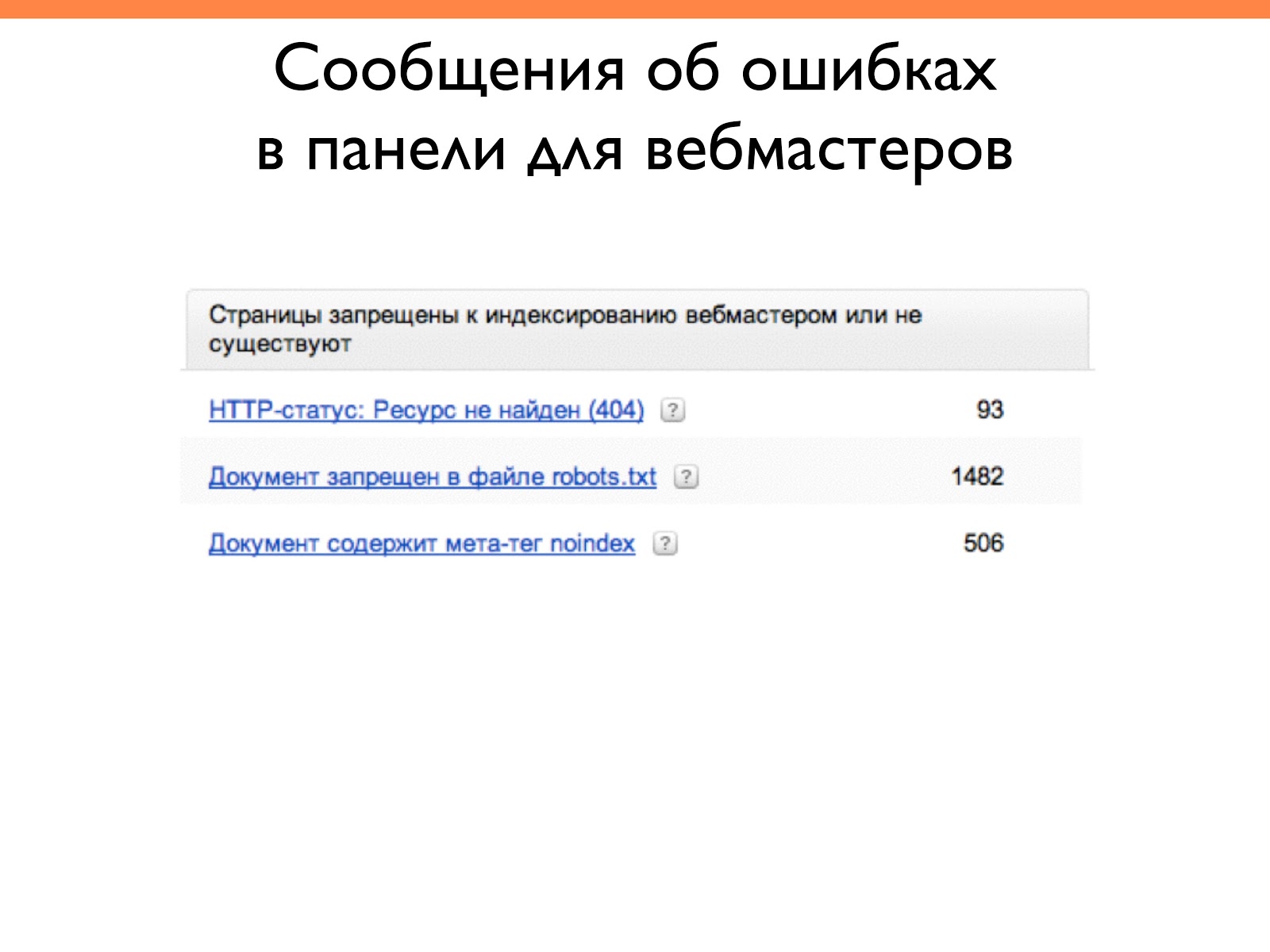

С панели для вебмастеров можно посмотреть, какие чаще всего возникают ошибки и сразу их исправить.

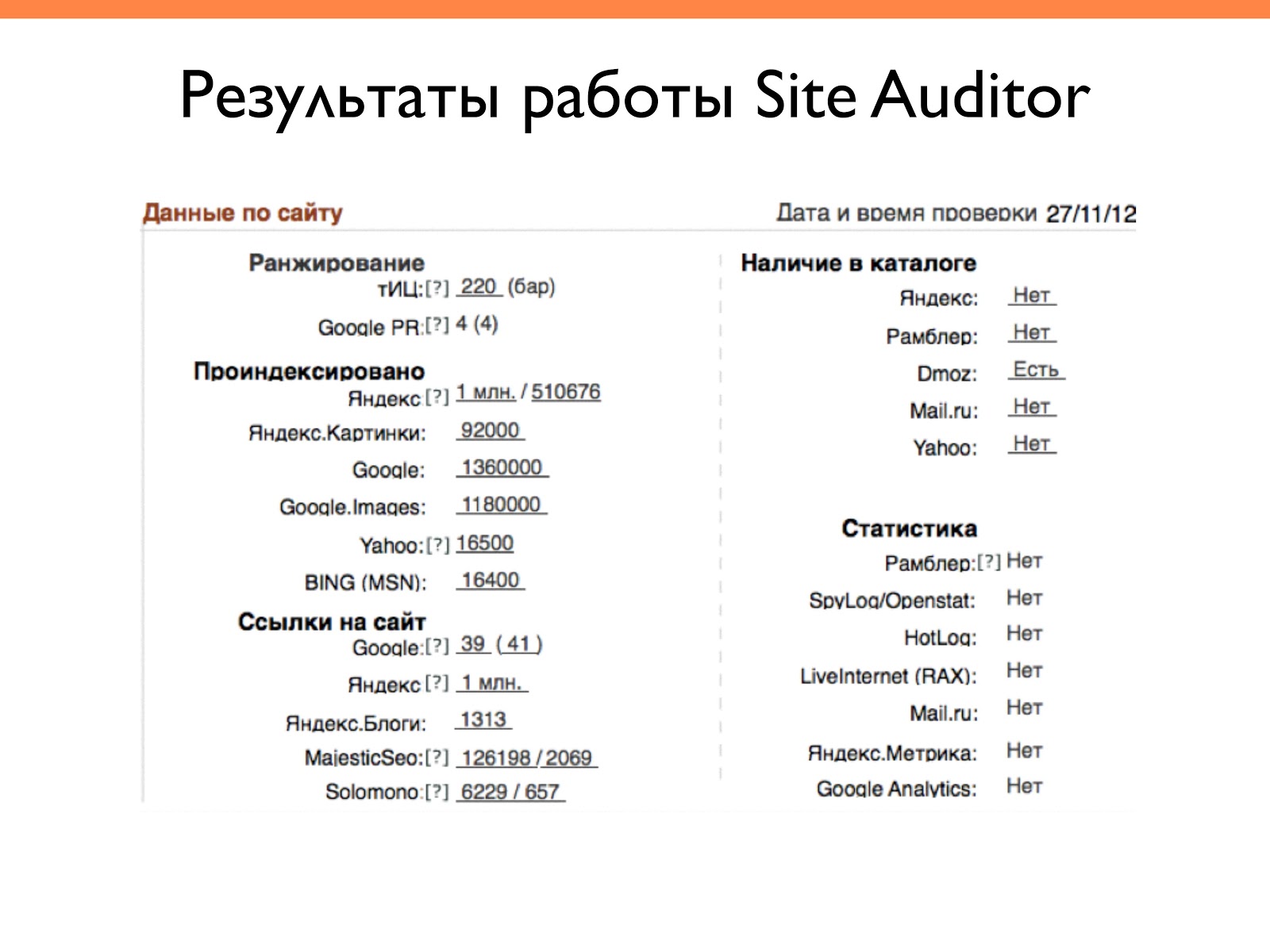

Это результат работы Site Auditor. Он сканирует различные параметры и показывает общую статистику. Например, сколько в индексе страниц, есть ли сайт в каталоге. То есть — это общие данные, которые полезно знать и использовать, анализируя свой сайт или конкурентов.

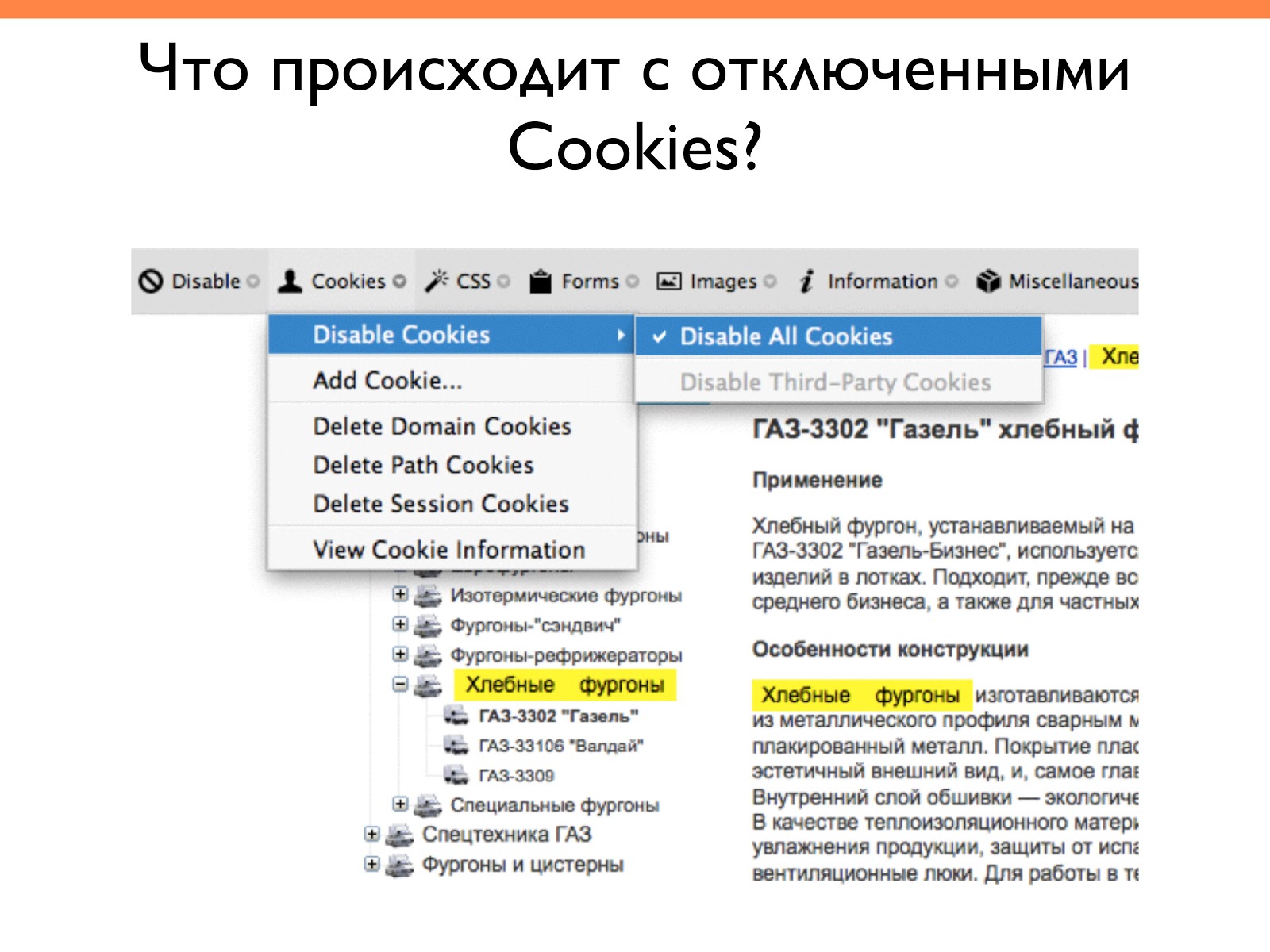

А это пример работы Web Developer Toolbar. С его помощью мы можем отключить куки, изображения, скрипты и посмотреть, как сайт выглядит без этого. Функционал широкий.

На слайде показано, как выглядит страница с отключенными куками, то есть так, как видит ее робот. Но в нашем случае, оказалось, что левое меню зависело от куков. То есть если человек открыл его, то оно было в коде, если человек закрыл, то, соответственно — не было. Ссылок для поисковика было меньше, чем для пользователя. Этот полезный инструмент помог нам это отследить.

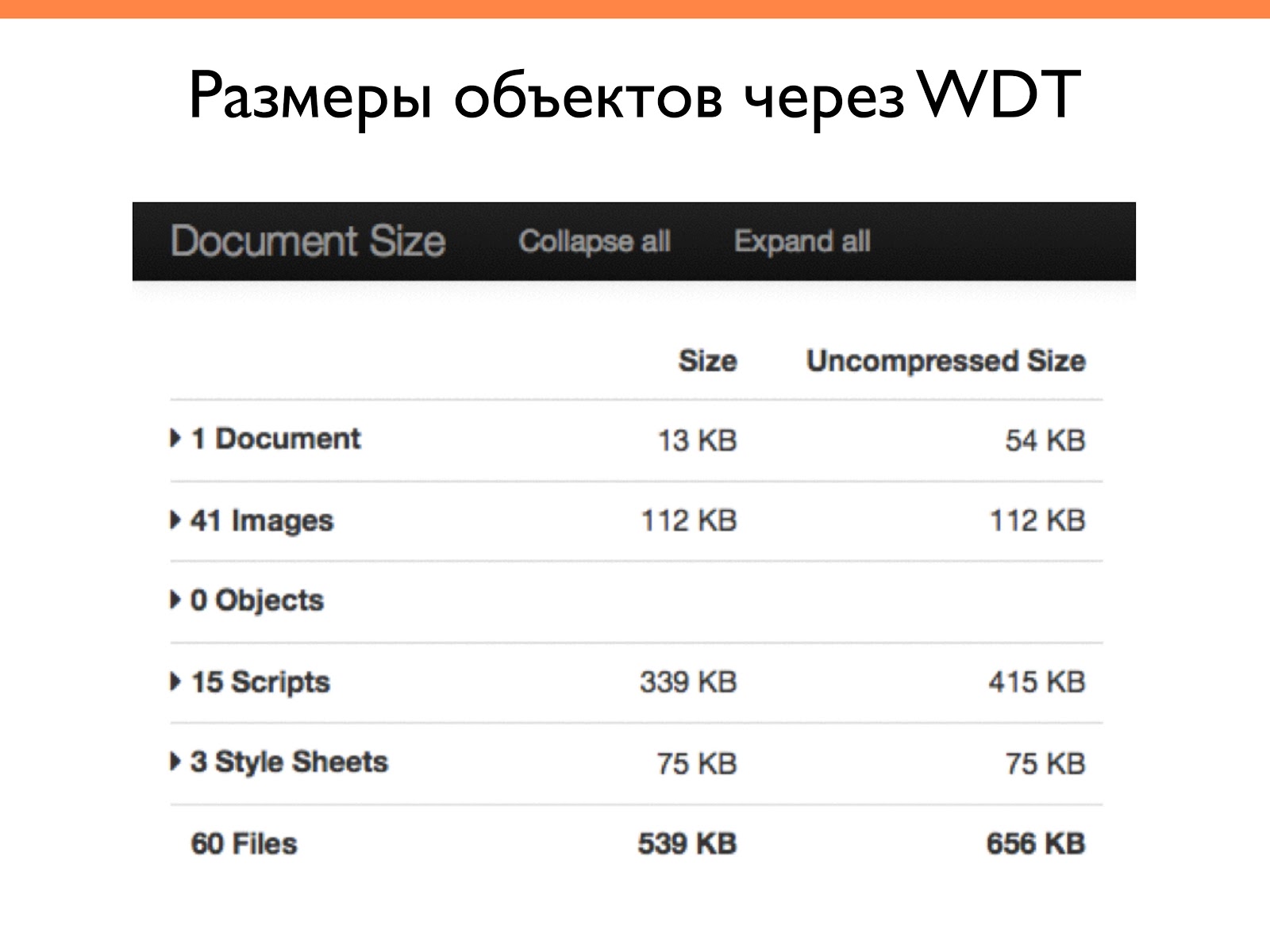

Это также работа Web Developer Toolbar, только другая функция: посмотреть размер документа. Она показывает общую статистику как по всему документу, так и для отдельных составляющих, таких как изображения, скрипты и т. д.

На примере видно, что 15 скриптов занимают больше всего места. И здесь можно уже думать об оптимизации этих скриптов — слиянии или каком-то сжимании.

Часто допускаемые ошибки в техническом аудите это:

- Плохой хостинг — одна из технических проблем, которая влияет на продвижение. Даже если у вас неплохой хостинг, обязательно проверяйте в час пик и ночное время скорость загрузки страничек.

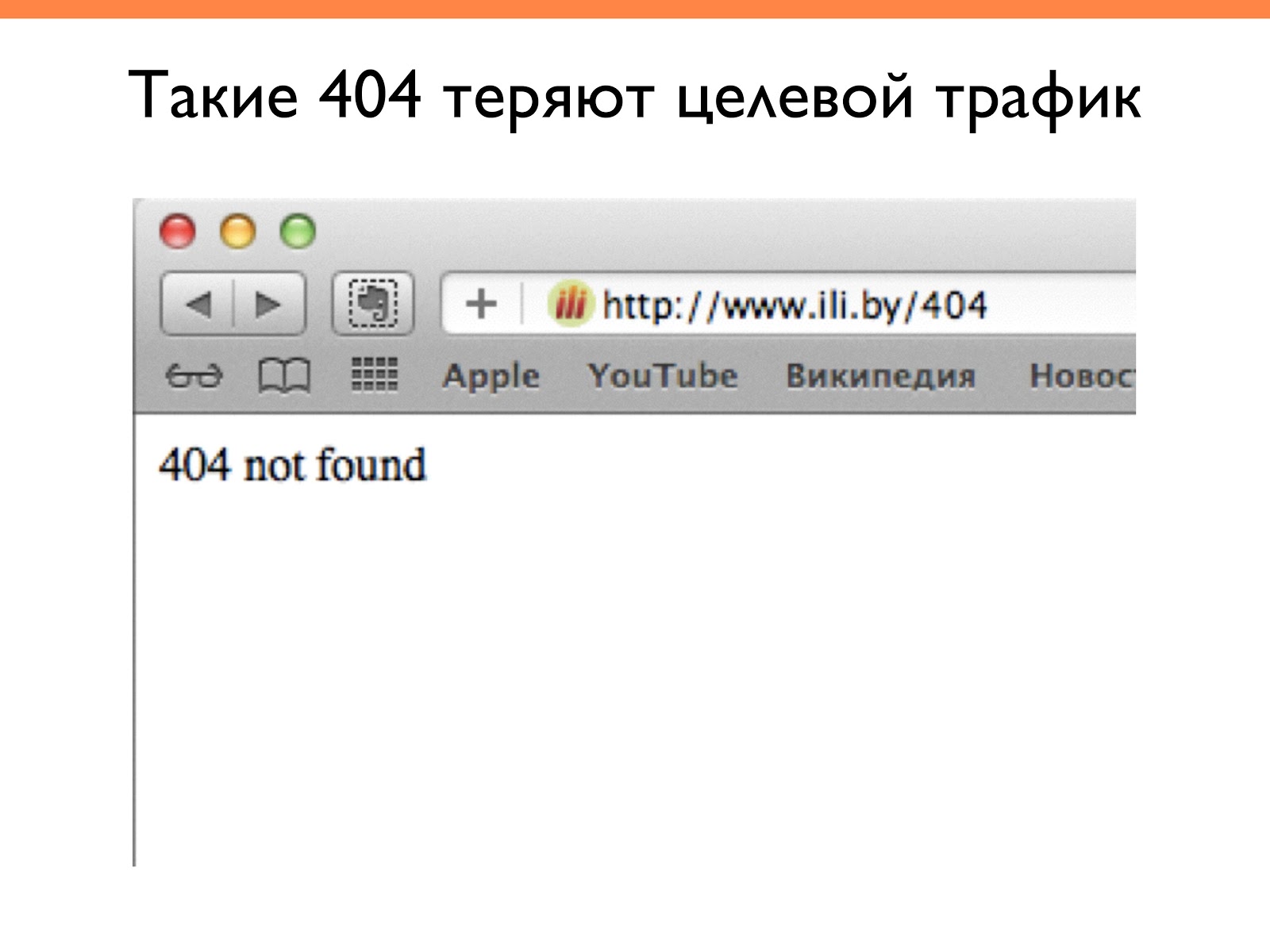

- Отсутствие 404 страницы. Многие ее не используют, хотя поисковики часто запрашивают эту страницу, смотрят и анализируют, что на ней находится.

- Отсутствие мобильной версии.

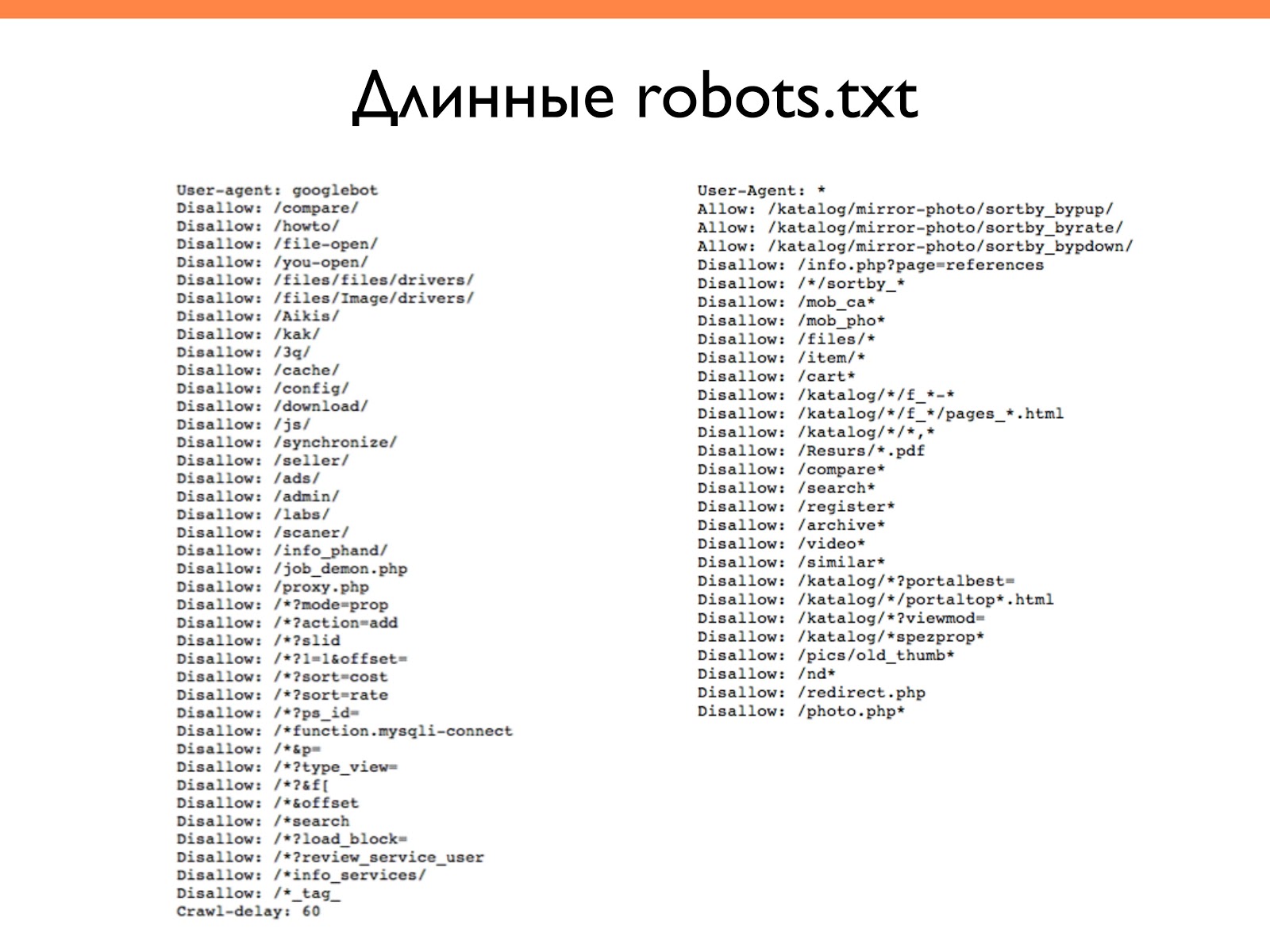

- Большой robots.txt для Google.

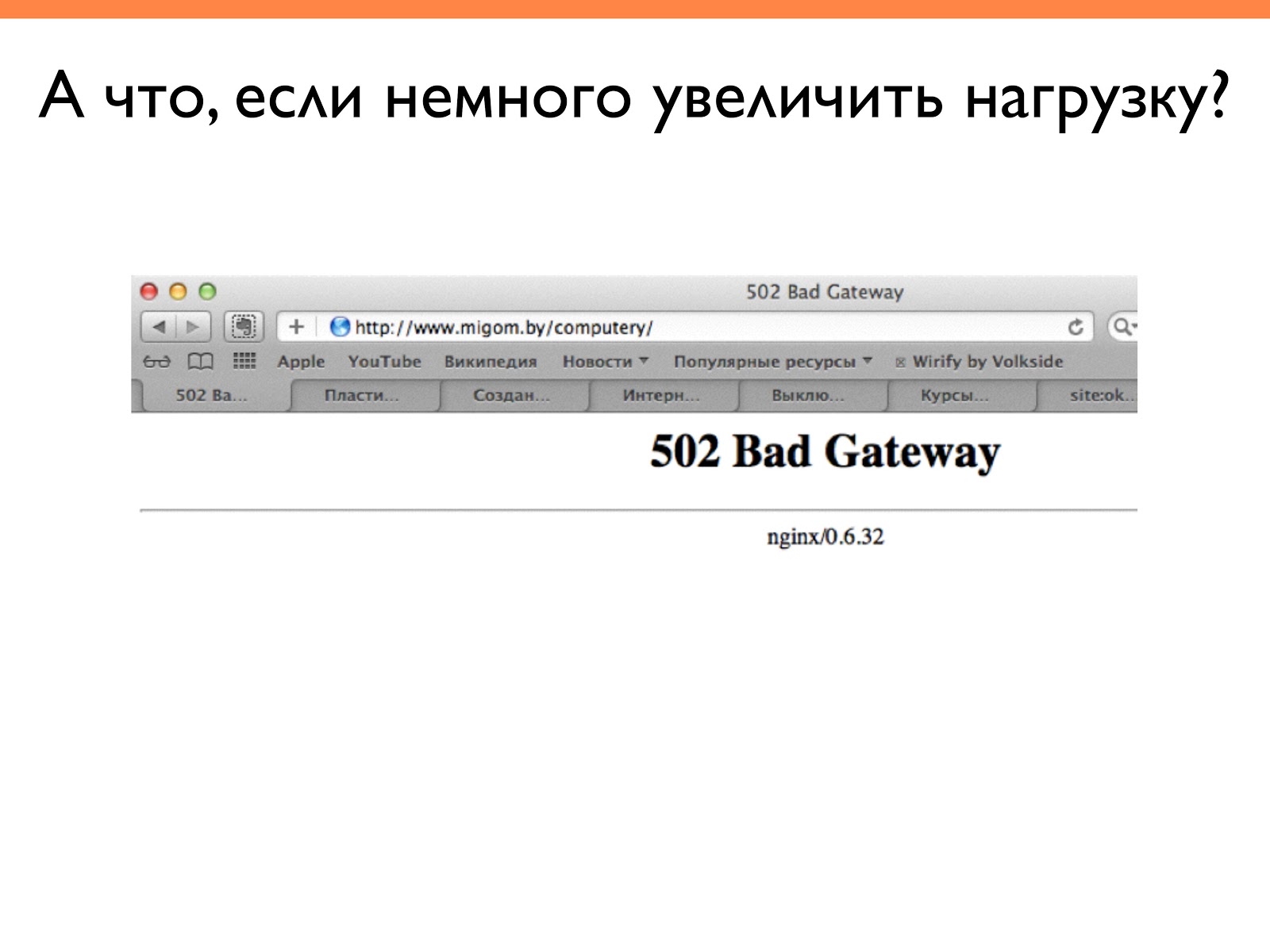

Сейчас покажу почему большой robots.txt для Google — зло. На слайде показано, что когда мы начали чаще вводить страницы этого сайта, он начал отдавать 502 ошибку. То есть работал не стабильно. Поисковик также видит такие ошибки, и, со временем, страницы могут выпадать.

Пример отсутствия 404 страницы. Здесь есть текст, что страница не найдена, но подобная страница не улучшает поведенческие и SEO факторы. Поисковик ничего не найдет, а это очень плохо.

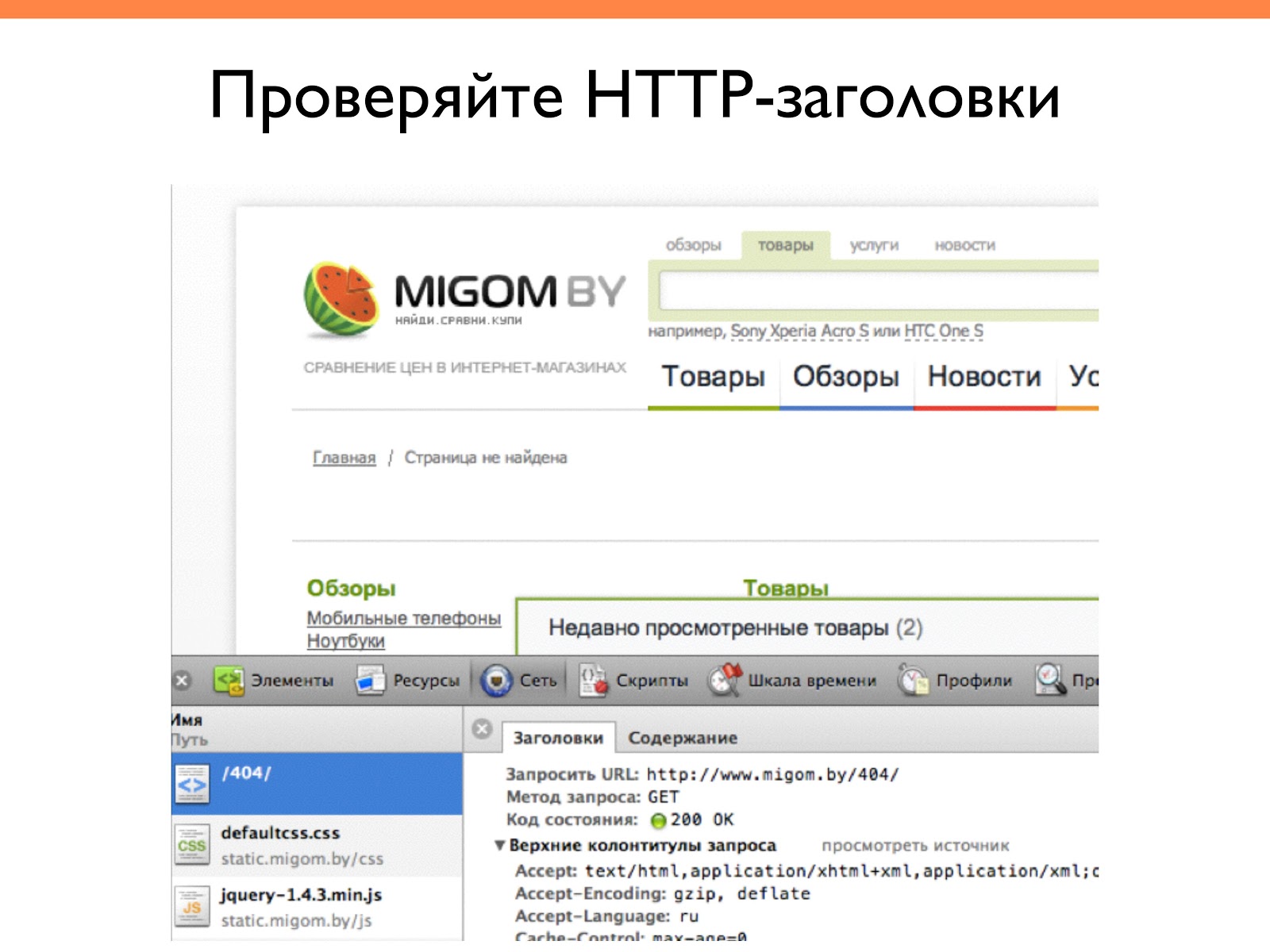

Здесь была запрошена 404 страница для проверки HTTP-заголовков. Выдало код состояния 200, то есть индексацию поиском. Это одна из частых ошибок, когда мы не проверяем коды статусов и в индекс попадает много мусорных страниц.

Конкуренты могут использовать это в своих целях, проставляя ссылки на несуществующие страницы, и таким образом, повышая их рейтинг по сравнению с тем, что вы продвигаете.

Длинные robots.txt выглядят примерно так. Может быть, многие из вас это используют.

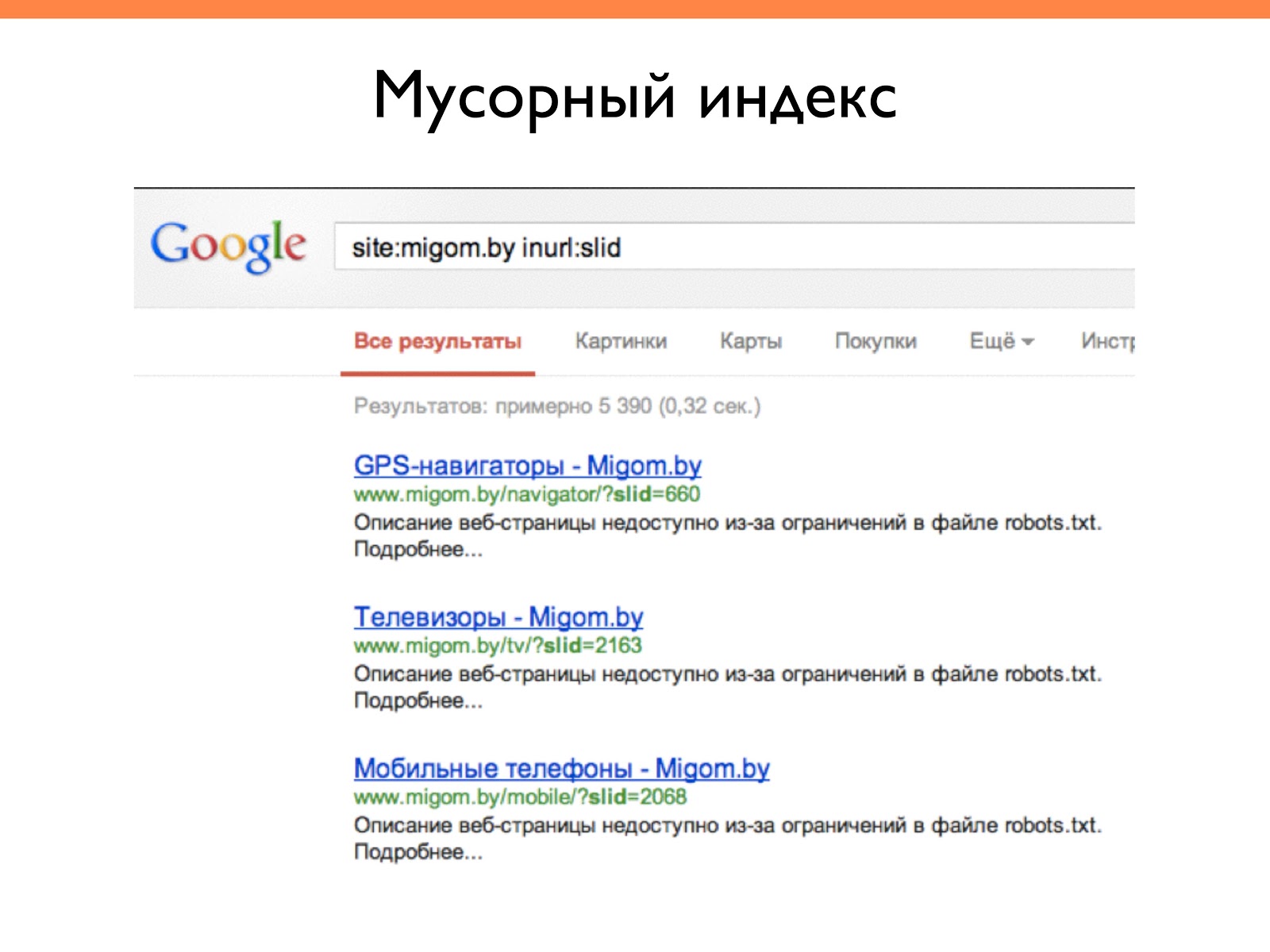

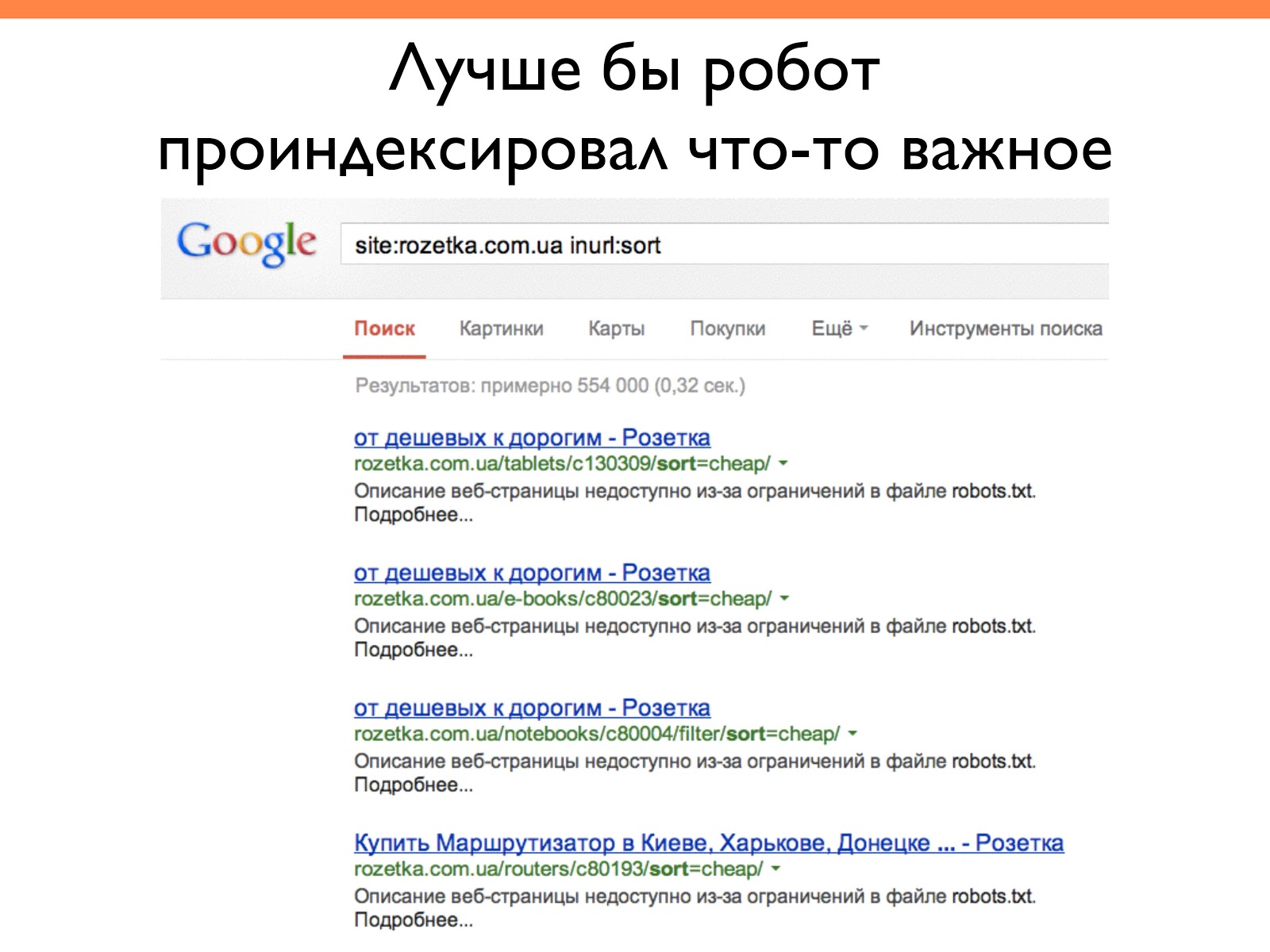

Это приводит к засорению индекса. Google воспринимает robots.txt как рекомендацию и если находит ссылку на этот документ, то включает его в индекс. При этом описание скрывает, пишет что оно недоступно из-за ограничения файла, а индекс засоряется. В данном случае есть более 5 000 страниц с непонятным параметром.

При анализе сайта rozetka.com.ua, было обнаружено в индексе 500 000 страниц сортировки. Может быть, само по себе это и неплохо, но робот потратил очень много времени на их индексацию, которое можно было потратить на индексацию более важных документов.

Внутренний аудит сайта

Следующий этап — это внутренний аудит. Здесь анализируем:

- Индексацию и дубли.

- Заголовки, мета-описания, контент.

- Код сайта.

- Работоспособность ссылок.

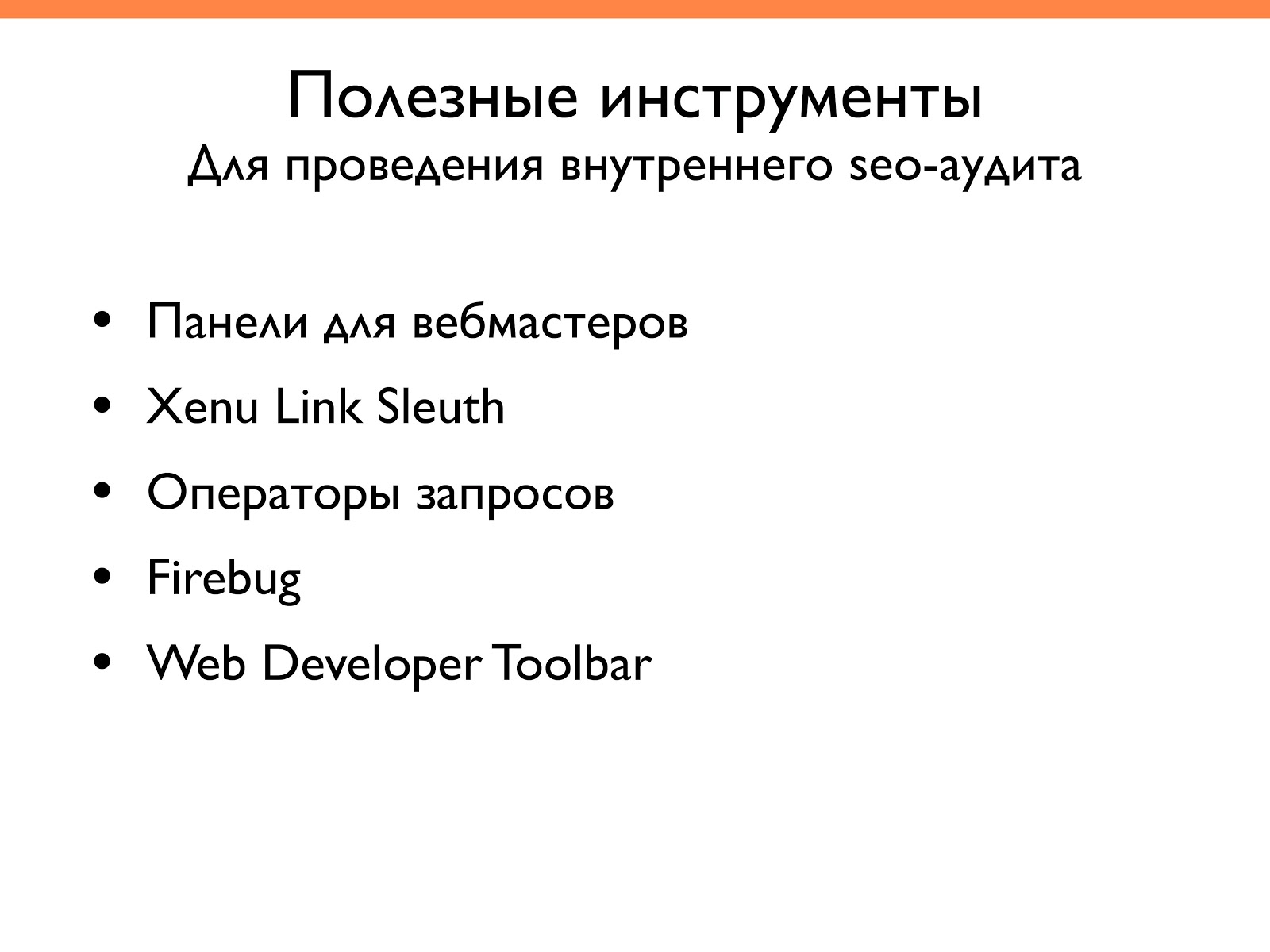

Полезные инструменты для проведения внутреннего SEO-аудита следующие:

Рассмотрим примеры.

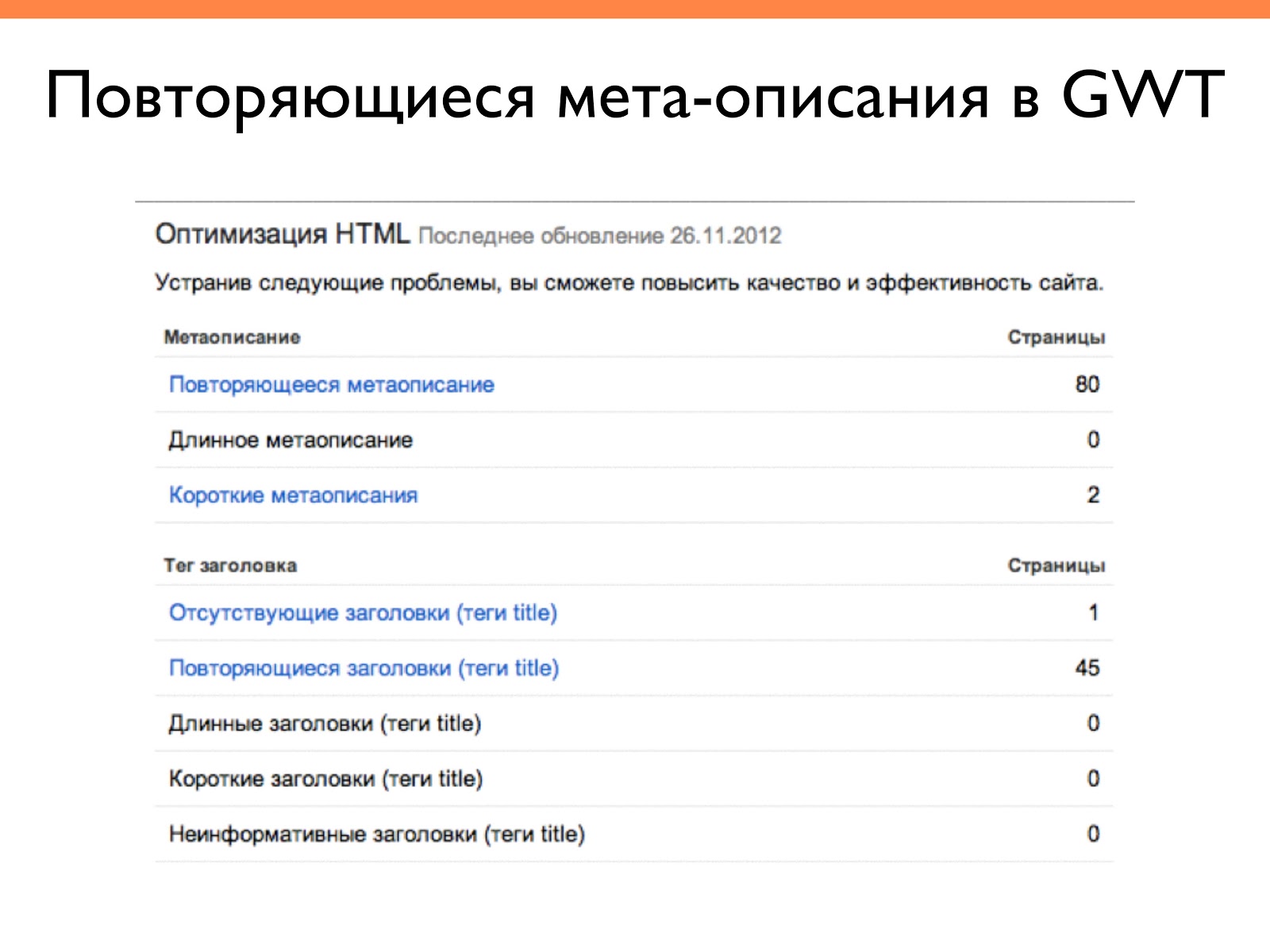

Повторяющиеся мета-описания можно найти в панели для вебмастеров Google. Там есть специальный раздел, где можно увидеть, где эти мета-описания дублируются. Либо можно использовать внешние инструменты — Ahrefs, Screaming Frog, SEO Spider.

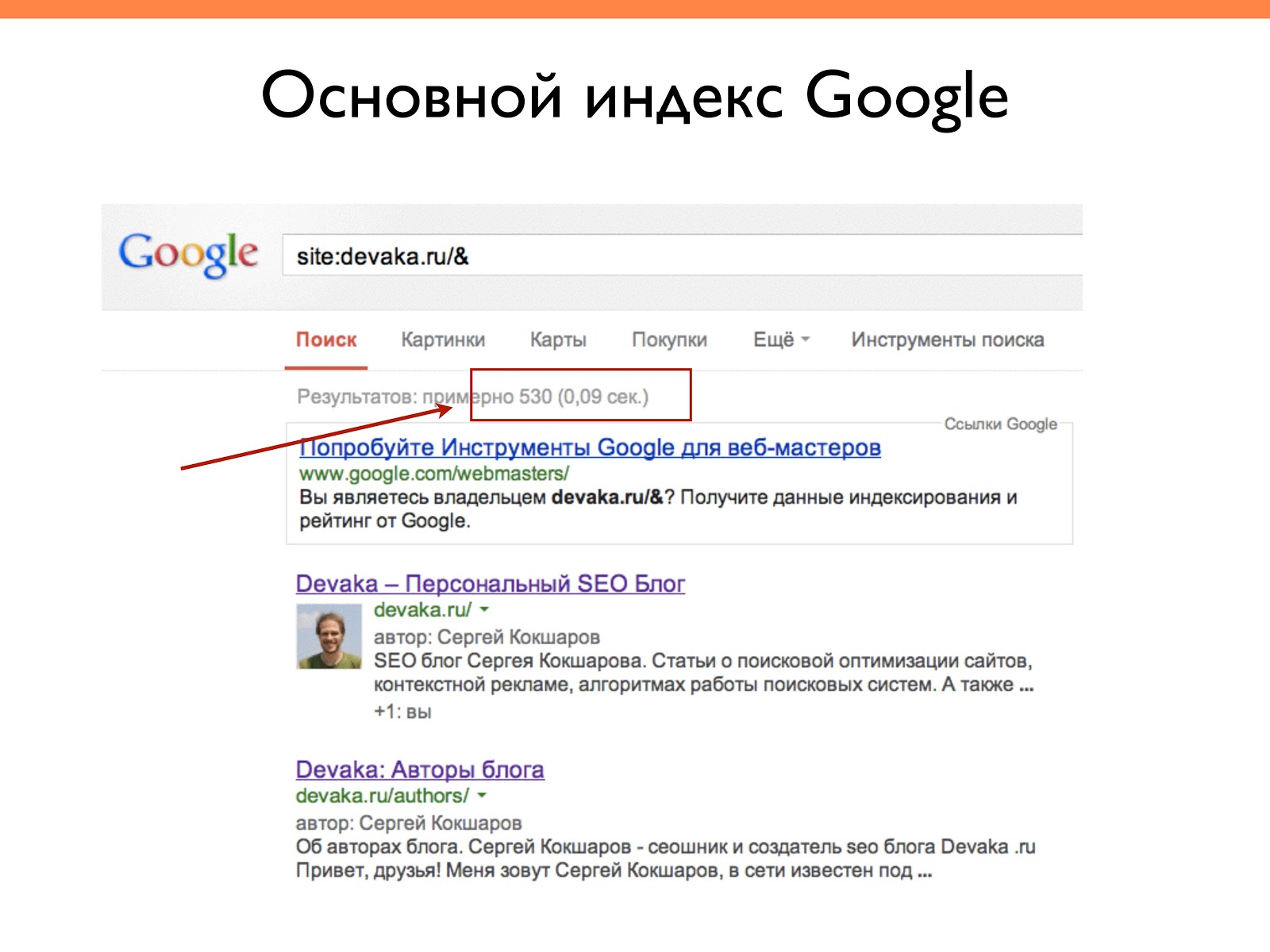

Здесь вы видите пример основного индекса. Можно вводить просто site:devaka.ru либо site:devaka.ru/&, проставляя в конце амперсанд. По этому поводу есть много споров в SEO среде, но результаты разные.

Исходя из моих анализов, страницы, которые выдаются с амперсандом чаще попадают в основной индекс, то есть участвуют в ранжировании и дают трафик. То есть с помощью такого оператора можно смотреть сколько на сайте находится нормально индексируемых страниц.

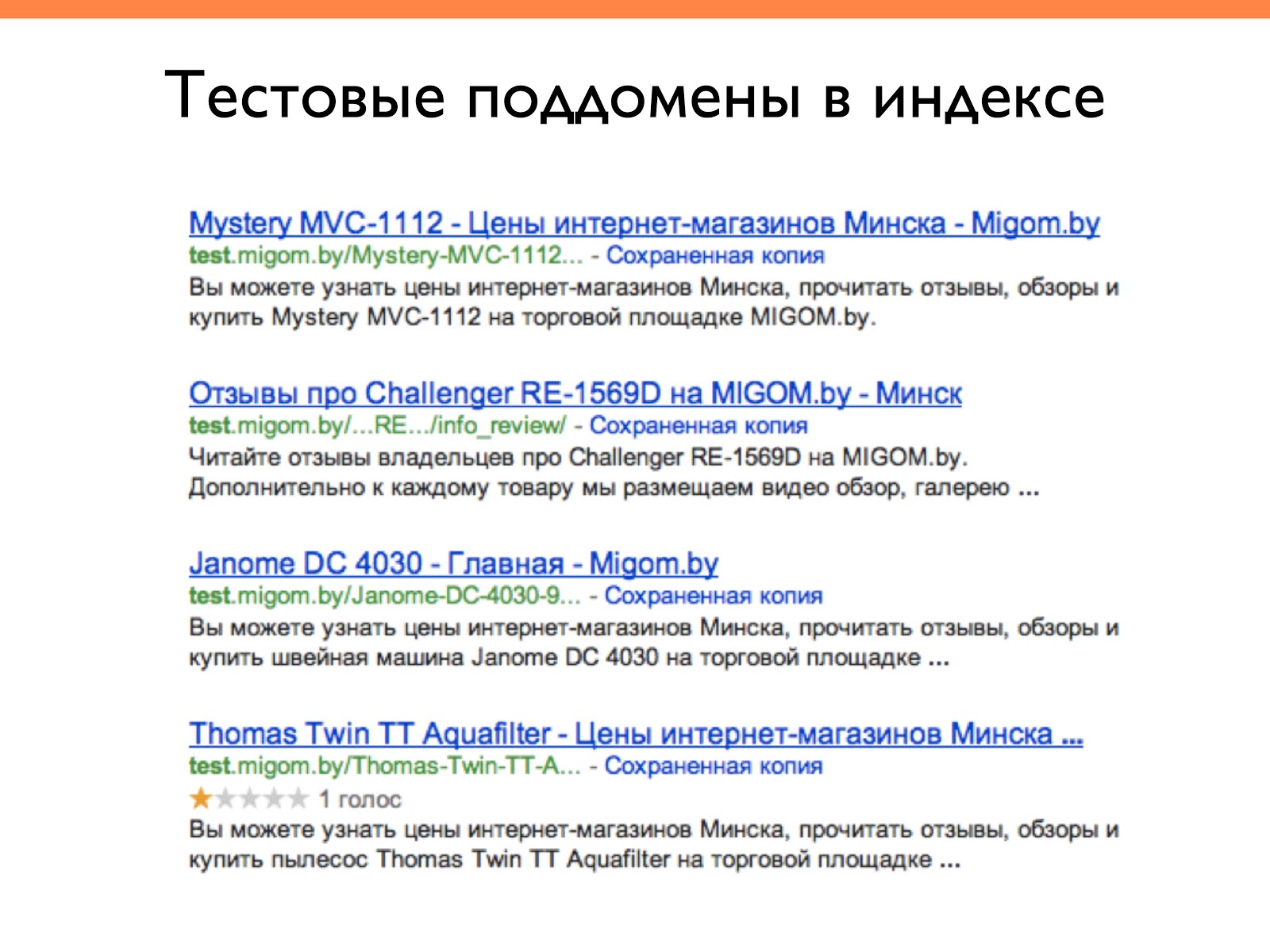

Можно искать, находятся ли тестовые поддомены в выдачи. Иногда мы что-то тестируем и забываем закрывать от индексации и получаем много дублей, которые потом сложно выкинуть из индекса. Из-за дублей ранжирование основного сайта может ухудшаться.

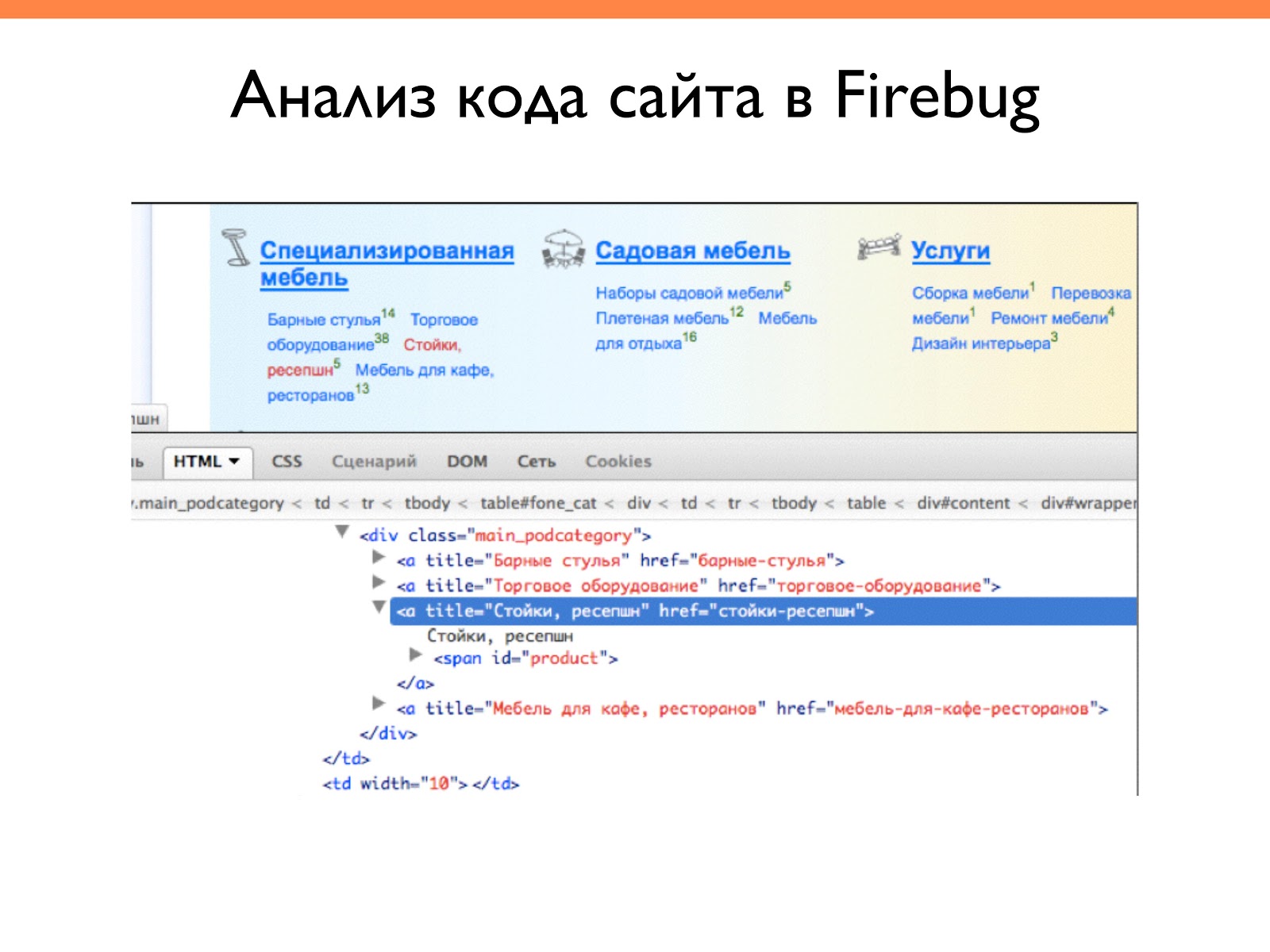

Вот пример работы плагина Firebug. С его помощью мы можем просмотреть html код страницы и проанализировать его. Удобная фишка.

На что обратить внимание во внутреннем аудите?

- Скудный meta-description (и сам контент) — это либо шаблоны описаний, либо отсутствие описаний, либо очень короткие описания.

- Отсутствие бренда в заголовках — часто пишут заголовки не уникализируя их. Например, продвигая товар Айфон 6, часто оптимизаторы так и пишут Айфон 6. Но можно написать и название магазина, который его продает, и тогда этот заголовок будет уникален в пределах всей коллекции. Это важно для алгоритма Яндекса, где группируются одинаковые сниппеты.

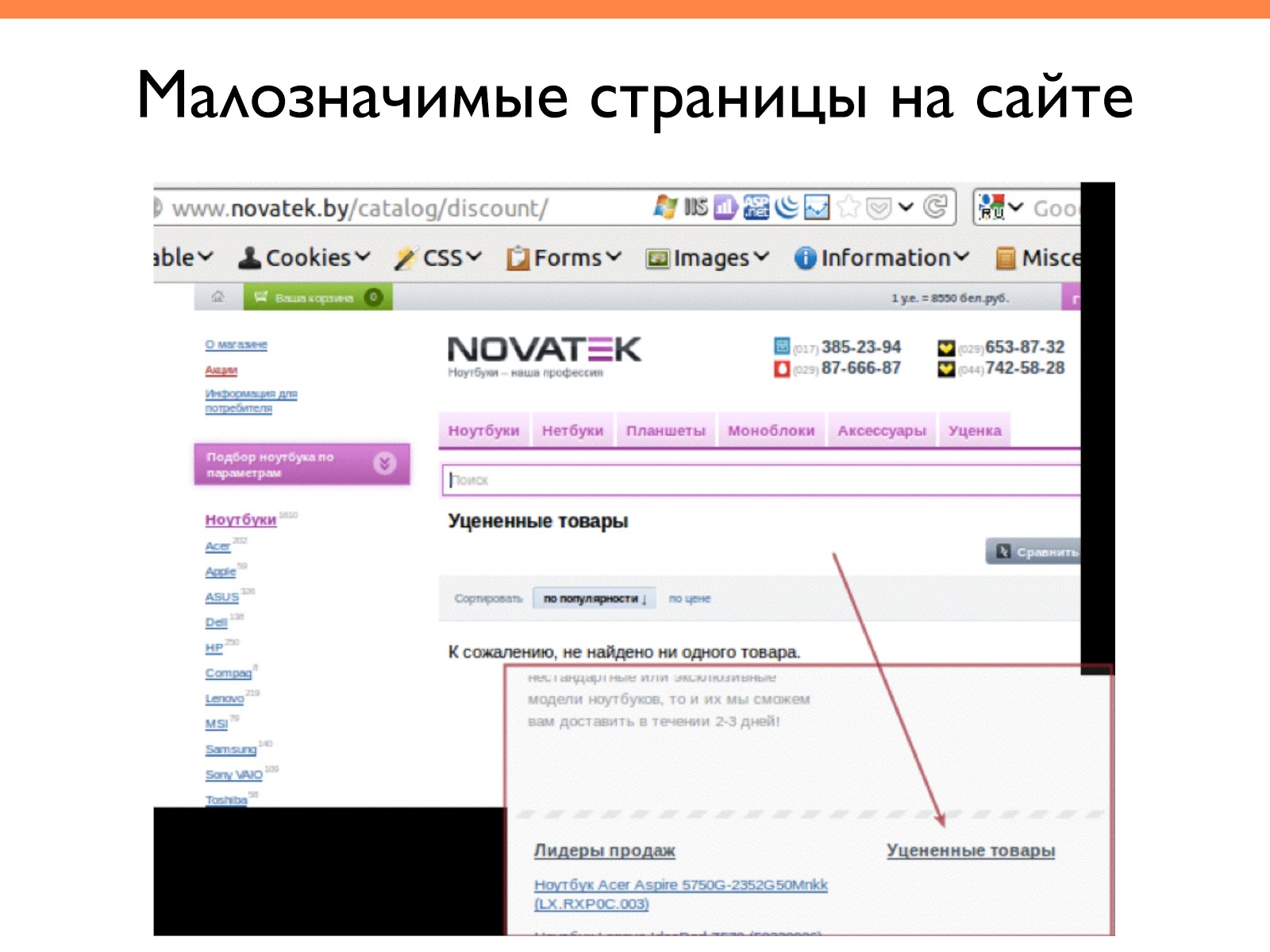

- Наличие малозначимых страниц в индексе, так называемый мусор.

Вот пример: сайт «Новатек». Когда-то на нем присутствовала ссылка «уцененные товары», и когда мы по ней переходили, то попадали на пустую страницу с надписью: «к сожалению, не найдено ни одного товара».

Возникает вопрос — зачем нужна эта ссылка? Что должны получить пользователи, которые переходят по ней? И что должны подумать роботы, когда они перейдут по этой ссылке? А если она на главной, то это важная страница на их взгляд, но в документе ничего не найдено. Это очень плохо. Нужно отслеживать все эти технические вещи: как работают ссылки, какой контент и т. д.

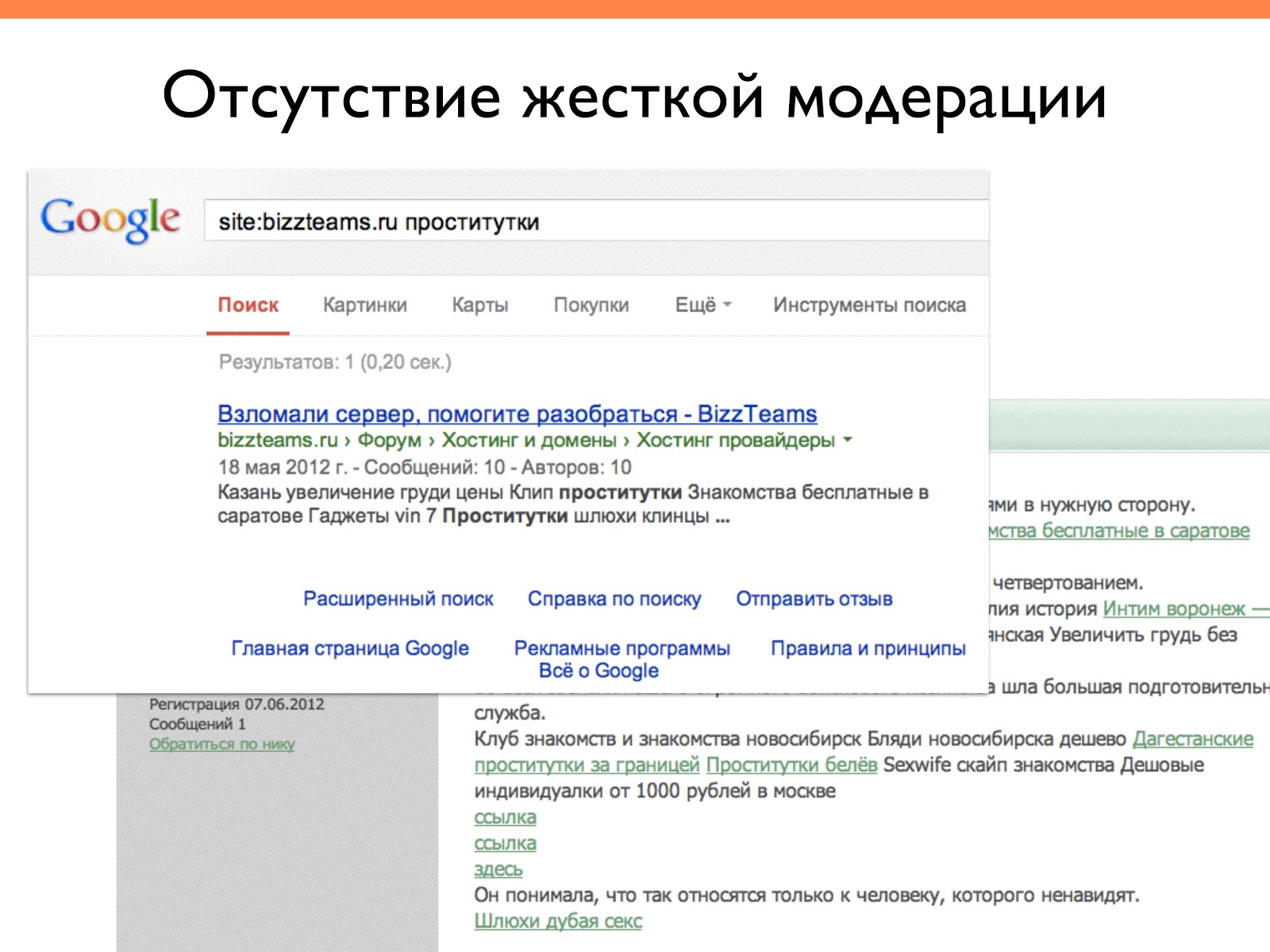

Еще один момент — отсутствие жесткой модерации на сайте. На слайде — форум, на котором по вине спамеров были посты неприличного содержания.

Необходимо отслеживать внутри сайта по поиску стоп-слов адалт-тематику, казино либо еще какие-то запрещенные тематики. Сайты взламывают, и если вы найдете эти фразы, то, значит, нужно принять какие-то меры. Это можно отследить с помощью Google Alerts: вам будет присылаться уведомления, если что-то будет обнаружено. Это очень удобно.

Анализ внешней оптимизации

Внешний аудит сайта подразумевает анализ:

- Ссылочных профилей.

- IP-адресов ссылочных доноров.

- Конкурентов.

Чаще всего используются такие инструменты, как вы видите на слайде:

Отмечу, что SemRush хорош для анализа зарубежной базы и конкурентов, Serpstat (старое название – Prodvigator) — базы Украины, России, Болгарии, Казахстана. SpyWords парсит контекстную рекламу по региону Яндекс-Москва.

Alexa — условно бесплатный инструмент, где можно посмотреть популярность ресурса и как она менялась со временем.

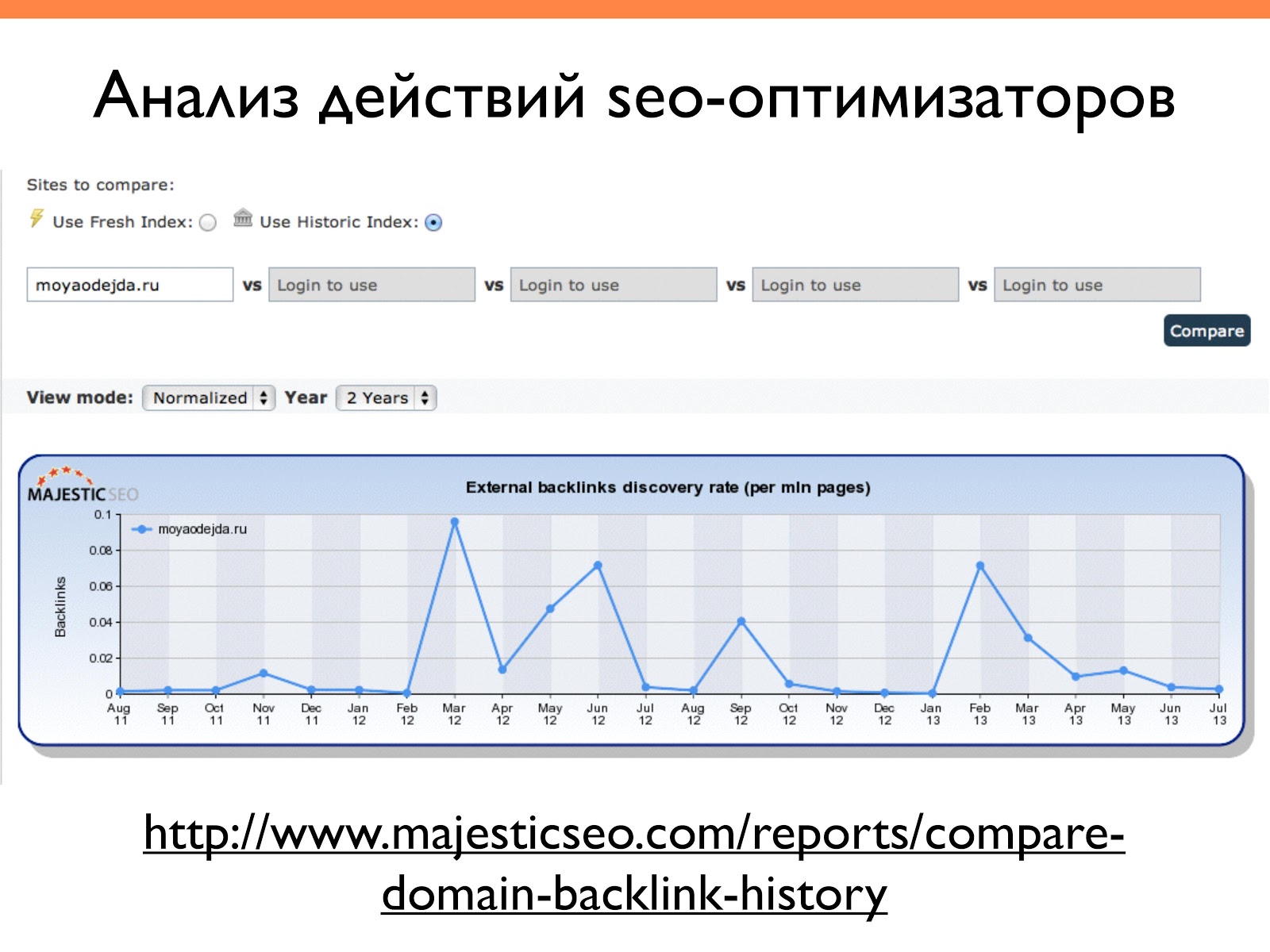

Вот пример работы инструмента Majestic SEO — смотрели, как ссылки появлялись на одном сайте. В данном случае мы видим, что в марте 2012, в июне 2012, сентябре 2012, феврале 2013 — была активная закупка ссылок.

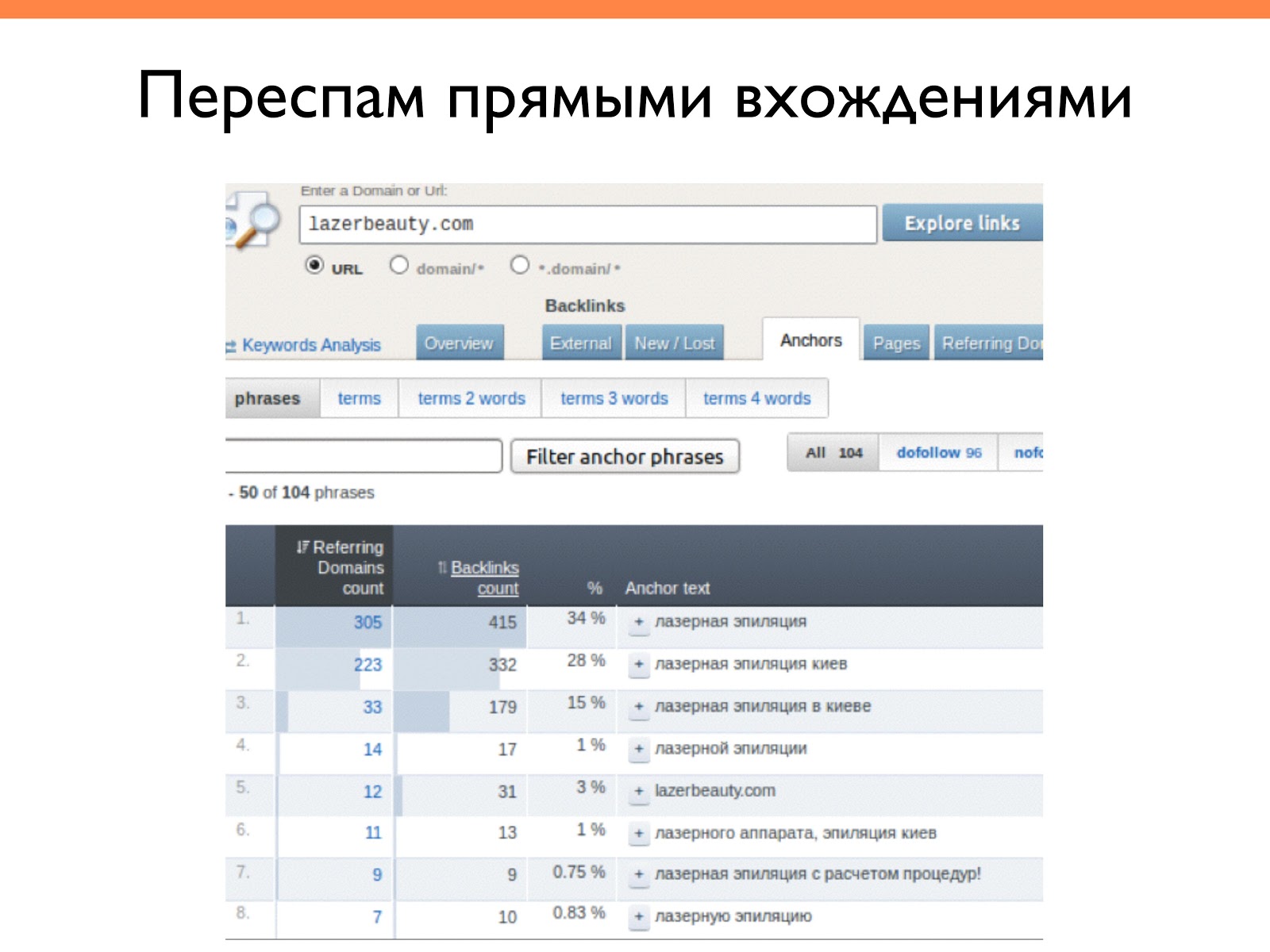

Часто допускаемые ошибки во внешней оптимизации это:

- Переспам анкор-листа. Сейчас уже стараются не спамить и делать более естественные анкор-листы.

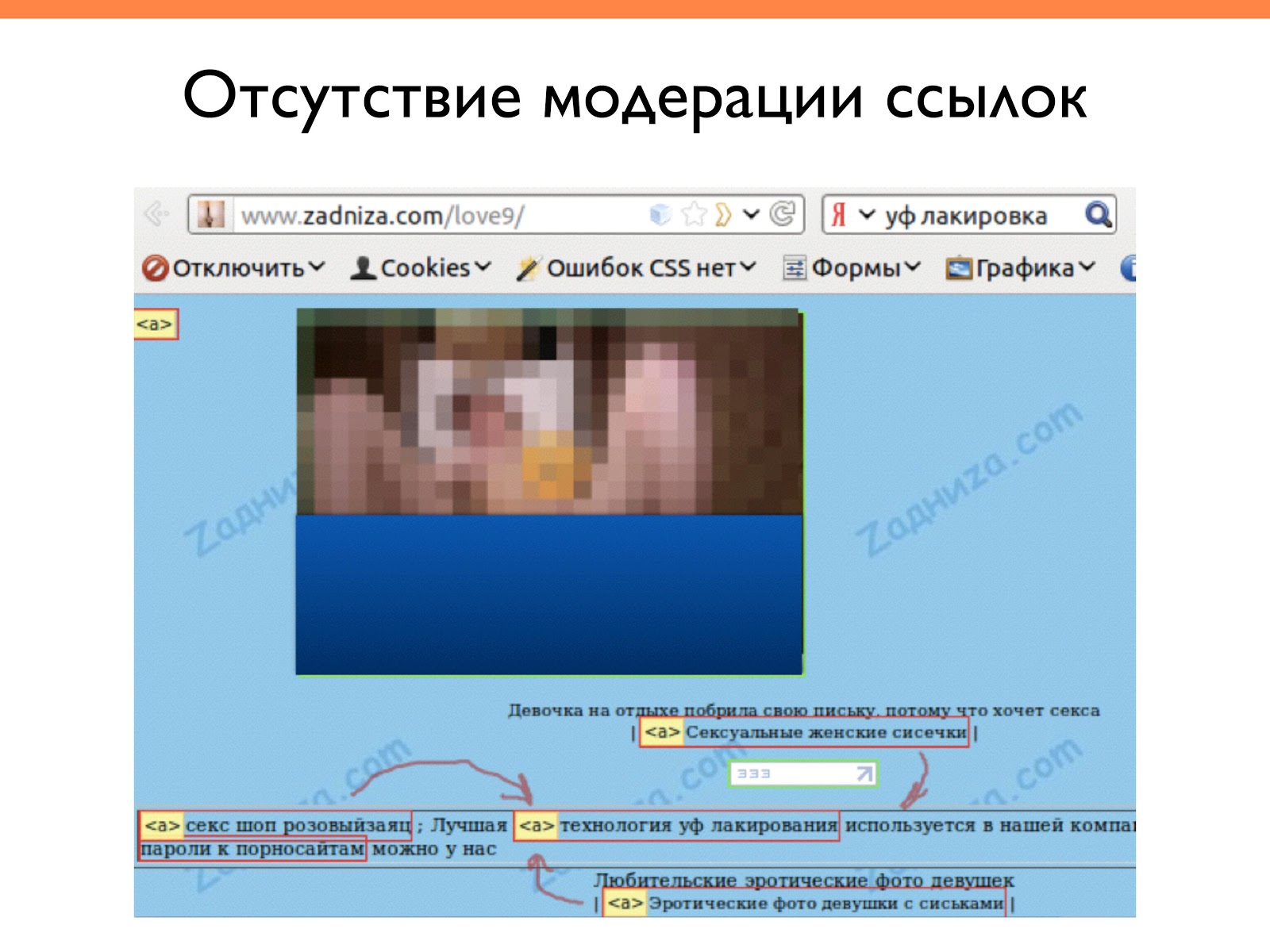

- Отсутствие модерации купленных ссылок. Нужно смотреть что вы покупаете, что это за сервисы, агрегаторы, биржи ссылок.

- Использование сетей сателлитов. Есть ли в них обратные ссылки или нет.

Рассмотрим примеры.

Вот здесь анкор-лист, преимущественно, состоит из ключевых слов.

Вот пример соседства со ссылками. Здесь продвигается технология УФ-лакирования, но при закупке ссылок не обратили внимание на то, что рядом с их ссылками стоят совершенно не тематические ссылки и, вообще, «взрослая» тематика. Эти вещи надо отслеживать.

Также следует обращать внимание, есть ли сети сателлитов, которые ссылаются на ваш ресурс. Это можно сделать с помощью сервиса Ahrefs, который группирует по IP-адресам.

Если несколько сайтов находится на одном IP-адресе — то это, скорее всего, какая-то сетка. В примере один из сайтов, на который ссылались тысячи ссылок (это очень много) с двух платформ. Это были спам-блоги, с помощью которых заказчик решил продвигать свой сайт. Когда я ему показал эти ссылки, он о них знал и долго не мог понять почему это плохо. Сейчас это действительно плохо. Поисковики сетки отслеживают очень быстро и желательно их не иметь. А если кто-то решил вас завалить, то это также надо отследить и быстро среагировать.

Анализ семантики

Семантический анализ — это более узкий вид аудита, где анализируется:

- Распределение запросов.

- Семантическое ядро.

- Потенциал поисковых запросов.

Для анализа семантики используются такие полезные инструменты:

Вот список более 50 инструментов для работы, которые можно использовать. Большинство из них бесплатные.

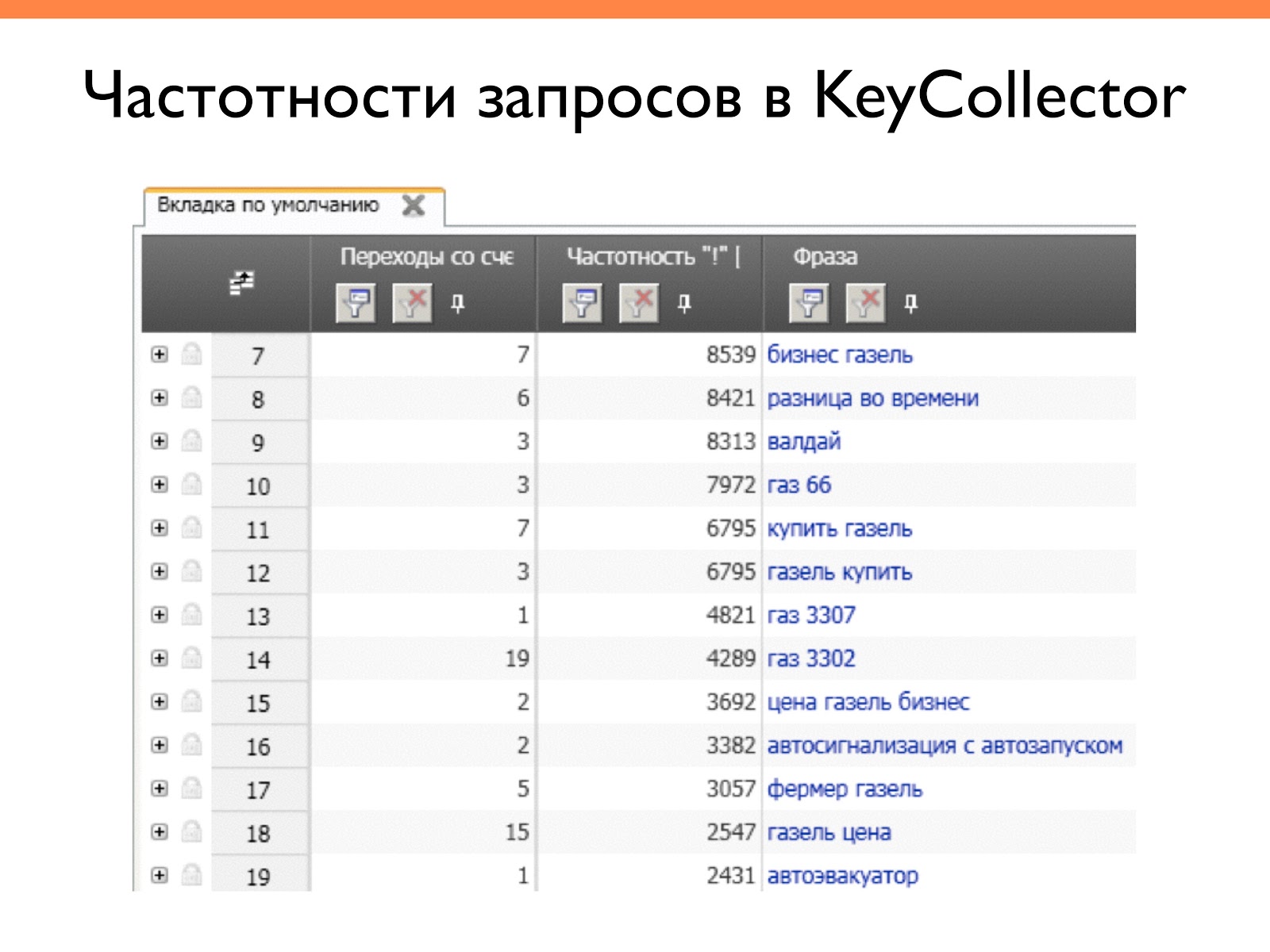

Это пример работы Key Collector. Хороший инструмент для работы с семантикой. Здесь можно как собирать различную статистику, так и группировать запросы, чистить, вводить фильтры и т. д.

Анализ структуры сайта

Анализ структуры сайта тесно связан с анализом семантики. Когда собрано семантическое ядро, одна из целей — построить на нем структуру сайта.

Здесь анализируем:

- Соответствие семантике.

- Глубину вложенности.

- Навигацию.

Часто допускаемые ошибки, с которыми мы сталкиваемся на этом этапе:

- Большой уровень вложенности (4 и более).

- Несоответствие структуры семантике.

- SEO-навигация во вред юзабилити. Часто вебмастера при перелинковке блоков, элементов навигации, меню и т. д. хотят угодить поисковикам, и вставляют много ключевых слов. Поисковики это анализируют, и если наблюдают переспам, могут забанить. Я с этим сталкивался для Яндекса. Нам приходилось менять перелинковку, потому что она была спамной для Яндекса. Вывод — делать навигацию, соответствующую потребностям пользователя.

Еще раз напоминаю о SEO чек-листе. В него всегда можно посмотреть, отметить, ввести какие-то свои пункты.

Советы для облегчения анализа сайта

Несколько советов, которые облегчат провести SEO-аудит.

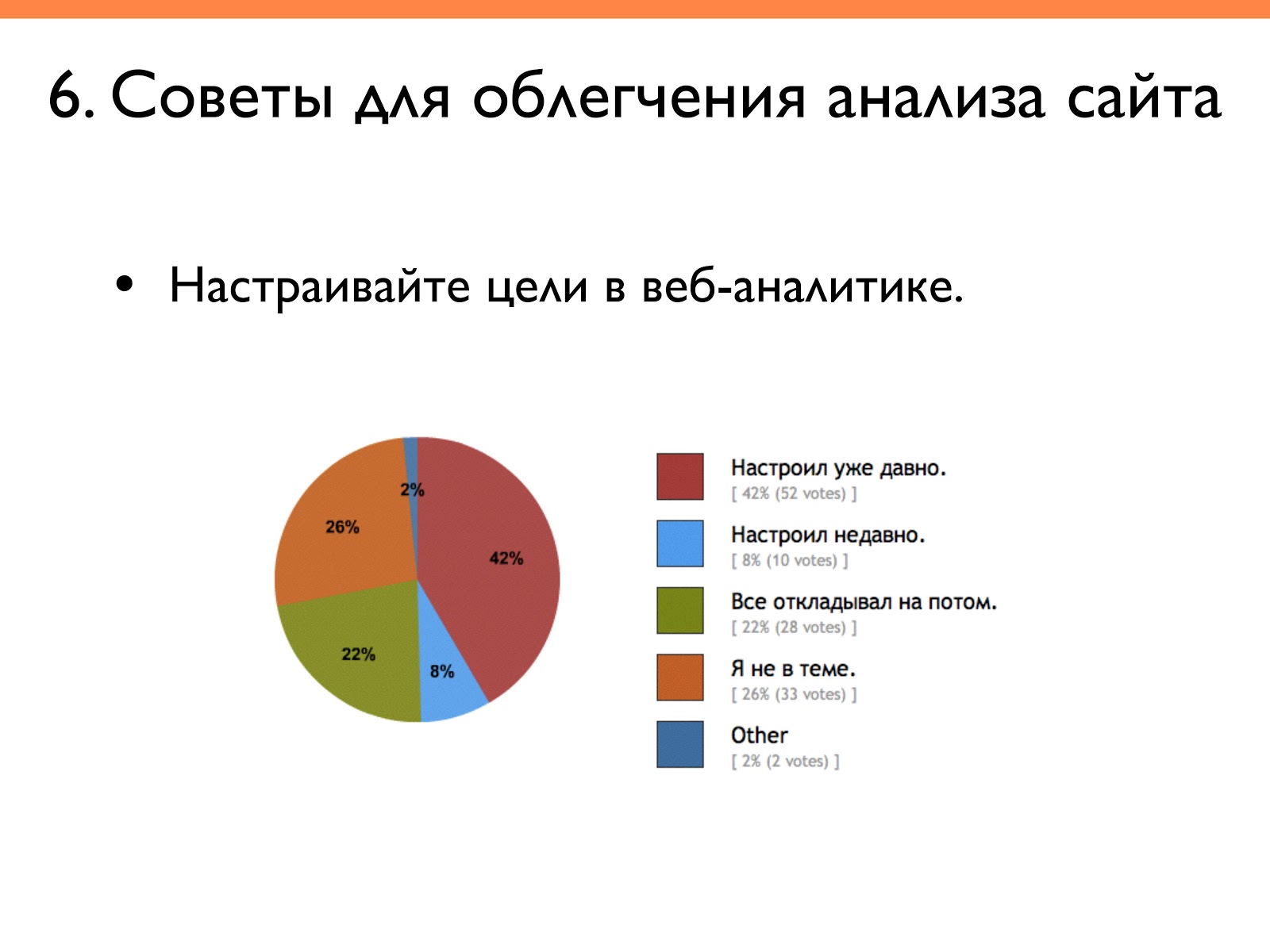

Настраивайте цели в веб-аналитике

По результатам опросов, которые я проводил, многие либо не в теме, что такое цели, либо откладывают их на потом. Знают, что можно настроить, посчитать конверсию от продажи, но лень делать.

Надо настраивать, ведь без цели сложно потом анализировать.

Вот цели моего блога: сколько человек смотрят услуги, сколько человек переходят на страницу контактов. Также здесь смотрю список источников трафика и сортирую по какой-то из целей.

Если вы хотите научиться оптимизировать сайты и стать суперменом-сеошником, то можем предложить курс «SEO-оптимизация: продвижение сайтов в поисковых системах». После курсов проведете аудит сайта и создадите стратегию продвижения. Научитесь анализировать конкурентов, сформируете семантическое ядро. Прогнозируя результаты продвижения, сможете оптимизировать бюджет. Привлекательно? Записывайтесь!

Авторизуйтесь, чтобы оставлять комментарии