Статья поможет разобраться, как раскладывать сайт на мелкие составляющие и находить технические ошибки на сайте.

Главные инструменты для аудита сайта

Для того, чтобы осуществить SEO-аудит сайта, нам понадобится несколько технических инструментов.

Инструменты для аудита я разделил на 3 группы:

1. RDS bar для браузера.

2. Краулер серверный или десктопный:

- Screaming Frog,

- Netpeak Spider,

- Seoto.me.

3. Яндекс.Вебмастер + Google Search Console.

Также для определенного типа аудита пригодятся сервисы:

При этом Ahrefs – самый тяжелый. У него большая абонентская плата, зато он предоставляет такую информацию, которую не даст никто другой.

Упрощенной альтернативой является LinkPad. Плюс – предоставляет некоторую информацию бесплатно, минус – задержка в обновлении (информация обновляется с задержкой в месяц-два).

Topvisor – сервис мониторинга позиций. Topvisor необходим для мониторинга сниппетов, чтобы понимать, как представляется сайт в результатах поиска.

С чего начинать аудит?

Начинаем SEO-аудит с проверки редиректа www.

У вас должен быть только один основной адрес. Переадресация либо с адреса домена с www на адрес домена без www. Или наоборот. Редирект должен проходить на зеркальные странички, которые должны отличаться только наличием www или его отсутствием. Какой адрес выбрать основным – с www или без – решать исключительно вам.

Чем это чревато? Поисковики могут неправильно определять, какие страницы основные, путаться, какая страница релевантна, иногда может происходит сохранение дублей страницы. Яндекс очень долго обновляет информацию, для этого поисковика такая ошибка вообще может быть катастрофической.

Robots.txt. Очистка Get-параметров в URL

Чтобы посмотреть содержание файла Robots.txt, необходимо набрать «имя_домена/robots.txt» или установить RDS bar. В RDS bar можно по одному клику открыть Robots.txt.

Robots.txt для Яндекса должен содержать инструкцию Clean Param, которая очищает адреса страниц в индексе от Get-параметров. Это адреса страниц, где передаются какие-то параметры с ссылками, например, «id=348» или «param=al»l.

Чаще всего такие страницы в индексе вам не нужны, потому что обычно это технические адреса. Но конечно, нужно смотреть каждый сайт отдельно. В Яндексе такие страницы закрываются в Robots.txt через параметр Clean Param. В нем мы указываем, что страничку с параметром, например, «id» мы не индексируем.

В Google такие страницы мы закрываем через специальный инструмент в Google Search Console. В нем можно добавлять служебные параметры, URL с которыми необходимо закрывать от индексации.

Я рекомендую закрывать от индексации такие параметры:

- Page – пагинация.

- Все utm-метки.

- ID клика от Яндекс.Директ.

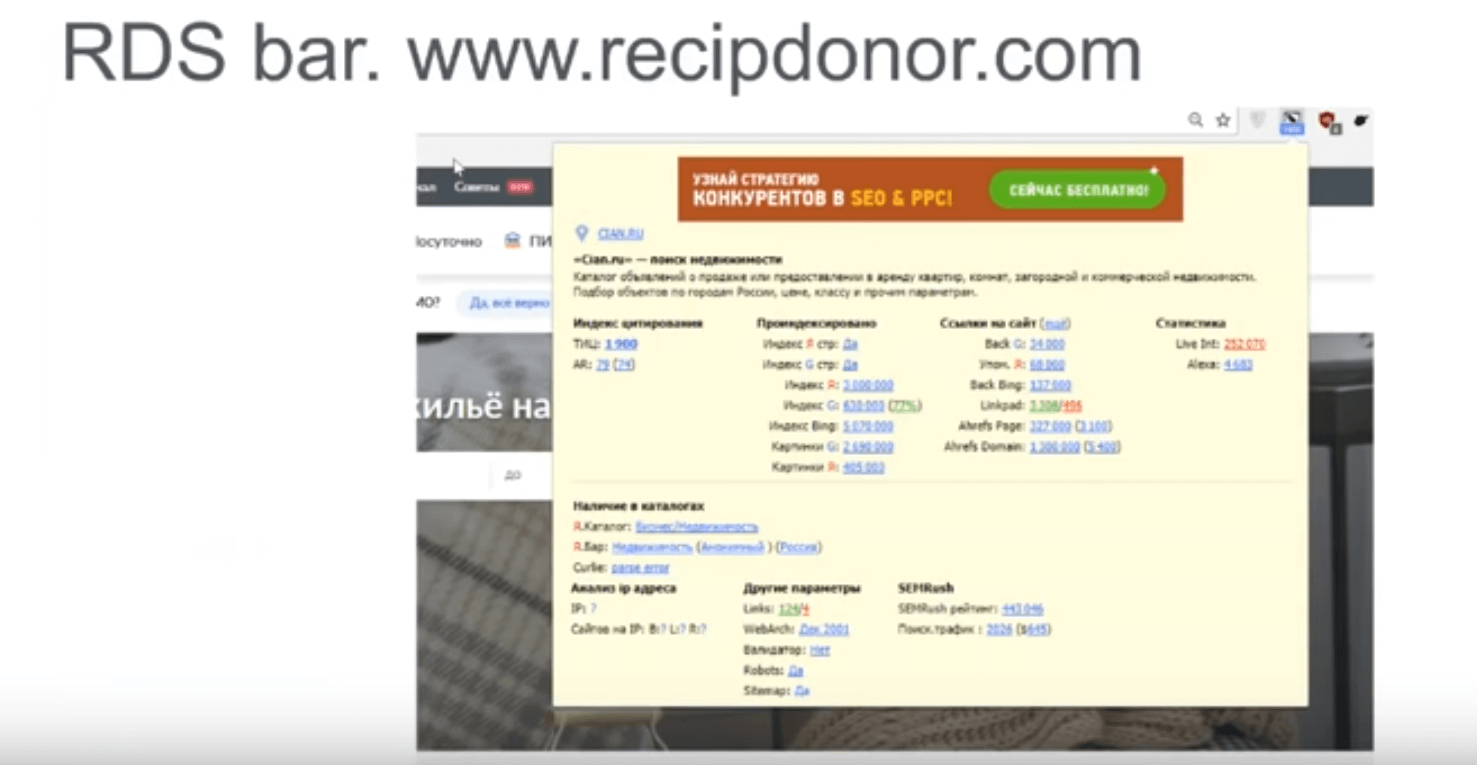

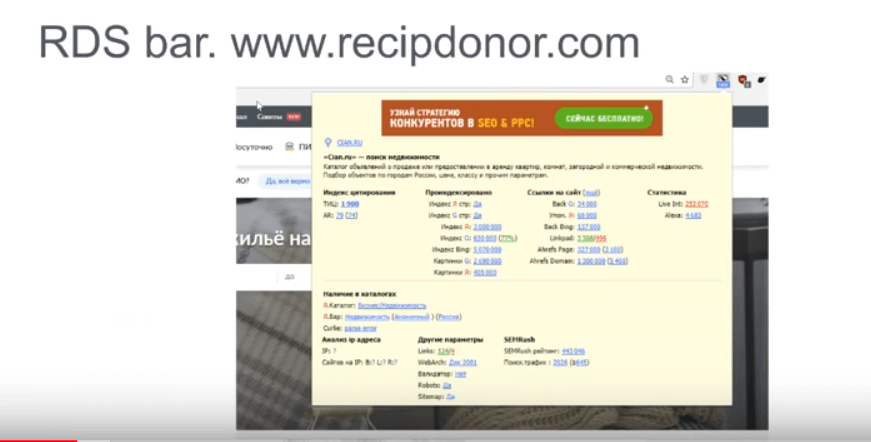

Что такое RDS bar?

RDS bar – это бесплатное расширение для браузера. Работает на всех основных версиях Chrome, Opera, Firefox, Safari и т. д. Позволяет по клику в панели расширений быстро посмотреть информацию о сайте или конкретной странице, которую вы посещаете.

Показывает заголовок, описание, иконку, ИКС, рейтинг Ahrefs, который показывается отдельно для странички и отдельно для домена. Информацию о проиндексированных страницах в Яндексе и Google, которая будет показываться на текущей странице.

Обратите внимание на индексы от Google – основной и второстепенный. Они должны быть приближаться к 99 %. Если значения сильно отличаются, то поисковик принимает много ваших страниц за некачественные.

Нужно отлавливать такие страницы и исправлять. Ненужные страницы закрыть от индекса, нужные – улучшить, например, добавить уникальный текст.

Последние две строчки – количество проиндексированных картинок и количество внешних ссылок. Это не совсем внешние ссылки, потому что в Google – это внешние ссылки на сайт, а в Яндексе – просто упоминания домена.

Далее идет информация о внешних ссылках от сервиса LinkPad – он показывает информацию о ссылках и уникальных доменах, которые ссылаются на этот сайт.

Следующая информация – это данные Ahrefs о внешних ссылках, которые ссылаются на данную страничку, и Ahrefs domain – количество ссылок на домен. Большая цифра – количество ссылок, маленькая – количество уникальных доменов

Последняя колонка – статистика. Показывается вся доступная. Например, отображается счетчик LiveInternet, который показывает количество уникальных посетителей за 24 часа. Alexa ранг – счетчик, который показывает насколько популярен сайт (чем цифра меньше – тем сайт выше в рейтинге). Потом идет информация о каталогах. Данная информация уже ценности не представляет, так как большинство каталогов постепенно умирает. Ручная обработка сайтов уже изживает себя, автоматизированные системы берут свое.

Curle – доморощенный наследник Dmoz. RDS bar его показывает.

Анализ IP-адреса показывает ваш IP и какие плохие сайты существуют на нем. Бывает полезно посмотреть – не находится ли на нем огромное количество дорвеев на графе или сайтов запрещенных к индексации. Критично для России, которая любит блокировать через Роскомнадзор все нехорошие сайты. Часто бывает блокировка по IP. Если вы заехали на хостинг, где все плохо, то лучше с такого хостинга съехать.

Самым полезным для вас будет параметр Web-архив – первая индексация страницы с вашего домена, валидация HTML-кода. Две моих любимых ссылки на Robots.txt и Sitemap позволяют быстро переходить на эти файлы.

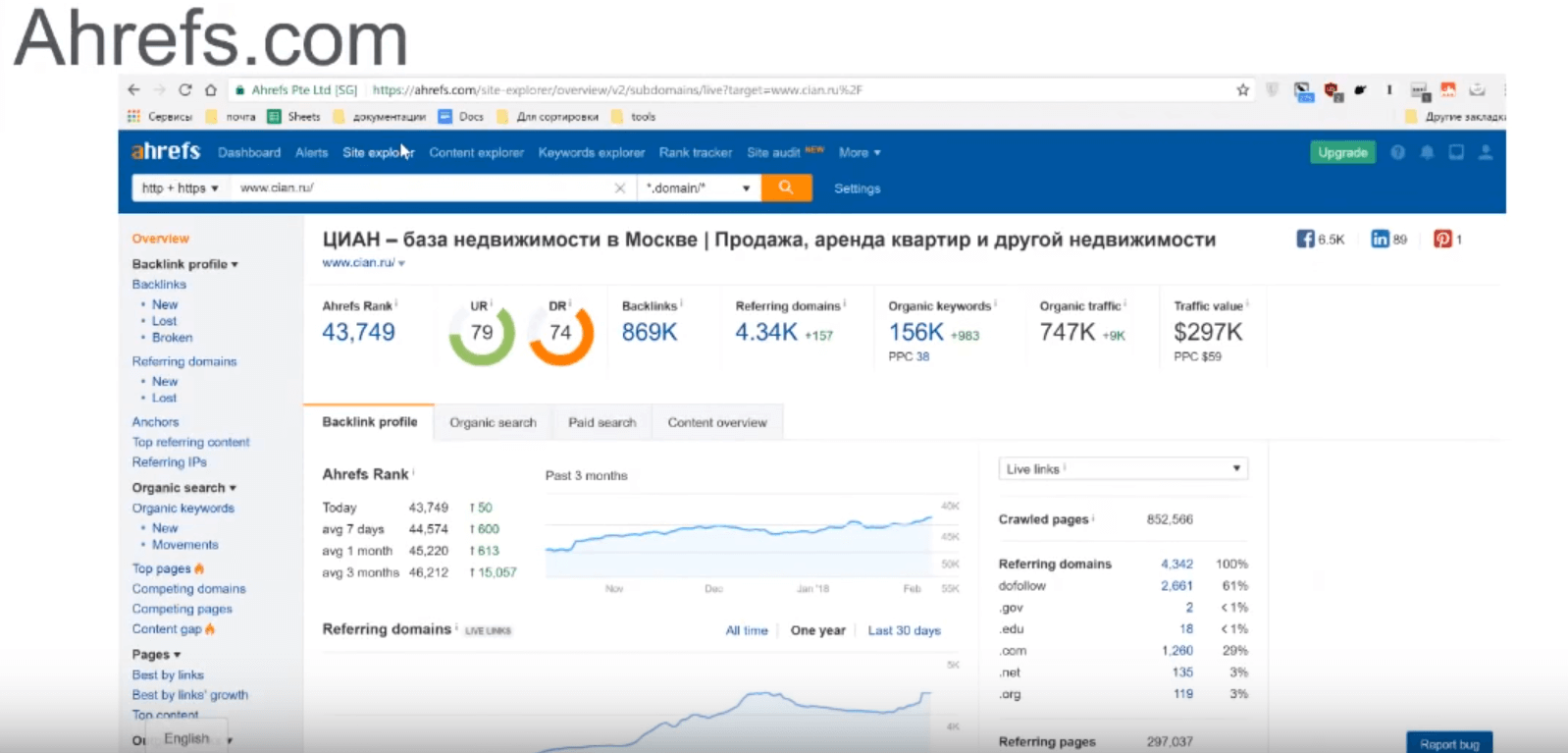

Ahrefs

Это сервис, который создавался для мониторинга ссылок. Полезен для того, чтобы посмотреть данные по вашему сайту. Для SEO-аудита я бы его не очень рекомендовал. Он очень полезен для анализа ваших конкурентов. Как конкурентов в выдаче. так и конкурентов в бизнесе.

Можно посмотреть данные, какой у них популярный контент, какие ссылаются домены. Это не совсем SEO-аудит. Анализ конкурентов – это анализ стратегии продвижения ресурса.

Раз мы заговорили про этот инструментарий, то рекомендую использовать его для анализа конкурентов. Заходим в раздел «Сайт Explorer» → «Беклинки» и смотрим все ссылки, которые ведут на сайт конкурентов. Причем объем этих ссылок может быть весьма и весьма колоссальный, но система позволяет быстро получить данные по необходимым сайтам в полном объеме и с высокой актуальностью. Буквально вчерашние и сегодняшние ссылки уже находятся в базе.

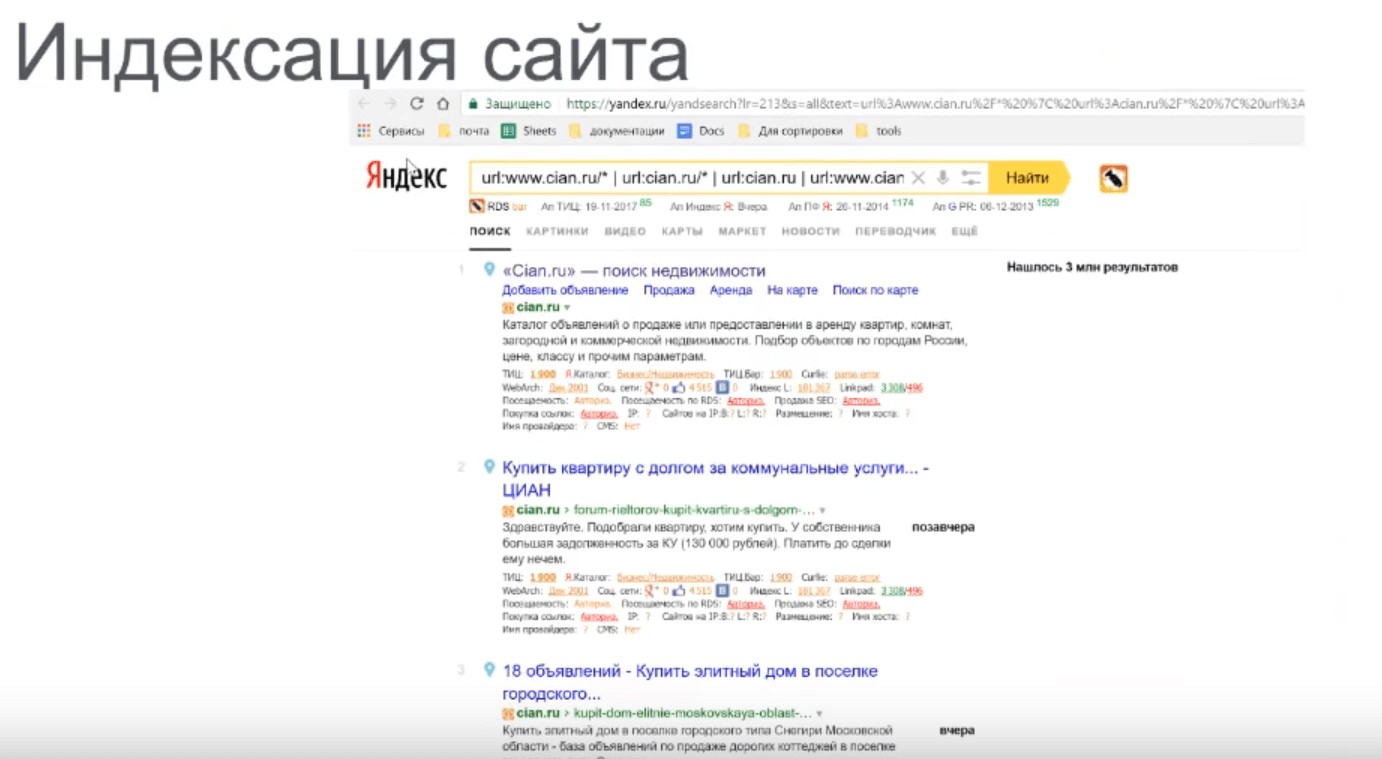

Индексация сайта

Кликнув на RDS bar, на число проиндексированных страничек, мы видим индексацию сайта как в Яндексе, так и в Google. Выбирайте систему, которая для вас приоритетна.

Если работаете на российском рынке, то нужно будет смотреть оба поисковика, так как доля Google и Яндекса в российском сегменте где-то 50/50. В каждой области имеет смысл работать над индексацией сайта.

Три больших блока, которые имеет смысл посмотреть.

Первое – это попадание неправильных страничек в индекс. Технические страницы, которые вам по большому счету не нужны. Например, появляется на первом месте страница с информацией о конфиденциальности, техническое соглашение, использование куки. У нее будет высокий рейтинг из-за сквозной навигации на эту страницу. В идеале – нужно закрыть эту ссылку от индексации. Если это проблематично, то нужно закрыть эту ссылку в Robots.txt.

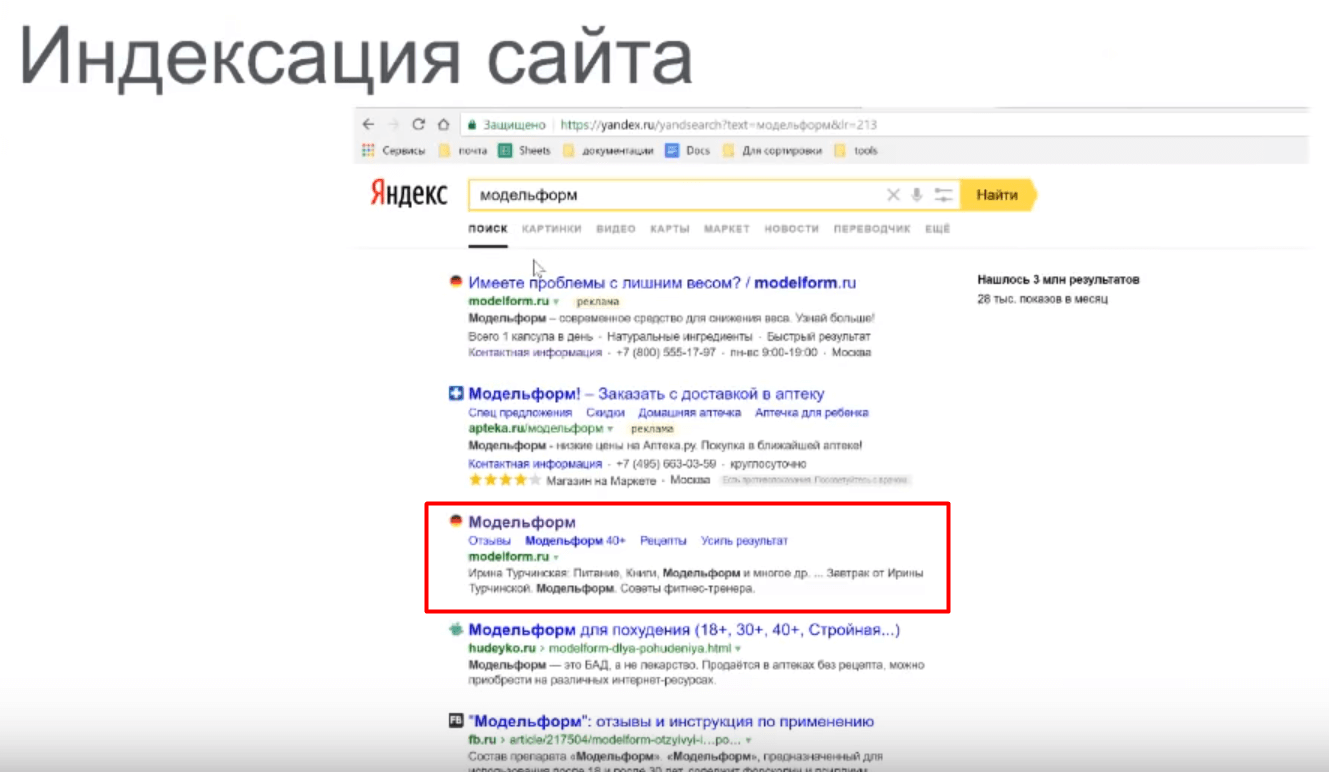

Второе, что нужно смотреть на сайте – это техническое качество отображения сниппетов. В сниппете не должно быть косяков и ошибок. Например, сниппет-пустышка, появление псевдографики, не той кодировки. Все это можно посмотреть при быстром листании. Резкое изменение на фоне одинаково сформированных сниппетов будет сразу заметно.

Обратите внимание, что сниппет формируется поисковиком под определенный запрос. Если страница ранжируется по нескольким запросам, то для каждого запроса сниппет будет разный. Потому что поисковик будет выдергивать фразу из контента, подсвечивать ее и выделять жирным. Поэтому лучше всего смотреть сниппеты не только по индексации, но и по реальным запросам. Какой сниппет формируется под какой запрос. Тут поможет сервис Topvisor, чтобы вручную не перепроверять каждый запрос. Можно с помощью инструмента Топ-сниппет посмотреть, какой сниппет и под какой запрос формируется в Яндексе.

Третье – это страницы с Get-параметрами, попавшие в индекс. Их нужно запрещать в Яндексе через Robots.txt, а в Google – через панель Web-мастера.

Это могут бысть странички с фильтрацией, порядком сортировок, отдельного отображения количества артикулов. Например, сначала на страничке 24 артикула, потом можно выбирать 48 артикулов на странице.

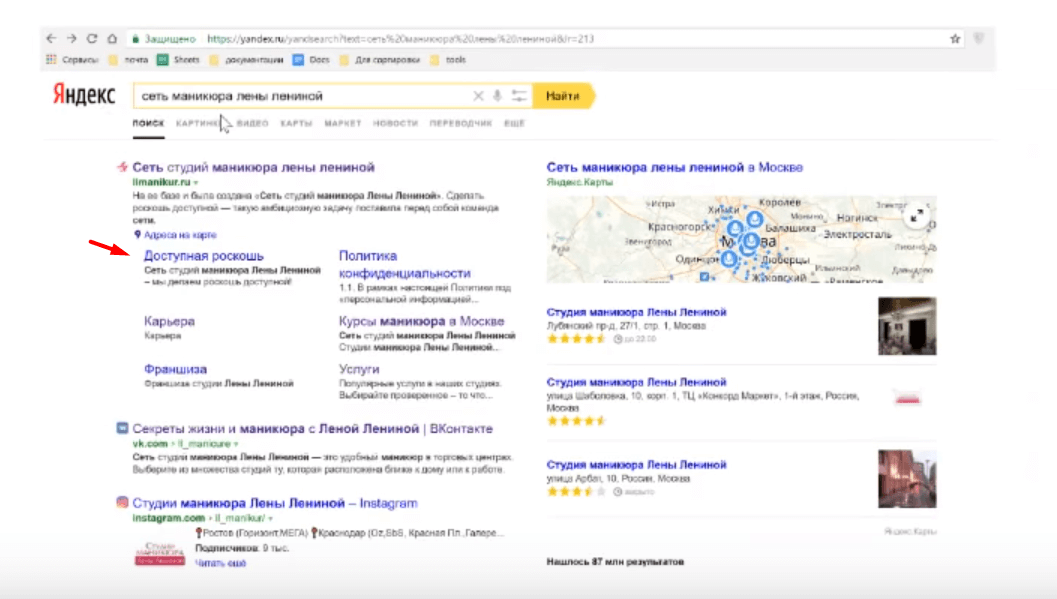

Желательно, чтобы у вас были правильные быстрые ссылки. Они достигаются путем анализа поисковиком вашего сайта.

Отображаются быстрые ссылки сразу под тайтлом. Но если трафика на ваш сайт много, то в Яндексе и Google у вас будет расширенный сниппет.

Например, сеть студий маникюра. Но с другой стороны, одна из этих ссылок не очень полезна. Политика конфиденциальности не приносит никакой конверсии, ее имеет смысл закрывать от индексации.

Вы не можете указывать поисковикам, какие ссылки отображать на этом экране, но вы можете зайти в соответствующий раздел и попросить исключить из отображения тот или иной раздел. И поисковик скорее всего прислушается к этой рекомендации.

Краулер Seoto.me

Теперь про краулеры. Краулер - это программа, которая используется для сканирования сайта. Паук переходит на ваш сайт и по ссылкам осуществляет переходы на страницы сайта, попутно собирая о них информацию.

Краулеры бывают двух типов:

- Десктопный – программка, которая работает локально на вашем компьютере. Как правило, вы платите только один раз и можете дальше работать с ней неограниченное количество раз.

- Облачные (серверные) сервисы краулинга, как правило, взимают плату один раз за сканирование одного сайта. Большой плюс – ваш компьютер не будет загружен, не нужно ждать долго окончания процесса сканирования.

Есть десктопные краулеры Screaming Frog и Netpeak spider. Они отлично справляются с небольшими сайтами.

Из облачных рекомендую Seoto.me. Раньше он был вообще бесплатным для пяти сайтов.

Теперь бесплатно показывается только часть информации. Но по большому счету, если вам нужно проверить, плох или хорош ваш сайт, какое есть количество ошибок, то можете попробовать сервис.

Заходите на сайт, указываете домен. Запускаете сканирование, которое, как правило, занимает около часа. После чего вы можете смотреть информацию об ошибках.

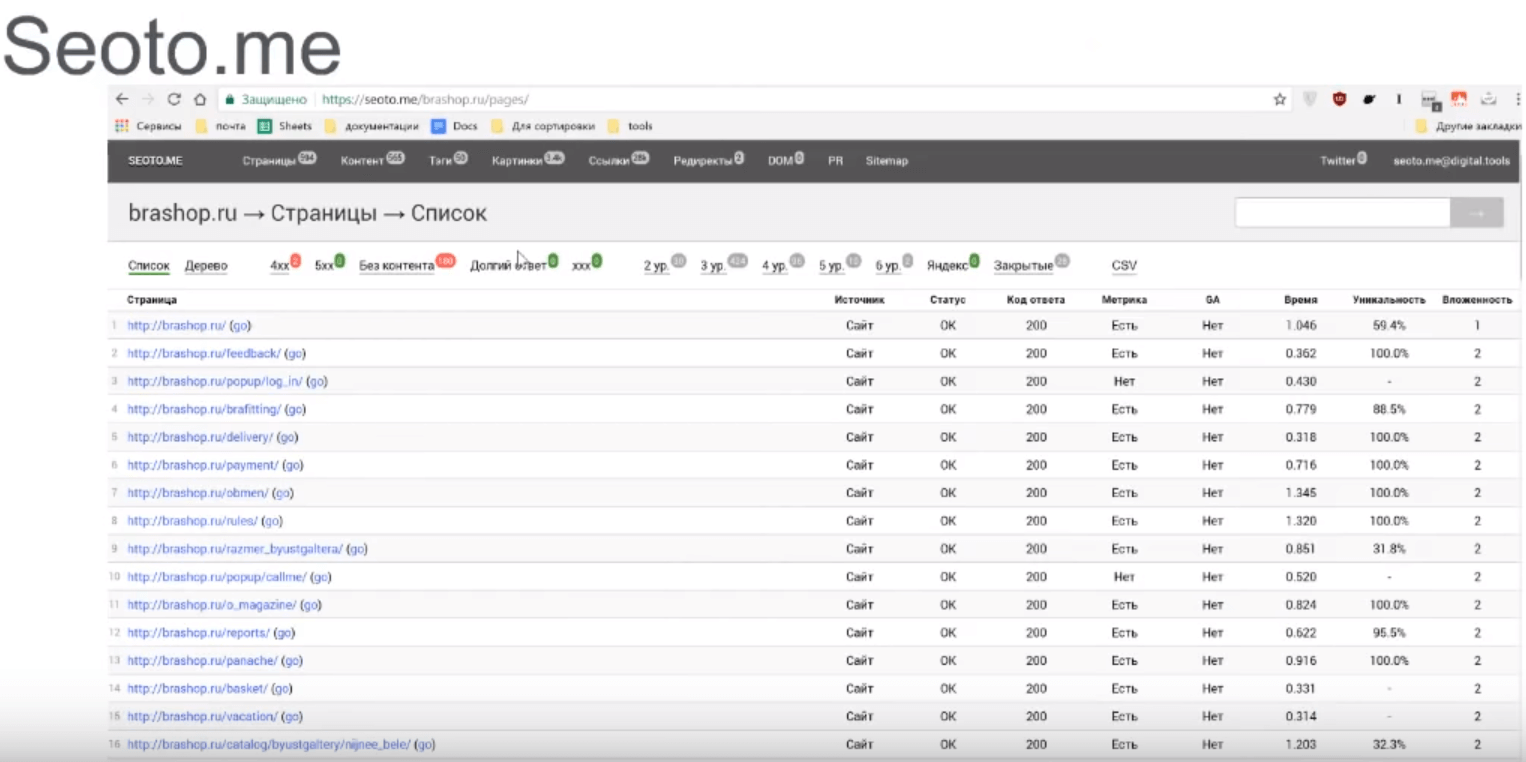

Так выглядит отчет

Seoto.me. Коды ответа сервера

Вас должно заинтересовать, какие страницы дают правильные ответы сервера. Если страница существует – код 200. Если ее нет – код 404. Если страница запрещена к доступу – код 403. Коды, начинающиеся с «пятерки» – коды ошибок сервера.

Сервис поможет быстро анализировать все ваши странички сайта. Удобно посмотреть, на каких страничках нет Яндекс.Метрики и Google Analytics. Можно заметить, насколько давно стоят эти коды.

По общей информации можно более подробно изучить данные на соответствующих вкладках.

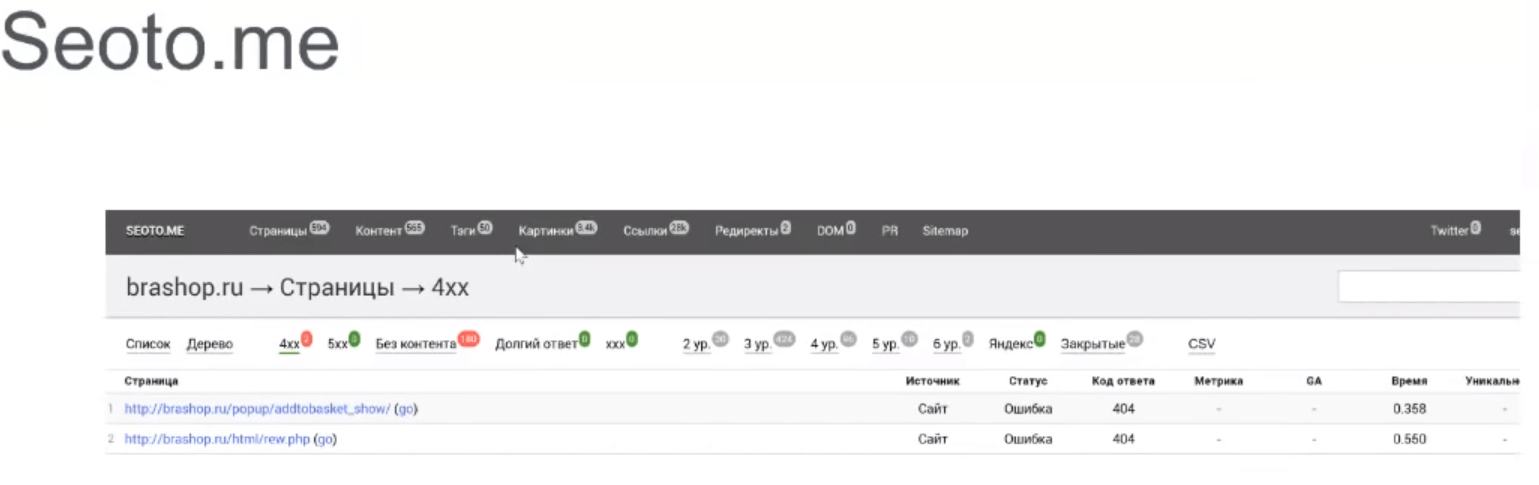

Например, вкладка «4хх» содержит информацию об ошибках. Здесь можно детально посмотреть, какие допущены ошибки и на каких страницах.

Кликая на саму страничку, мы можем увидеть, с какого места ведут ссылки на эту отсутствующую страницу.

500-е ошибки проверяем точно так же. 503 – одна из частых ошибок, это ошибка сервера. Она появляется, когда вы очень быстро сканируете сайт.

Страницы долгого ответа. Страницы без контента

Страницы долгого ответа – это обычно страница либо генерации, либо выдачи. Зачастую проблема в том, что скрипт долго выбирает из базы данных информацию. Поговорите с программистом. Он может придумать, как применить кэширование для решения этой проблемы.

Другой тип страниц – это страницы без контента. Для поисковика очень важен контент. Если у вас в галерее какая-то картинка и нет никакого текста, то поисковик будет воспринимать ее без контента и отображать в соответствующей вкладке. Для поисковиков такие страницы являются низко значимыми, и они, скорее всего, будут исключать их из индексации.

Задача поисковой оптимизации – это добится того, чтобы поисковик высоко показывал сайт по определенным запросам. Зачастую картинки галереи не нужны в индексе. Может быть, лучше их запретить к индексации, если они не являются целью получения трафика или у вас нет запросов, привязанных к этим картинкам.

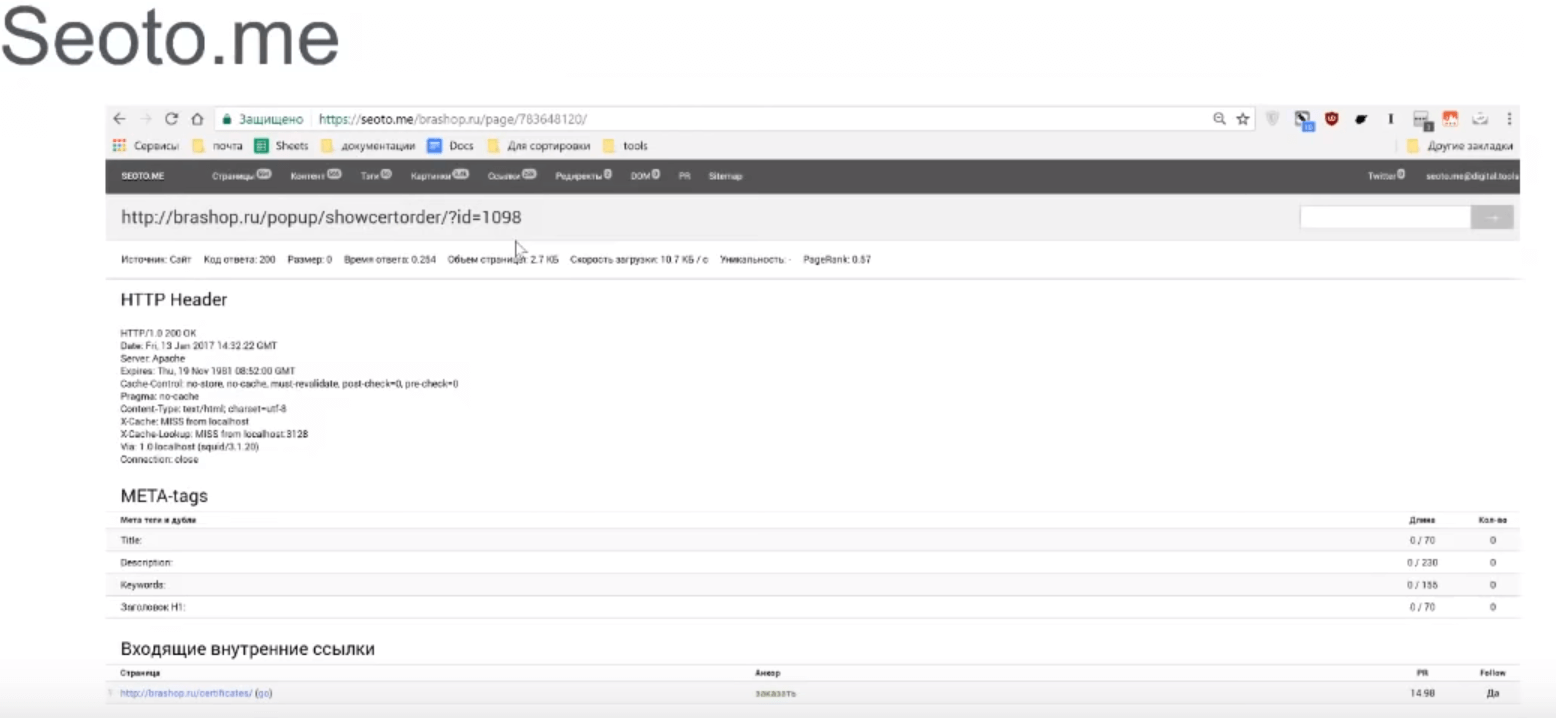

На скриншоте можно увидеть, как выглядит подробная информация: где и какая ссылка расположена, показывается ли анкор и т. д.

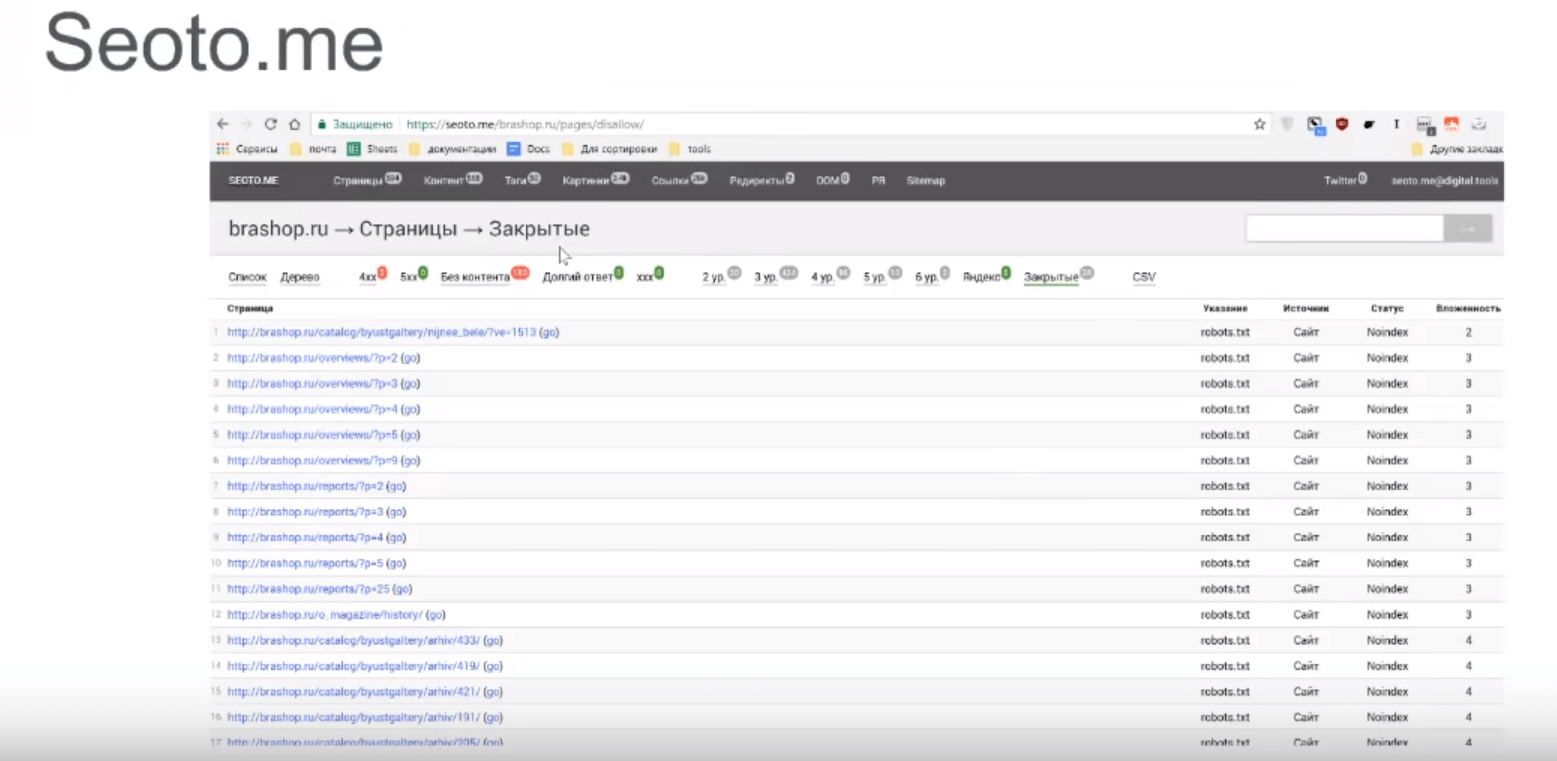

На следующем скриншоте изображены ссылки, закрытые от индексации.

Анализируем, правильно ли закрыты страницы от индексации. Бывает, что случайно закрывают от индексации страницы, которые могут приносить на сайт трафик. Нужно следить за этим и закрывать от поисковиков только определенные страницы.

Уникальный функционал Seoto.me

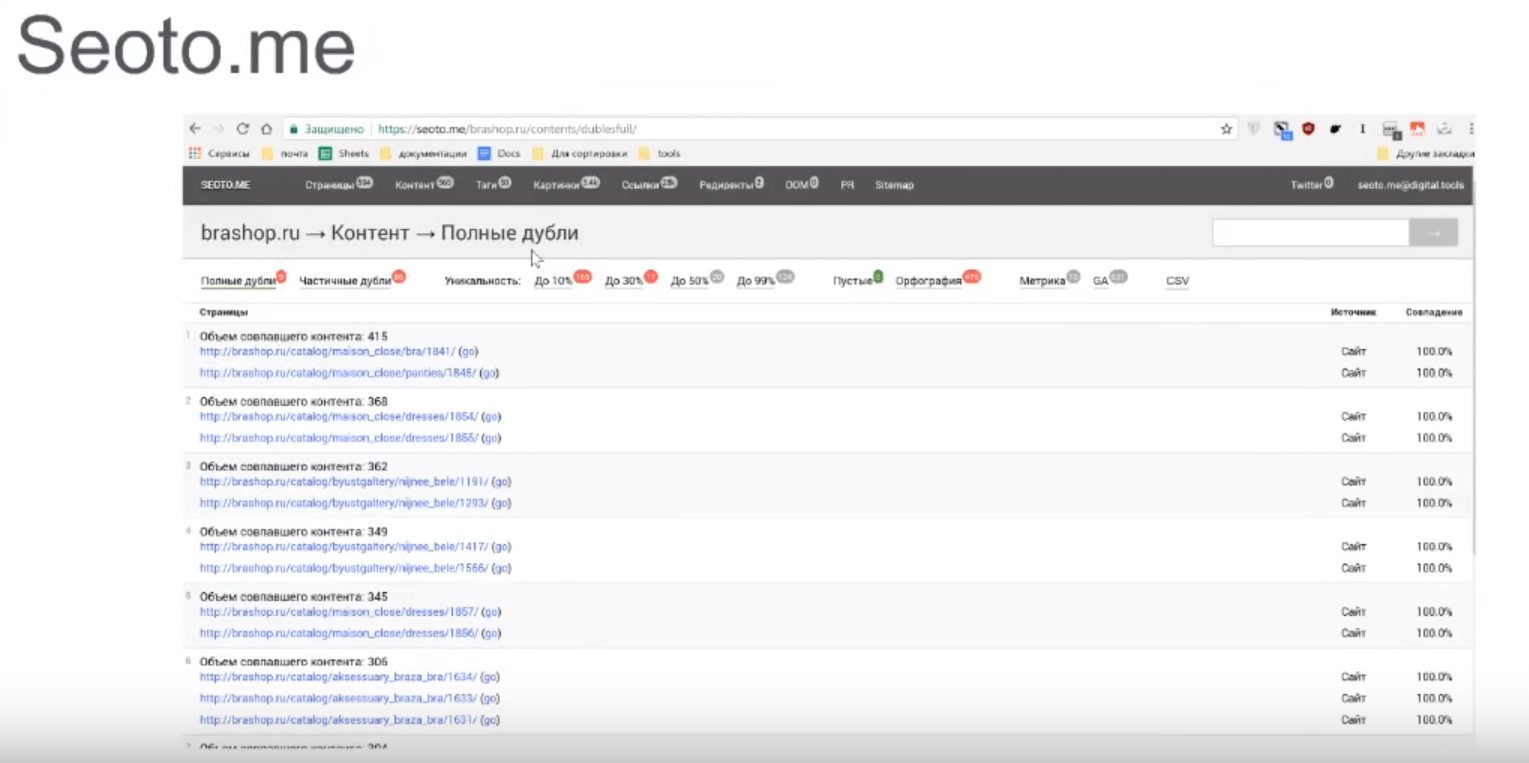

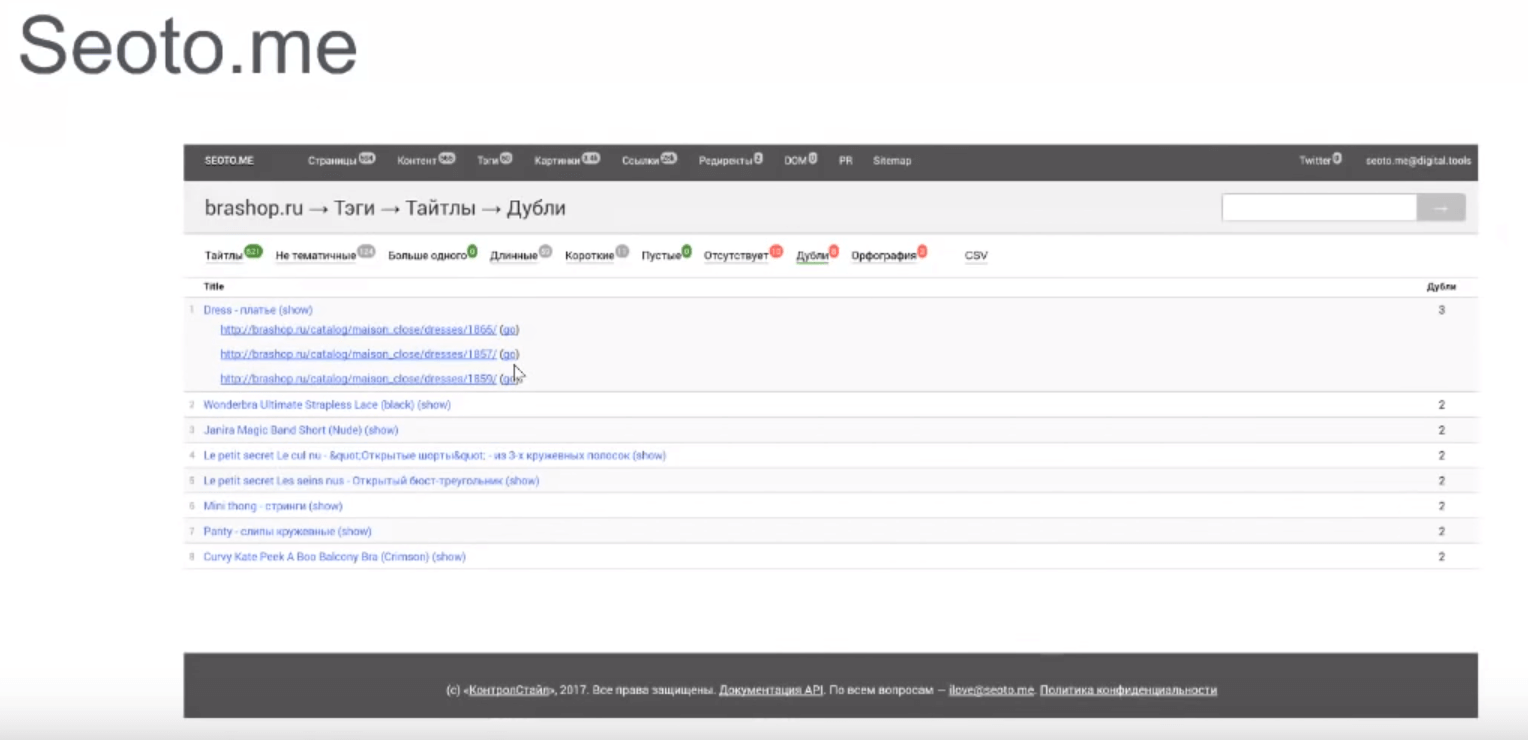

Перейдем к уникальному функционалу, которого нет у десктопных краулеров. Это определение частичных дублей. В данном случае привожу скриншот с полными дублями.

Но для нас очень важны частичные дубли. Там, где контент совпадает не на 100 %, а на 50-99 %. Их обычно не так легко найти. Но с помощью Seoto.me мы можем определить их.

Вам нужно определить, хотите вы использовать данные странички в продвижении своего сайта или нет. И если вы будете их использовать, то нужно на таких страницах размещать уникальный контент, чтобы страница стала высококачественной. Тогда можно рассчитывать на появление поискового трафика.

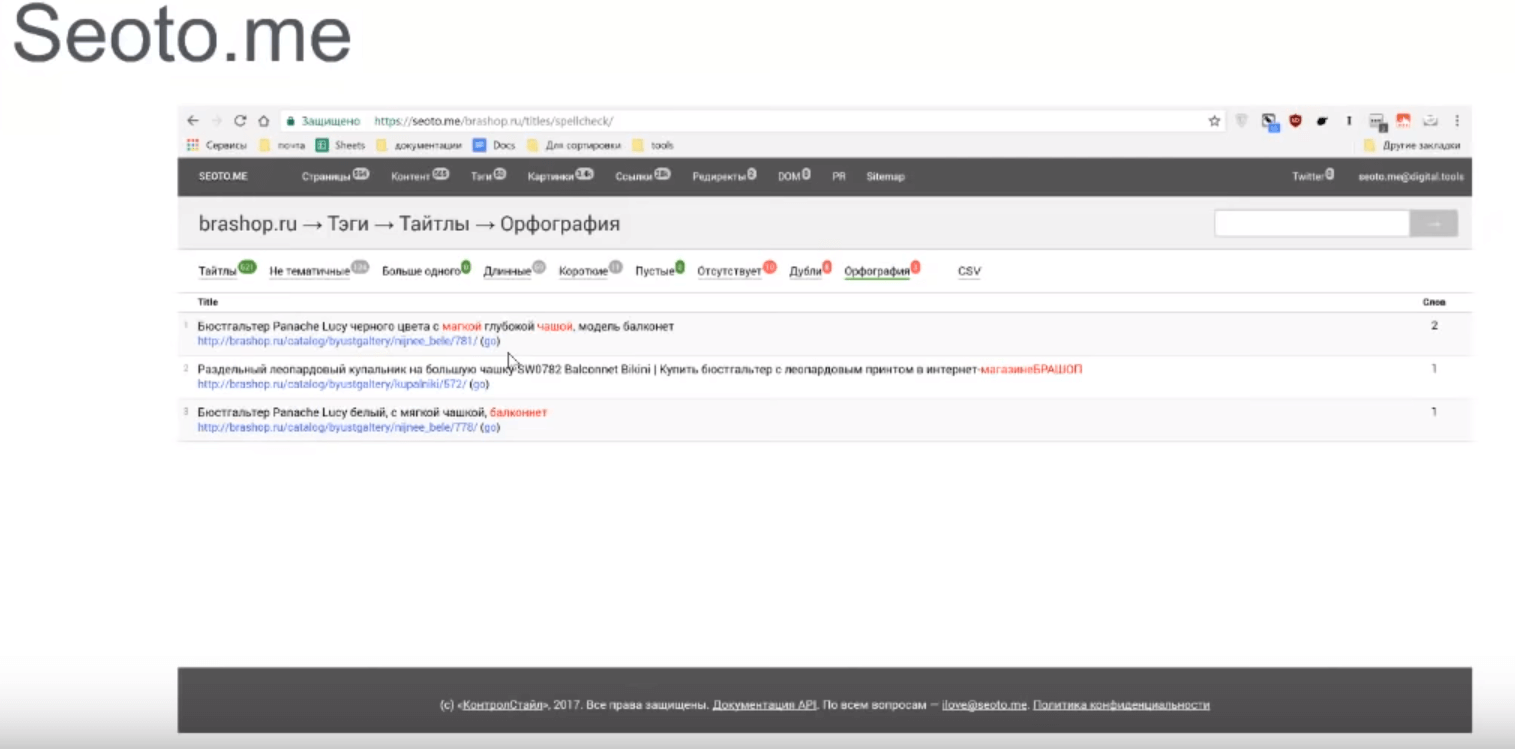

Орфография

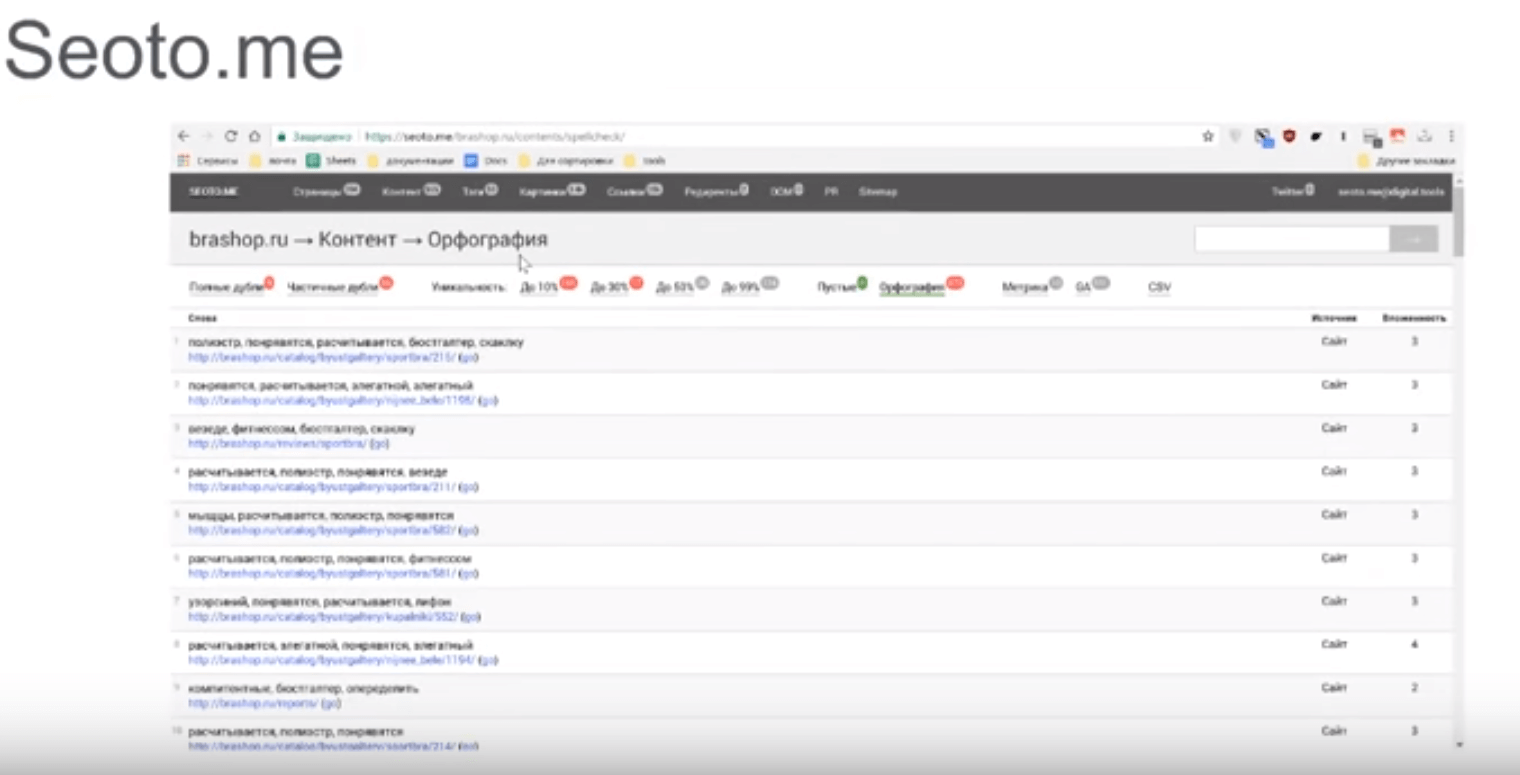

Следующая вкладка – это орфография.

Орфография позволяет посмотреть все опечатки и ошибки, которые найдены на сайте. Показывает ошибки, сделанные не только в контенте, но и в меню, «подвале» или в ссылках.

Как правило, если ссылка размещена в скрытом контенте, то ее пропустить очень легко, а с ней и ошибку. Если опечатка содержится в ссылке, то вы получаете не тот анкор, какой хотите. Он не будет соответствовать вашим ожиданиям, не будет передавать нужный вес. Соответственно, сайт будет ранжироваться ниже.

Теги

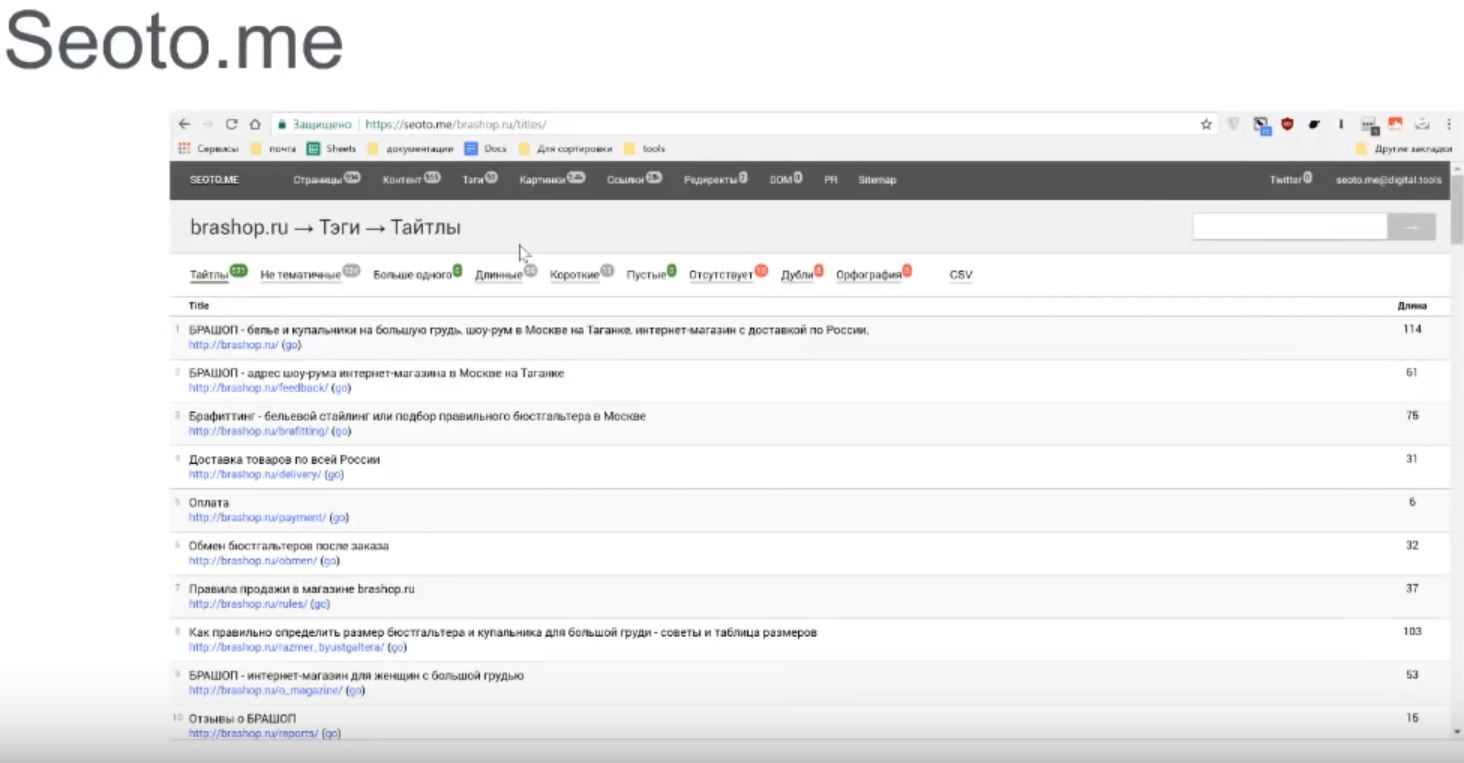

Есть также вкладка «Теги», которые разбиты по группам: тайтлы, хедеры, мета дескрипшны, кейворды.

На сайте должны присутствовать соответствующие теги. Они должны быть заполнены и уникальны в пределах всего сайта. Соответствующие ошибки можно увидеть в разделе «Дубли». Также они должны быть определенной длины.

Если брать Seoto.me, то тайтл должен быть размером от 70 и не слишком длинным.

Бывает, используется автоматическая генерация тайтлов и дескрипшенов. В итоге они получаются сверхдлинными, так как генератор не учитывает максимальную длину. Но это не влияет на ранжирование. Весь хвостик будет скрываться, и пользователи не смогут его прочитать. Но поисковикам ваш сайт будет казаться менее качественным, хотя явного влияния на ранжирование не будет. Но в вебмастере Яндекса и Google вы все равно сможете увидеть предупреждение про длинные тайтлы или короткие и дескрипшны.

Тайтл – очень важен для влияния на кликабельности. При правильном подходе у вас не должно встречаться коротких тайтлов. Кроме того, используйте call to action, составляйте специальные фразы, которые приманивают людей.

Нужно все эти ошибки исправлять. Добавить контент на пустые страницы, добавить тайтлы. Если это дубли, то переписать тексты или теги, чтобы они дублями не являлись.

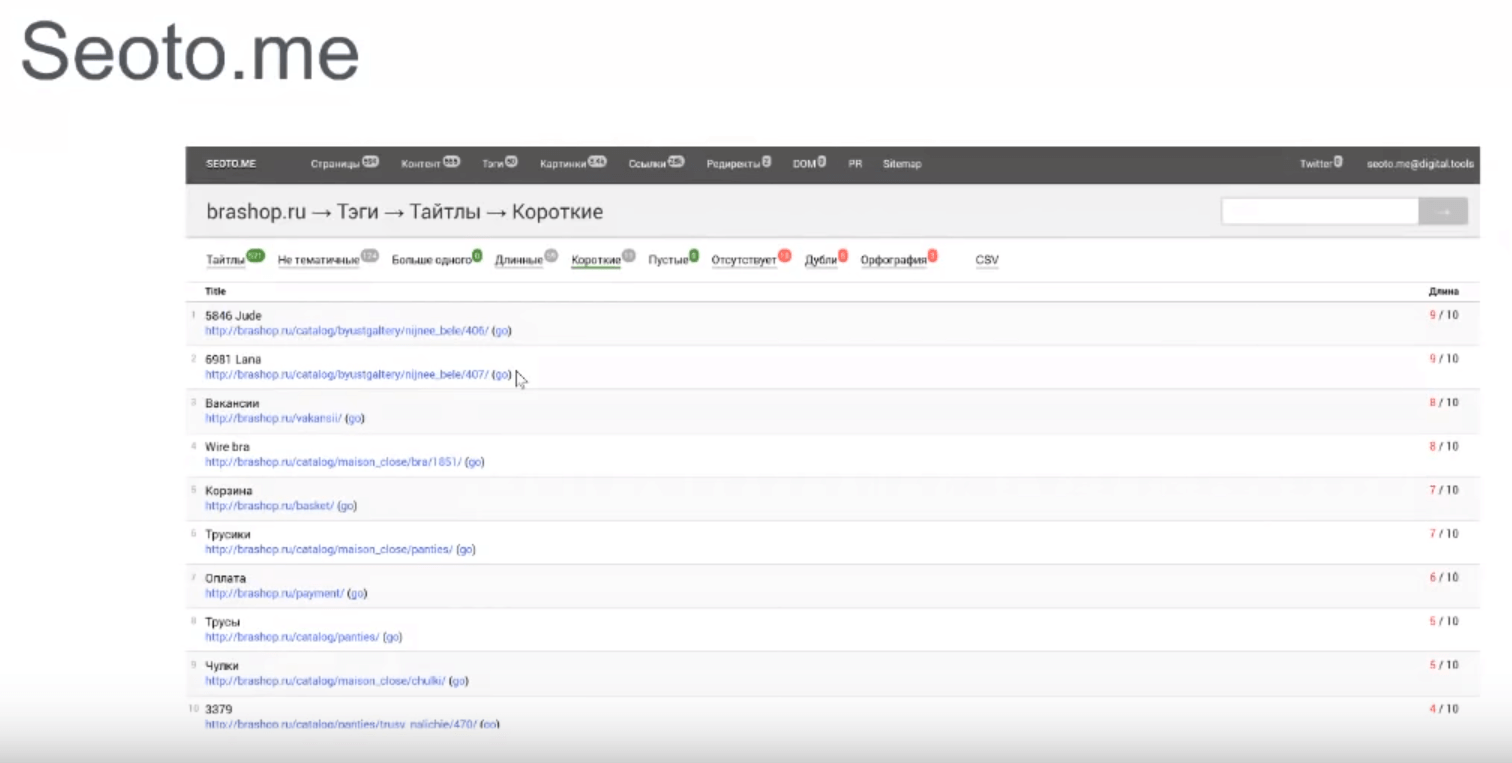

В данном примере приведены примеры коротких тайтлов:

Последняя строчка весьма показательна: 3379 – автоматически сгенерированный артикул, который попал в генерацию страницы. Есть также названия на английском, которые надо переписать на русском языке.

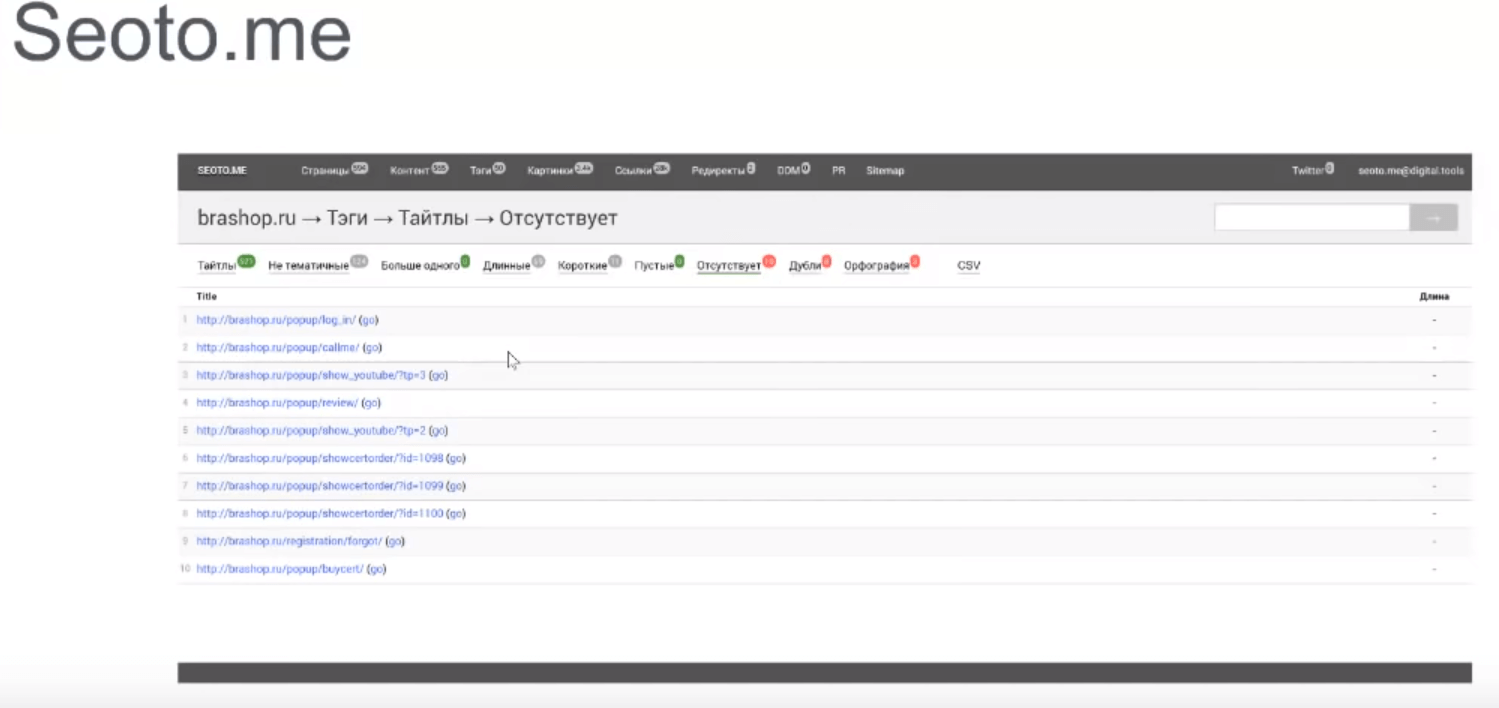

На примере можно заметить, что нет названий. Это технические урлы. Первая ссылка – это логин, далее – показ видео и т. д. Тайтлы тут не указаны, чтобы они не попали в индекс. Эти страницы лучше всего закрыть от индексации в файле Robots.txt.

В Seoto.me удобный интерфейс для сканирования. Если вы считаете, что ошибка, которую нашел сканер, не критичная, то вы можете ее игнорировать. Этот функционал лучше использовать, чтобы технические ссылки не примелькались с течением времени, и вы случайно в массе ссылок не пропустили настоящую ошибку.

Также можно сделать сканирование сайта регулярным и сравнивать ошибки ежедневно. По данным строится график. Можно посмотреть, как изменяется количество ошибок, старые ошибки не игнорируются. Находим дубли тайтлов и даем задачу на исправление. Можно указать, чем отличается товар: по цене, цвету и т. д.

Не забываем про опечатки:

Очень удобно выявлять ошибки, так как колоссально экономится время по сравнению с ручной обработкой.

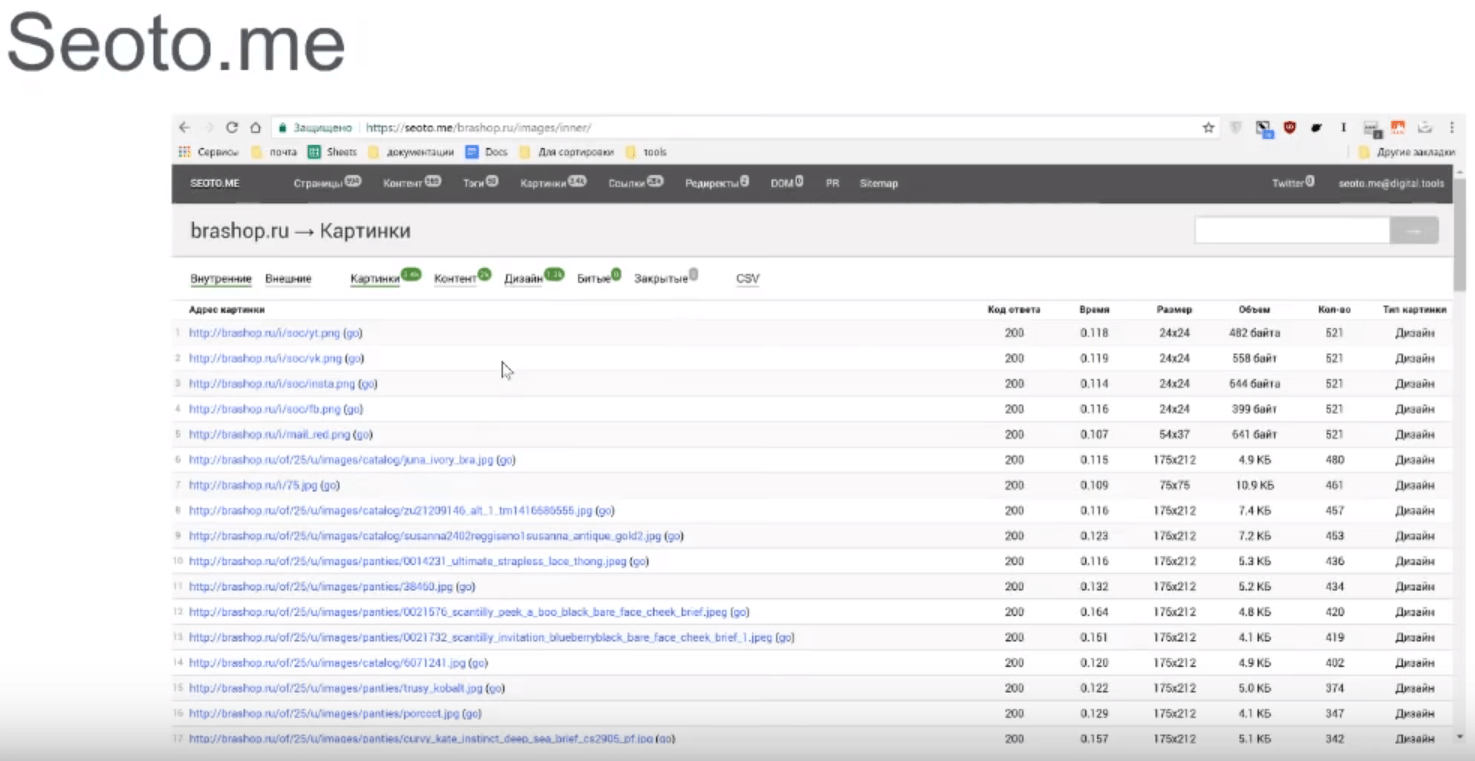

Картинки

Самое полезная для SEO-специалиств информация – битые картинки. Смотрим вкладки внешние и внутренние. Это картинки, которые уже не существуют, или ссылка устарела. Особо критичные внешние картинки, так как их контролировать сложнее. Старайтесь переносить к себе все изображения.

Сканер проверяет все картинки. После отчета можно решить, что с ними делать: оптимизировать, найти правильные ссылки и т. д. Для SEO-специалиста важно, чтобы не было технических ошибок, битых ссылок на пустые картинки.

Ссылки

Page Rank показывает передающие вес на ваш сайт по снижению. Если у вас в топ-10 попадают технические страницы, то скорее всего их надо закрыть. Например, на личный кабинет, политику конфиденциальности, персональные данные и т. д. Если они не нужны для индексации – закрывайте их в Robots.txt.

Следует смотреть на внутренние и внешние битые ссылки. Внутренние битые ссылки часто бывают сквозные. Проверяем и ищем такие ошибки, которые обязательно нужно исправить. Сканер показывает, на каких страницах встречаются такие ссылки.

Следующая страничка – это данные о mod_rewrite. Это специально сгенерированные написания. Таких страниц на сайте нет и не должно быть. Если на такие страницы сервер отдает статус 200 и делает вид, что все в порядке, то тогда такая ситуация может привести к появлению дублей. Желательно, чтобы дублей не существовало. Это нужно исправлять.

Система собирает информацию о разного вида некорректных отображениях страниц. Например, отображаются ссылки, в которых есть заглавные символы. В ссылках должны быть только строчные символы. Последний URL, которому приписали лишний символ, а сервер отдал код 200. Это неправильно. Исправляйте такие ошибки – ставьте редиректы, меняйте ссылки и т. д.

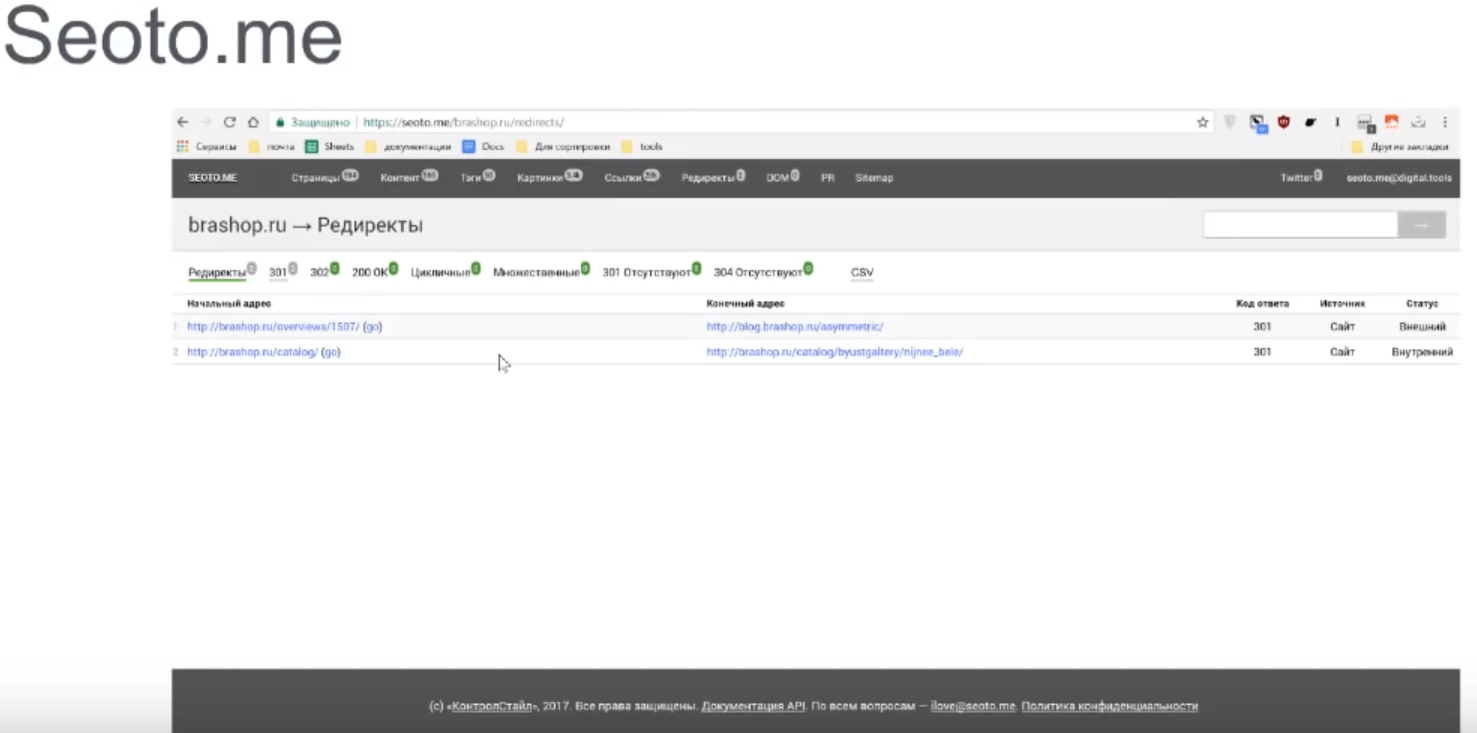

Редиректы

Последний раздел, который нам нужен для SEO-аудита – это редиректы, которые бывают двух типов: цикличный и множественный.

Циклический редирект перебрасывает с одной страницы на другую. Бывает, что цикл состоит из нескольких переадресаций сразу. Если встречаются цикличные редиректы – это плохо. В таком случае поисковик не может найти нужную информацию.

Множественные редиректы. Поисковики плохо воспринимают более восьми редиректов подряд. В таком случае они прекращают сканирование по этим редиректам. Также это бессмысленно и плохо, так как замедляет работу сайта. Имеет смысл сократить такую цепочку, сделав редирект сразу с начальной страницы на конечную.

Seoto.me помогает находить всевозможные ошибки на сайте. Далее составляете ТЗ и передаете SEO-специалистам.

Яндекс.Вебмастер

Панель Яндекс.Вебмастера – это официальная информация о том, что думают о вашем сайте поисковики. Безусловно, большим преимуществом является важная информация о наложенных на вас санкциях. Если на сайт наложен бан, то вся информация будет видна.

Яндекс очень серьезно относится к банам и образцово-показательным способом наказывает оптимизатора. В Google ситуация полегче, так как он не сразу накладывает санкции, а ждет исправлений. И только потом применяет штрафные санкции.

Правда, в Яндексе есть служба техподдержки, а в Google ее нет. Если работаете с украинскими сайтами, то вам повезло – не будете сталкиваться с банами в Яндексе. А если работаете с российскими, то вам нужно учитывать правила игры Яндекса.

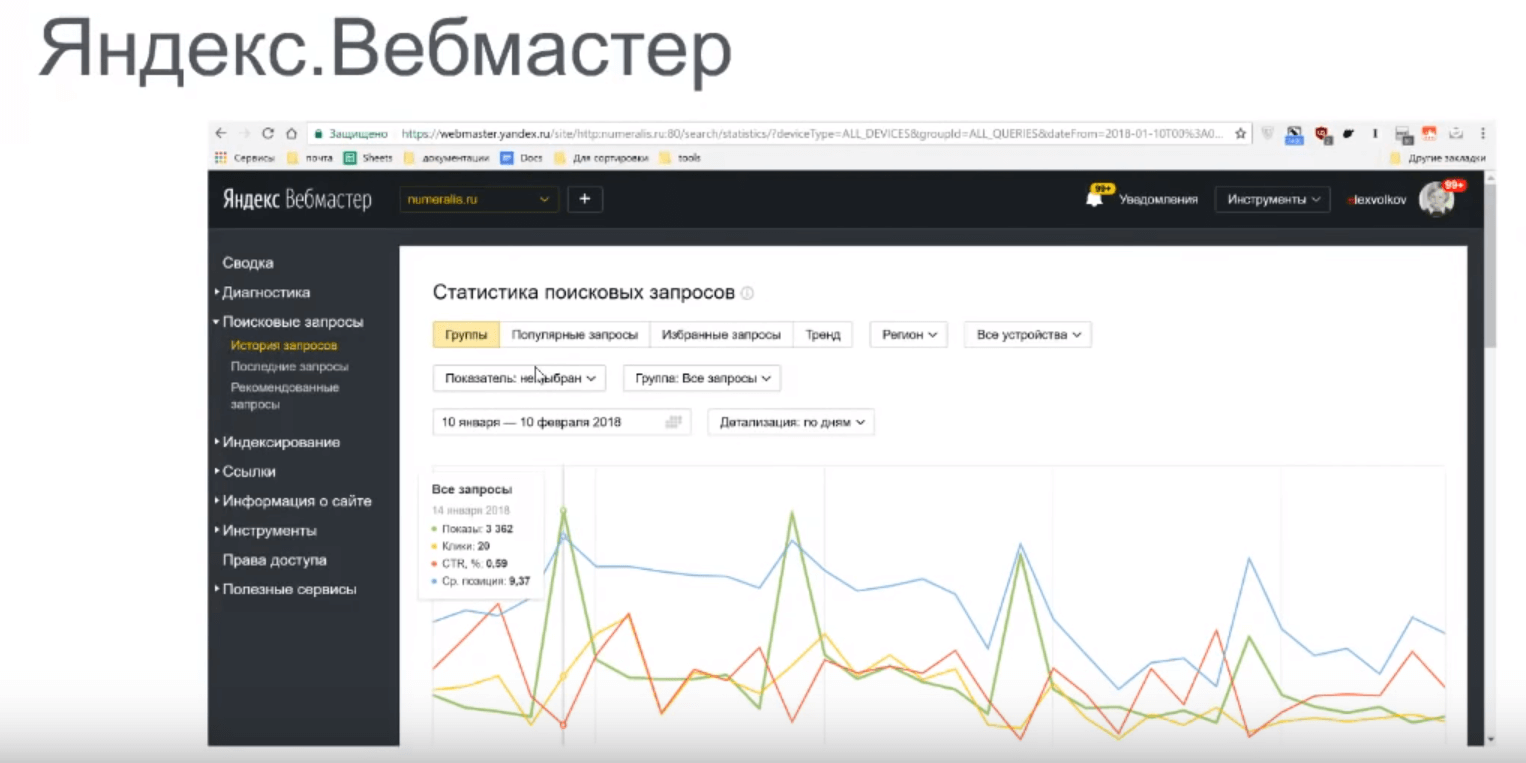

Поисковые запросы

Сводка «Диагностика сайта» содержит информацию по сайту о наложенных санкциях. Выдается предупреждения, если у вас есть ошибки. Ошибки бывают фатальные – бан, санкции, критичные. Они на ранжирование не влияют, но мешают индексации. Ошибки желательно исправить, но, например, с длиной тайтла ошибки не критичные.

Сводка «Поисковые запросы» позволяет просмотреть данные, по которым ранжируется сайт. Подобный раздел в Google обладает еще большей полезностью, потому что внутри сервиса, как правило, данные зашифрованы, и посмотреть их можно только в этом разделе. А вот Яндекс все запросы держит открытыми.

Обратите внимание, если сайт показывается по каким-либо запросам, но по нему не было никаких переходов на эту страницу, то значит проблема скорее всего в сниппете. Просмотрите статистику по таким запросам, посмотрите, как выглядит сниппет в реальности, и что можно исправить, чтобы увеличить количество переходов.

Можно делать различные срезы: смотреть, как потенциально будет расти или падать трафик в будущем. Это вкладка «Тренды». Можно смотреть срезы по регионам, по устройствам, по определенным группам, ввести выбранные запросы. И отслеживать только по этим запросам. Мониторить, конечно, по выбранным запросам неудобно в панели вебмастера, так как все равно не получите полных данных (они ограничены по объему). Пользуйтесь внешними сервисами – это будет гораздо удобнее и эффективнее.

Вкладка «Последние запросы» – показывает, по каким последним запросам перешли на сайт. Рекомендованные запросы – это запросы, по которым сайт мог бы получать хороший трафик, где виден потенциал роста. Это полезный раздел, чтобы улучшить свой сайт. Достаточно вписать в контент эти фразы, чтобы вы получали сразу уже какие-то посещения.

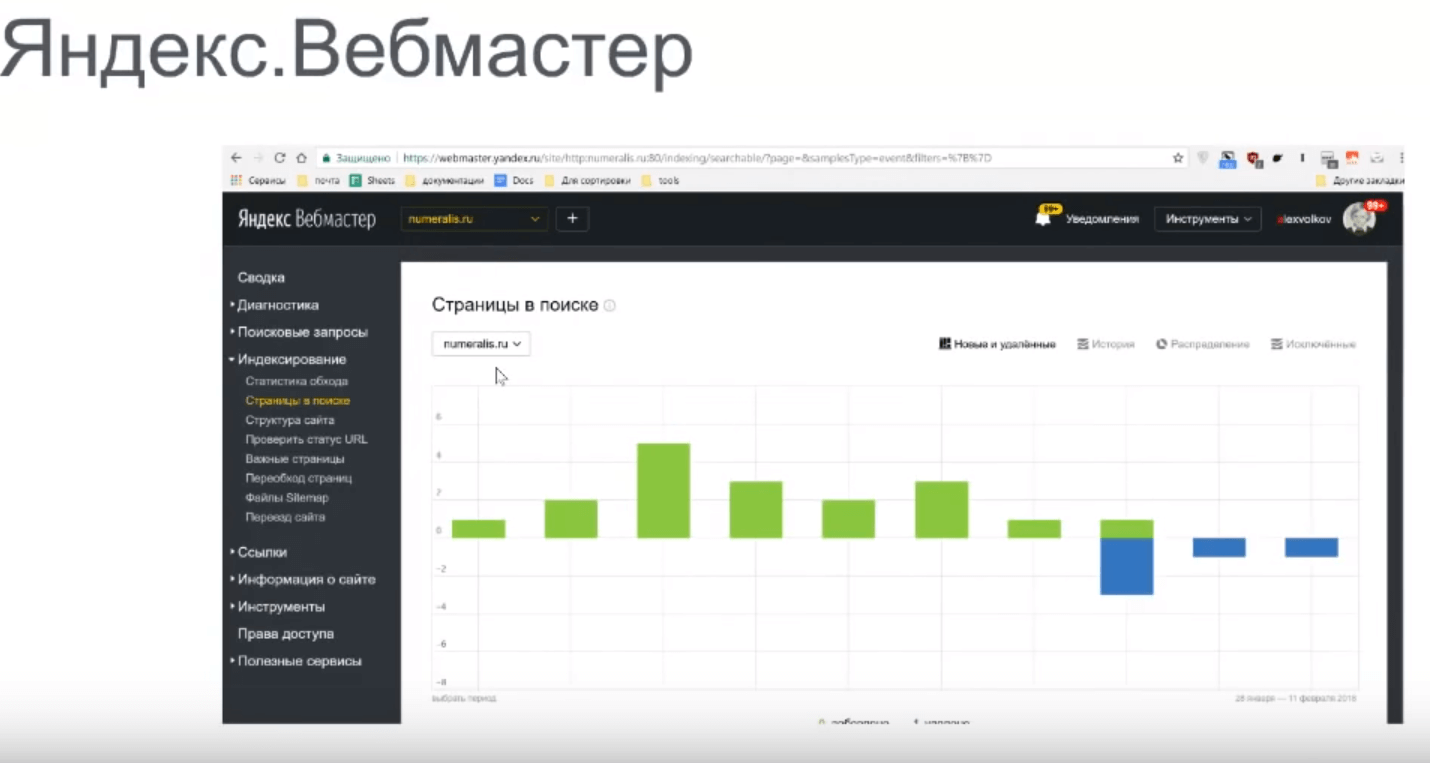

Индексирование

Следующая сводка – Индексирование. Тут можно увидеть, как индексируется сайт, насколько давно и как часто заходил краулер поисковика, какие странички в поиске, график, который показывает, какие страницы появились, а какие выпали. На примере видно, что новые странички не появляются, а много страниц выпадает из индекса.

Нужно посмотреть, какие страницы выпали из индекса. Эта информация доступна.

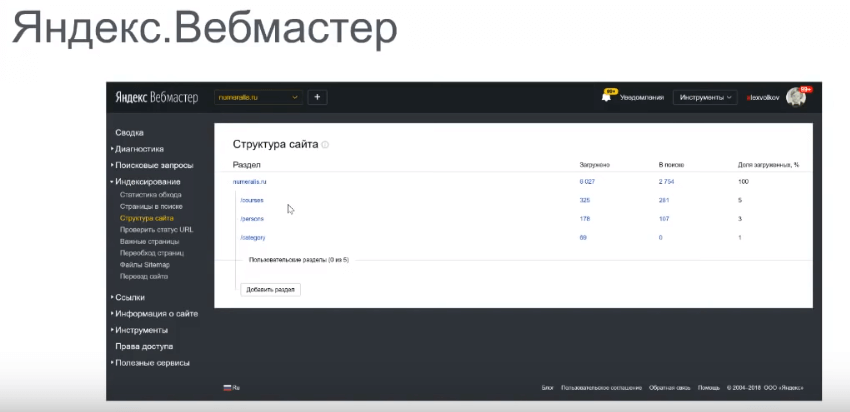

Следующий раздел – Структура сайта. Он позволяет добавлять страницы в список и потом быстро смотреть по ним данные. Можно добавить до пяти разделов.

На вкладке «Проверить статус URL» можно посмотреть код, который отдает ваш сервер. Важные страницы – это страницы, которые вы заносите в список, и поисковик мониторит их отдельно, показывая статус, контент, сниппеты. Можно пользоваться, если вы не хотите тратить деньги на внешние инструментарии.

Далее – вкладка «Переобход страницы». С помощью этого функционала можно быстро проиндексировать страницы. Обычно этот период составляет пару дней.

Sitemap – раздел, где вы можете добавить карту сайта.

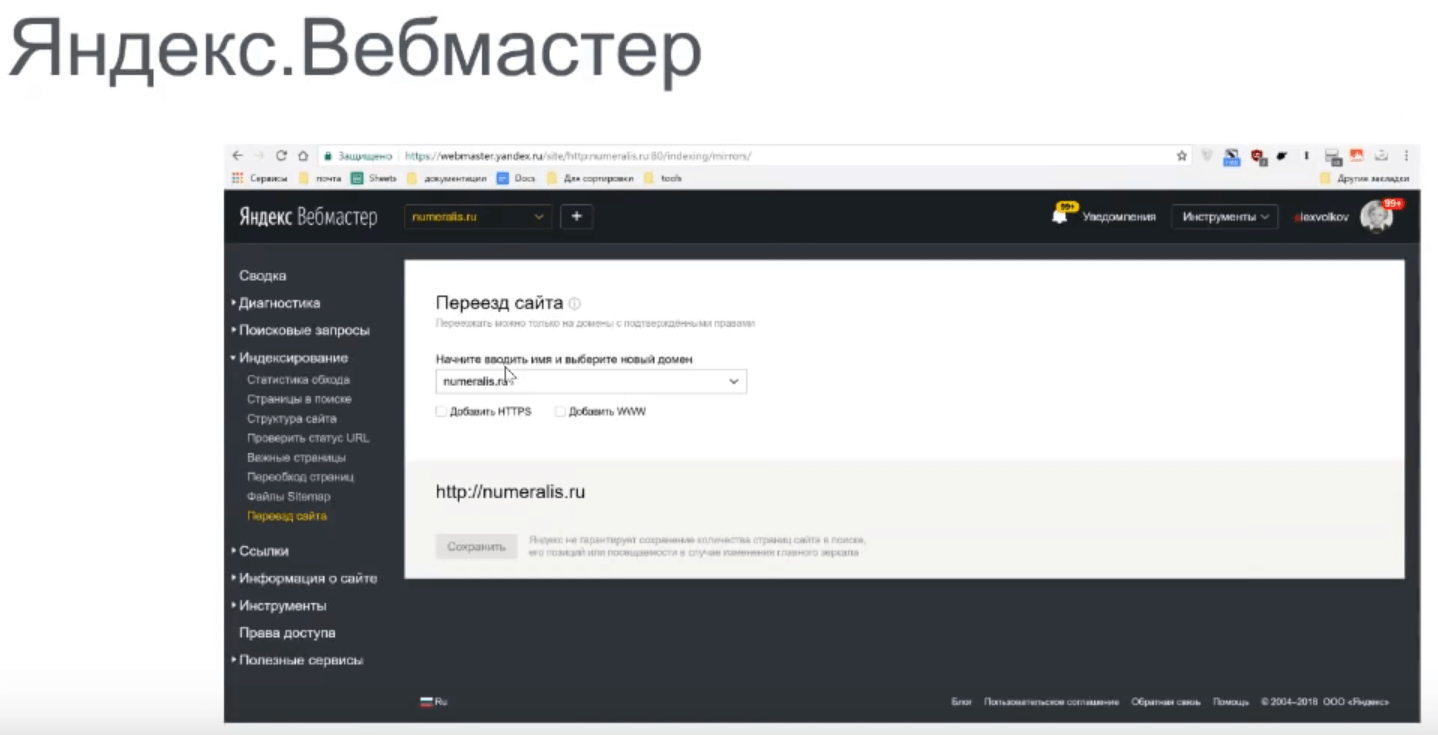

И полезнейший интерфейс – переезд сайта. Вы можете изменить основной домен только в нем, потому что Яндекс перестал учитывать в Robots.txt инструкцию host. Можно выбрать переезд с http на https, домен с www на без www. Но они должны быть проиндексированы. Поисковик сопоставит, что это зеркала одного и того же сайта, и их можно скреплять.

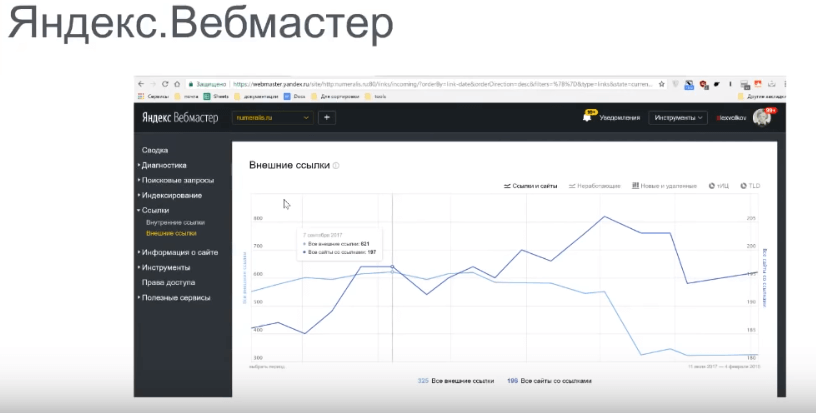

Ссылки

Внутренние и внешние ссылки. В разделе можно просмотреть все ссылки. Это очень важная информация – внешние сервисы не заменят ее, так как эта информация от первоисточника.

Если вы зайдете в Ahrefs и просканируете ссылки, а потом зайдете в Google и Яндекс.Вебмастер и возьмете ссылки оттуда, то получите три разных набора ссылок, так как каждый сервис их видит по-своему. Для Яндекса важны ссылки, которые он нашел и верит, что они существуют.

Турбо-страницы

Можно убедить Яндекс показывать Турбо-страницы – это аналог AMP-страниц в Google. Это мобильная версия страницы с контентом, который позволяет быстро отобразить информацию в поиске. Если в Google AMP – это микроразметка, то в Яндексе.Турбо странички – это RSS-фид, который представляет собой контент вашего сайта, ссылки для Perl, рекомендованные логины, которые генерируют Турбо-странички. Рекомендую пользоваться этим сервисом, потому что поисковик тщательно продвигает эту технологию. На мобильных устройствах сайт будет получать больше трафика, а это очень важно, так как мобильный трафик постоянно растет.

Мобильные страницы

Вкладка «Проверка мобильных страниц» очень важна, так как отличается от всех подобных сервисов. Дело в том, что список параметров, по которому Яндекс проверяет адаптивность, отличается от гугловского. И он больше. Например, тут есть размер шрифтов, на который Mobile friendly от Google не ругается. Если вы продвигаетесь в России, то проверяйте мобильность своих страничек еще и в Яндексе.

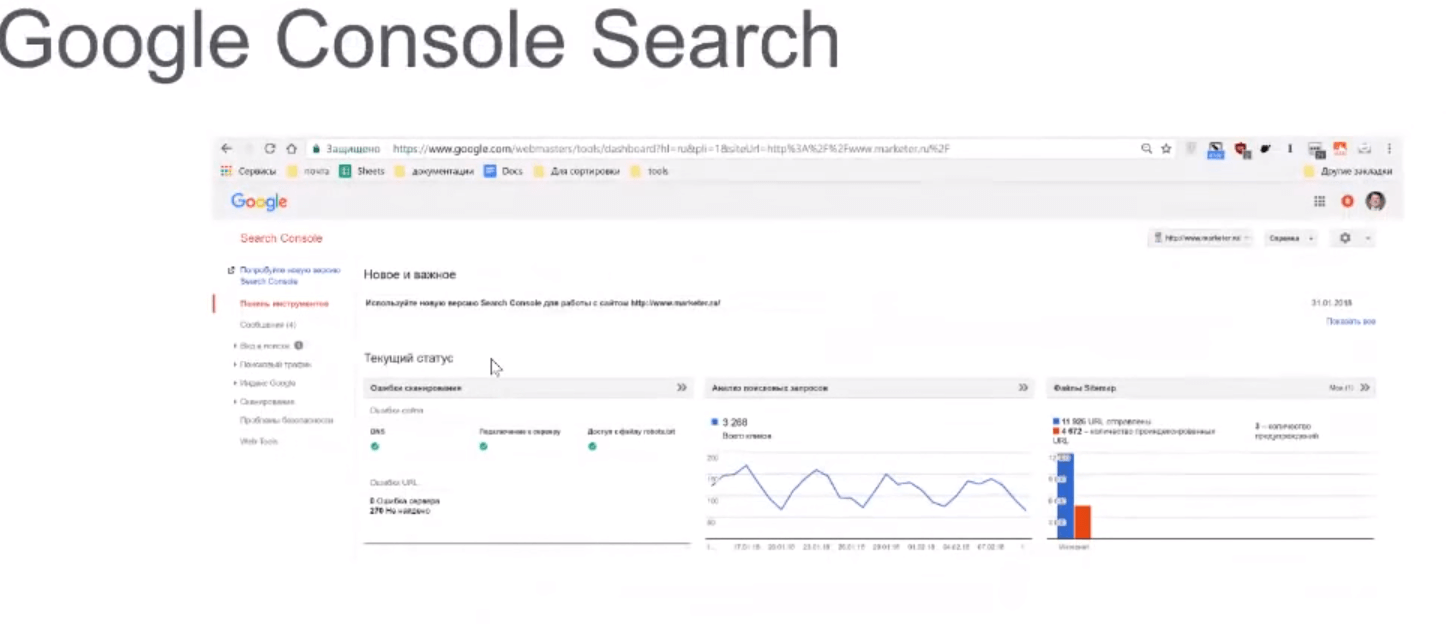

Google Search Console

Индексация

Google Search Console показывает, как проиндексирован сайт в поиске.

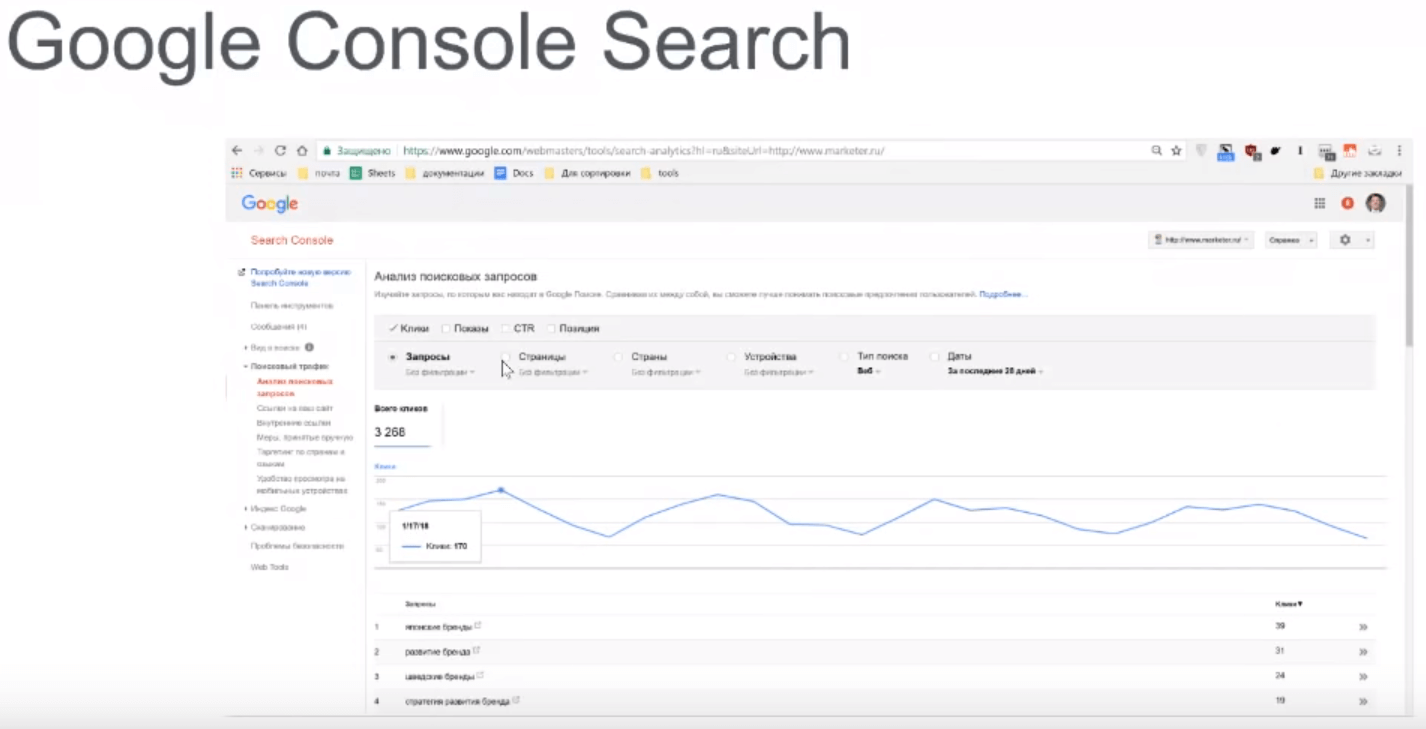

Анализ поисковых запросов

Можно узнать, по каким фразам показывается сайт. Чтобы данные были доступны в Google Analytics, необходимо сделать интеграцию с Google Search Console. Это даст возможность посмотреть список конкретных фраз, по которым ваш сайт появлялся в поиске.

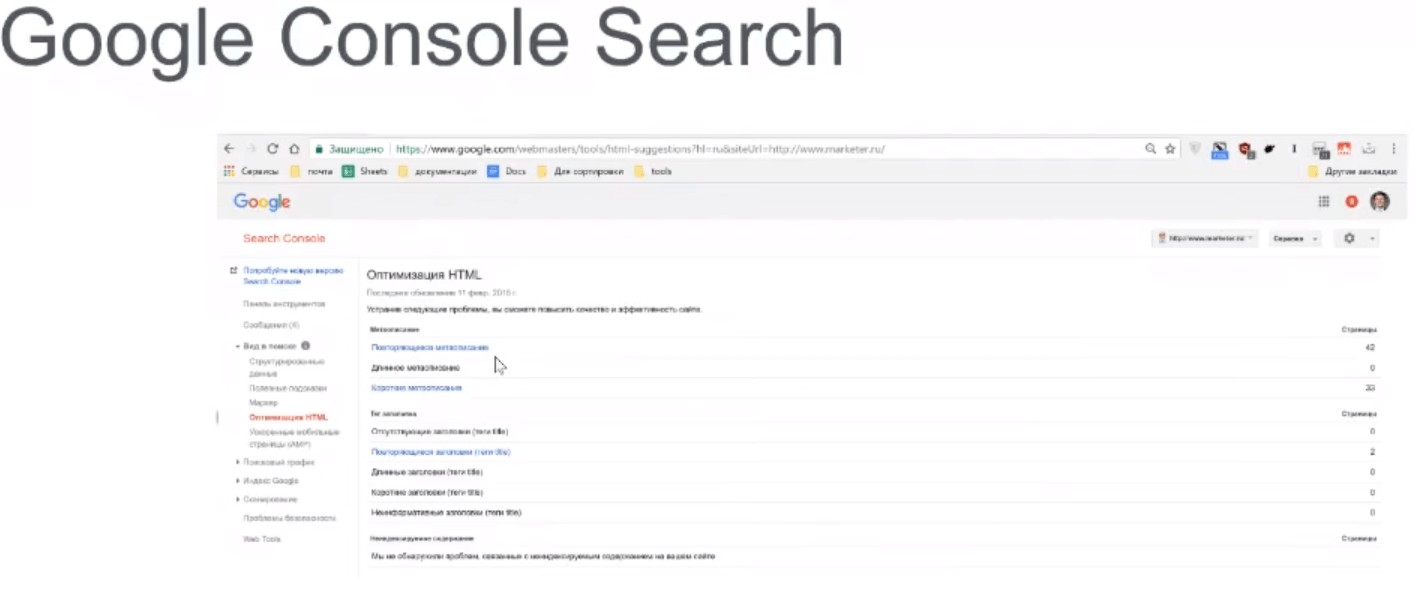

Оптимизация HTML

Один из разделов, которые можно увидеть – это оптимизация HTML. Очень сокращенный вариант Seoto.me, где вы можете увидеть результаты сканирования сайта. Google показывает рекомендации, где повторяются неуникальные теги.

Обычно такую информацию удобно смотреть во внешних краулерах, которые покажут данные более подробно и в расширенном виде.

Инструментарий анализа поисковых запросов раскроет, по каким запросам был показан ваш сайт. Рекомендую использовать вкладку CTR, чтобы посмотреть, как сформирован сниппет. Если у странички очень низкий CTR, то это означает, что ваш сниппет непривлекательный, пользователи на него не кликают. Обязательно анализируйте эту статистику.

Сканирование

Принятые вручную меры– это как раз санкции, которые наложены на сайт. Всевозможные баны, фильтры и причины, по которым они наложены, будут отображаться этом разделе. Один из возможных минусов этого раздела – это то, что он откладывает ошибки, которые очень неточно сформулированы. Например, ваш сайт нарушает требования к вебмастерам. В таком случае Google дает ссылку на страницу, где описаны все возможные причины ошибок.

Проверяйте все, начиная от вирусов и заканчивая агрессивностью размещения рекламы. Если у вас такая ошибка, то это, возможно, самое плохое, что может с вами случиться – так как нет никакой конкретики. Придется изучить много литературы, испробовать много способов, прежде чем удастся вывести сайт из-под фильтра.

Индексация показывает, сколько страниц находится в индексе. Насколько быстро попадают страницы в индекс. Хорошо ли сканирует сайт поисковик. Не должно быть резких всплесков и падения до нуля – значит, сервис не справляется с нагрузкой.

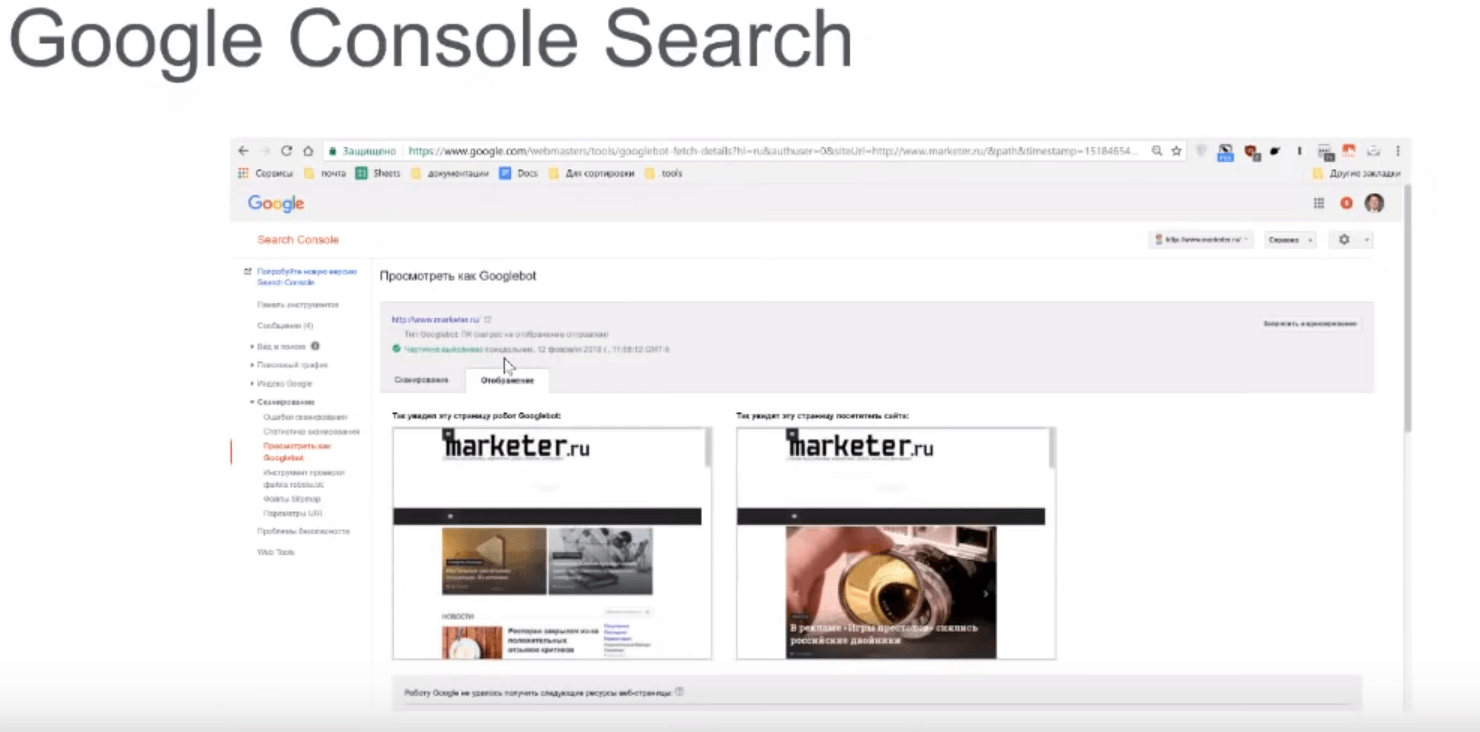

Следующий раздел – «Посмотреть как Googlebot». У него есть два режима. Первый режим – отобразить. Страница отображается по-разному, потому что могут быть запрещены к индексации Javascript-файлы. Это плохо, так как скрипты, которые влияют на отображение, должны быть доступны для поисковика. Правильно отображается версия страницы только в том случае, если все необходимые стили и скрипты открыты для поисковика.

Следите, чтобы ваш отображаемый контент существенно не отличался по содержанию от того, который вы показываете для поисковика. Если будет определена такая ошибка, то поисковик может наложить на сайт фильтр. Это так называемый клоакинг, когда манипулируя Javascript, вы скрываете от поисковика часть контента, например, часть ключевых слов.

Когда будете смотреть отображение страницы, то после сканирования появится кнопка «Добавить в индекс». Есть два режима добавления – добавить только текущую страницу или добавить текущую страницу и все, на которые она ссылается. Добавить одну страничку можно 500 раз в месяц. Добавить страничку и все, на которые она ссылается, можно 20 раз в месяц.

Преимущество этого сервиса перед Яндексом – страница попадает в индекс практически моментально. Нажали «Добавить в индекс» – и через 5 минут видите, что она уже в индексе и можно проводить ранжирование.

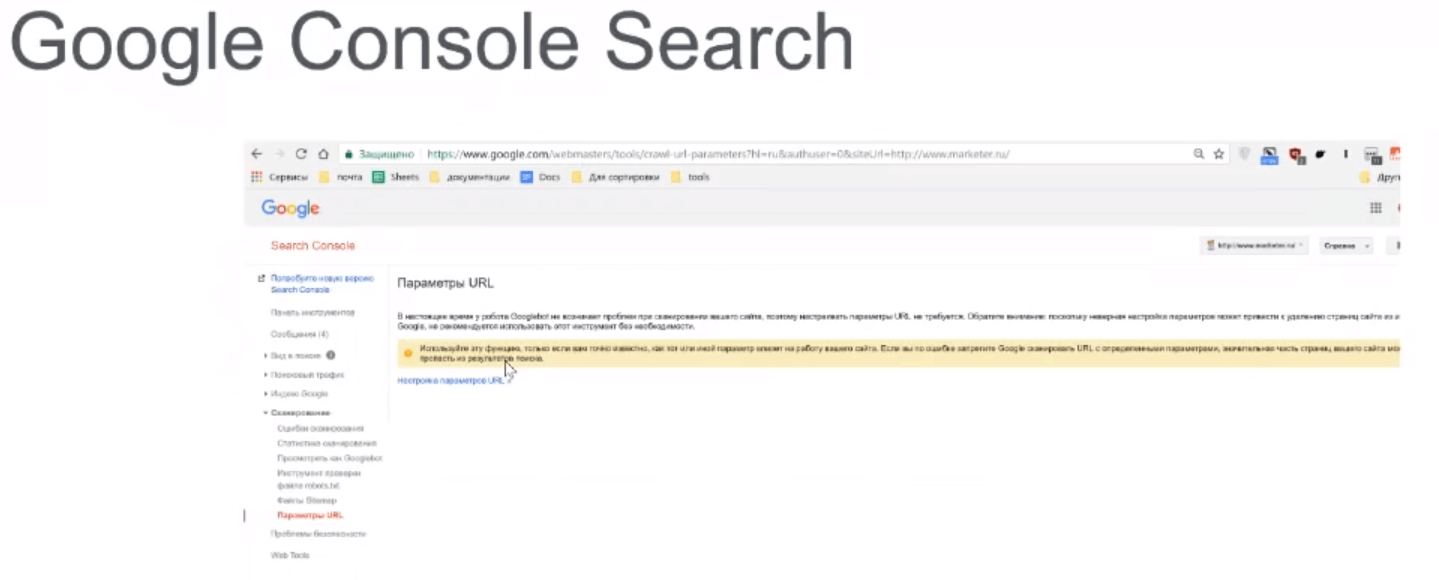

Параметры URL – это аналог яндексовского Сlean Param. Нужны для очистки Get-параметров. Это UTM-метки, пагинация, сортировка и т. д.

Если вы знаете, что сайт генерирует некоторые Get-параметры, которые вы не хотели бы видеть в индексе, то на этой страничке можно сразу их запретить к индексации.

Советую изучить рекомендованный состав SEO-аудита.

Ответы на вопросы

– Какие отличия оптимизации под Яндекс и Google?

– Если вы работаете на оба рынка, то вам придется учитывать обе поисковых машины. Вы же все равно будете доступны обоим поисковикам – надо учитывать эту особенность. Отличается очень тонкими вещами. Например, в Яндексе очень критична текстовая релевантность. Работая с текстовой релевантностью и ключами, можно добиваться существенного роста позиций. В Яндексе очень важна накрутка поведенческих факторов, как инструмент оптимизации. Критически важно в Яндексе, если ваш домен или ваше название бренда очень часто встречается в сети. В таком случае будете ранжироваться по большому количеству разнообразных запросов. В Яндексе может быть на высоких позициях страница без контента. В Google такой фокус не пройдет. Кроме того, для Google критичны ссылки. Если у вас нет ссылок, вы не будете на высоких позициях. В сложных конкурентных тематиках это точно.

– Рейтинг Ahrefs.

– Рейтинг Ahrefs отображает количество сайтов, которые на вас ссылаются, и их уровень. На рост рейтинга влияет количество доменов и оценки, которые получили те домены, которые ссылаются на вас.

– Как быть с продвижением интернет-магазина из Украины в ПС Яндекс?

– Если вы пытаетесь продавать в Яндексе, то только клиенты, которые пользуются VPN, смогут воспользоваться услугами вашего интернет-магазина. А доля таких пользователей мала. Самое главное, что они еще и будут работать под IP-адресом, который определяется какими-нибудь Нидерландами или Германией. Поэтому в этом нет особого смысла.

– Sape.

– Ссылки актуальны до 2018 года. Можно покупать, но качество доноров упало, так как Яндекс начал бороться с ссылочной продажей. Покупая ссылки на данный момент, нужно быть в разы внимательней.

Если вы хотите научиться оптимизировать сайты и стать суперменом-сеошником, то можем предложить курс «SEO-оптимизация: продвижение сайтов в поисковых системах». После курсов проведете аудит сайта и создадите стратегию продвижения. Научитесь анализировать конкурентов, сформируете семантическое ядро. Прогнозируя результаты продвижения, сможете оптимизировать бюджет. Привлекательно? Записывайтесь!

Авторизуйтесь, чтобы оставлять комментарии